轻松获取网页下载地址:抓取工具教程

优采云 发布时间: 2023-03-24 12:15随着互联网的发展,越来越多的网站提供各种资源的下载服务。对于用户来说,获取所需资源的最直接方式就是通过下载链接进行下载。然而,有些网站并不提供直接下载链接,这时候我们就需要使用抓取工具进行网页中下载地址的抓取。本文将为大家详细介绍如何使用抓取工具进行网页中下载地址的抓取。

一、什么是抓取工具

抓取工具是一种可以在网页上自动获取信息的程序。在网络爬虫应用领域,也称为爬虫、蜘蛛、机器人等。它可以模拟人类在浏览器上访问网页的行为,通过解析HTML代码获取所需信息。

二、常见的抓取工具

目前市面上常见的抓取工具有很多种,如Python中的BeautifulSoup、Scrapy框架等;PHP中的Snoopy、Goutte等;Java中的Jsoup等。这些工具都有各自特点和适用场景。下面我们以Python BeautifulSoup为例进行讲解。

三、Python BeautifulSoup简介

Python BeautifulSoup是一个解析HTML和XML文档的第三方库,它可以将HTML或XML文档转换成一个树形结构,并且提供了一些简单易用的方法来遍历这个树形结构,从而获取我们需要的信息。

四、安装Python BeautifulSoup

在使用Python BeautifulSoup之前,需要先安装它。在命令行中输入以下命令即可:

pip install beautifulsoup4

五、基本用法

下面我们以一个网页中下载地址抓取的例子来讲解Python BeautifulSoup的基本用法。

假设我们要抓取一个网页中的下载链接,首先需要通过requests库访问该网页,代码如下:

import requests

from bs4 import BeautifulSoup

url ='https://www.example.com'

response = requests.get(url)

html = response.content

soup = BeautifulSoup(html,'html.parser')

其中,url为待抓取网页的URL地址,response.content为该网页的HTML源代码。接下来,我们使用BeautifulSoup对该HTML源代码进行解析,并获取其中的下载链接,代码如下:

download_links =[]

for link in soup.find_all('a'):

if link.has_attr('href') and 'download' in link['href']:

download_links.append(link['href'])

其中,soup.find_all('a')是BeautifulSoup提供的方法,用于查找所有'a'标签;link.has_attr('href')和' download' in link['href']分别用于判断该'a'标签是否有href属性和是否包含'download'字符串;link['href']则是获取该'a'标签的href属性值。最后将所有符合条件的下载链接保存到download_links列表中。

六、注意事项

在使用抓取工具进行网页中下载地址的抓取时,需要注意以下几点:

1.遵守网站的使用规定,不得进行非法操作;

2.不要过度抓取,以免对网站造成压力和影响用户体验;

3.在使用Python BeautifulSoup等工具时,要注意版本兼容性和代码优化。

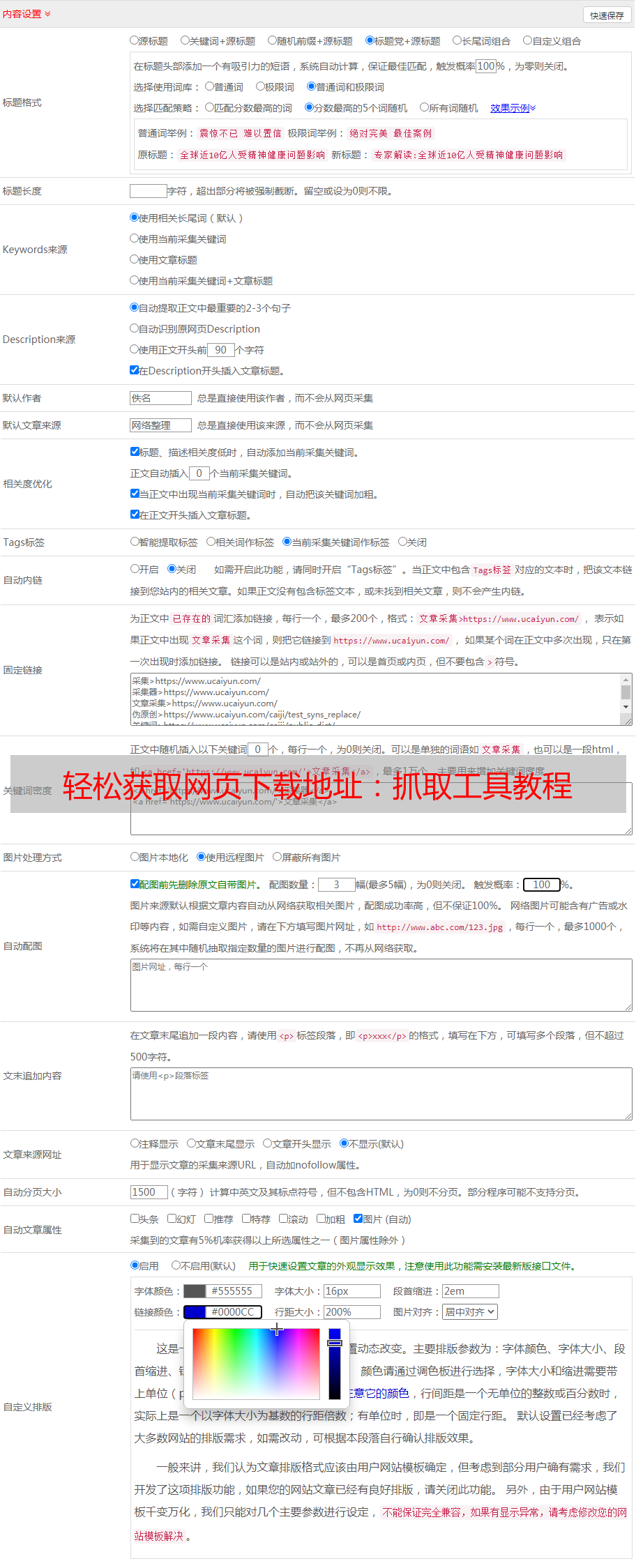

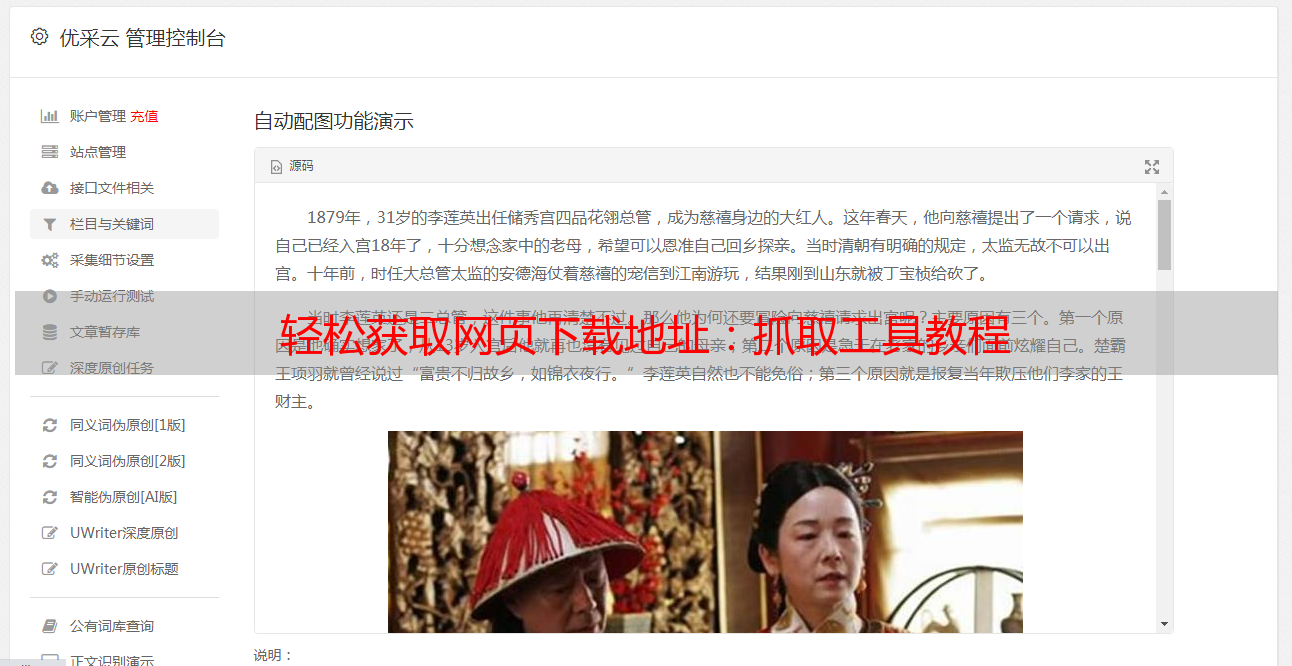

七、优采云

如果您需要更加专业的抓取服务,可以选择优采云。优采云提供高效、稳定、安全的数据采集服务,支持多种数据源和多种数据格式,并提供全方位的数据处理和分析服务。同时,优采云还拥有自主研发的数据抓取工具和数据解析引擎,可以轻松应对各种复杂场景。更多信息请访问:www.ucaiyun.com。

八、SEO优化

在进行网页中下载地址的抓取时,要注意SEO优化。具体来说,可以从以下几个方面入手:

1.合理布局页面结构,使搜索引擎能够更好地识别网页内容;

2.使用合适的关键词和描述信息,增加搜索引擎检索到该网页的概率;

3.提高页面访问速度和用户体验度,减少页面跳出率。

九、总结

本文详细介绍了如何使用Python BeautifulSoup进行网页中下载地址的抓取,同时还介绍了抓取工具的基本概念和常见类型。在使用抓取工具时,需要注意遵守网站规定和代码优化等问题。如果需要更加专业的抓取服务,可以选择优采云。最后,也提醒大家在进行网页中下载地址的抓取时,要注意SEO优化,提高网页的搜索排名和用户体验度。