模拟蜘蛛抓取,轻松学习9个网络爬虫技巧

优采云 发布时间: 2023-03-24 11:20在网络爬虫中,模拟蜘蛛抓取是一种常用的方式。本文将从基本原理、工作流程、常见技巧等9个方面,详细讲解模拟蜘蛛抓取的全部内容。

一、基本原理

模拟蜘蛛抓取是通过程序代码模拟浏览器行为,自动化地访问网站并获取网页数据的过程。其基本原理是通过HTTP协议请求网站服务器,获取相应的HTML页面,并通过解析HTML页面中的链接地址实现自动跳转和递归抓取。

二、工作流程

模拟蜘蛛抓取的工作流程包括初始化、请求网站、解析页面、存储数据等多个步骤。其中,初始化阶段主要是进行一些参数配置和环境准备;请求网站阶段则需要构建HTTP请求头和请求体,并发送给目标网站;解析页面阶段则需要对HTML页面进行解析,提取出需要的信息;存储数据阶段则需要将获取到的数据存储到数据库或者文件系统中。

三、常见技巧

在模拟蜘蛛抓取过程中,有一些常见技巧可以帮助我们提高抓取效率和数据质量。例如,使用代理IP可以避免被封禁;使用多线程可以加快抓取速度;使用反爬虫技术可以有效防止被网站屏蔽。

四、请求头设置

在发送HTTP请求时,设置合适的请求头是非常重要的。一方面可以模拟浏览器的行为,避免被网站屏蔽;另一方面也可以传递一些重要的参数信息。例如,设置User-Agent字段可以指定访问来源;设置Cookie字段可以实现登录状态保持。

五、页面解析

页面解析是模拟蜘蛛抓取中最为关键的环节之一。通过解析HTML页面,我们可以提取出需要的数据,并进行存储和分析。常见的页面解析方式包括正则表达式、XPath和CSS Selector等。

六、数据存储

在模拟蜘蛛抓取过程中,数据存储也是非常重要的一个环节。我们需要将获取到的数据保存到数据库或者文件系统中,以便后续分析和利用。常见的数据存储方式包括MySQL、MongoDB和Hadoop等。

七、优化策略

优化策略是模拟蜘蛛抓取中不可忽视的一个方面。通过优化策略,我们可以提高抓取效率、降低被封禁的概率、提升数据质量等。常见的优化策略包括降低抓取频率、设置请求头信息、使用代理IP等。

八、SEO优化

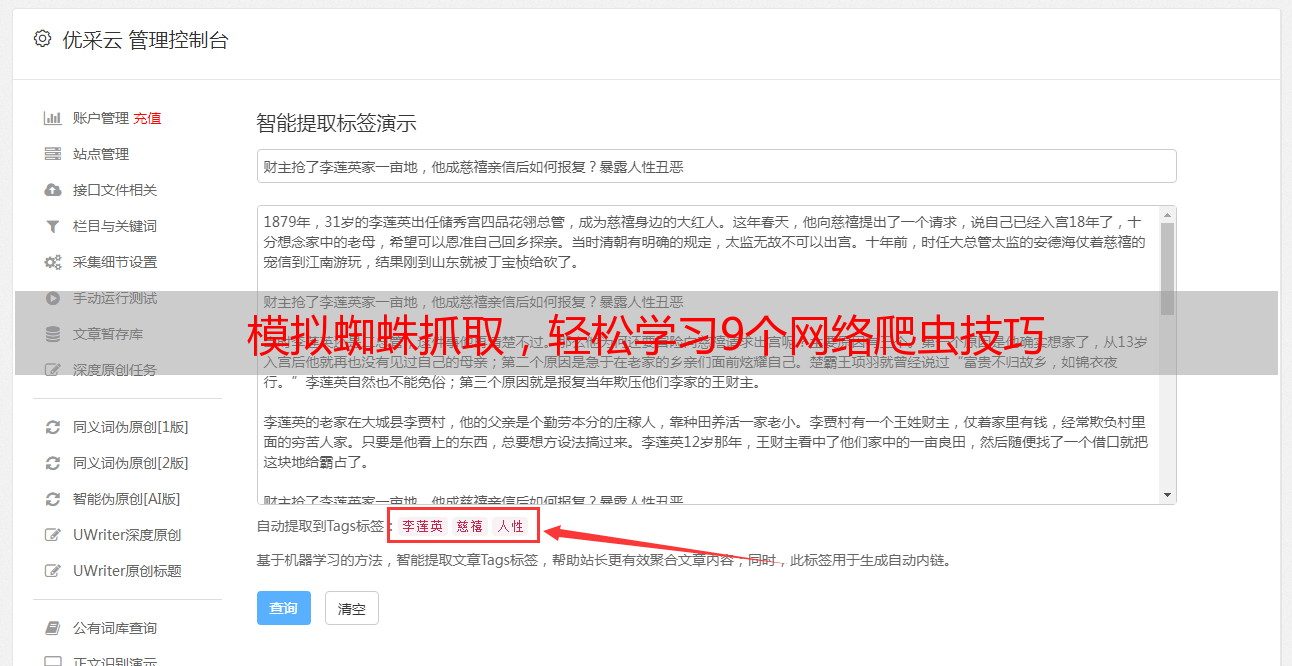

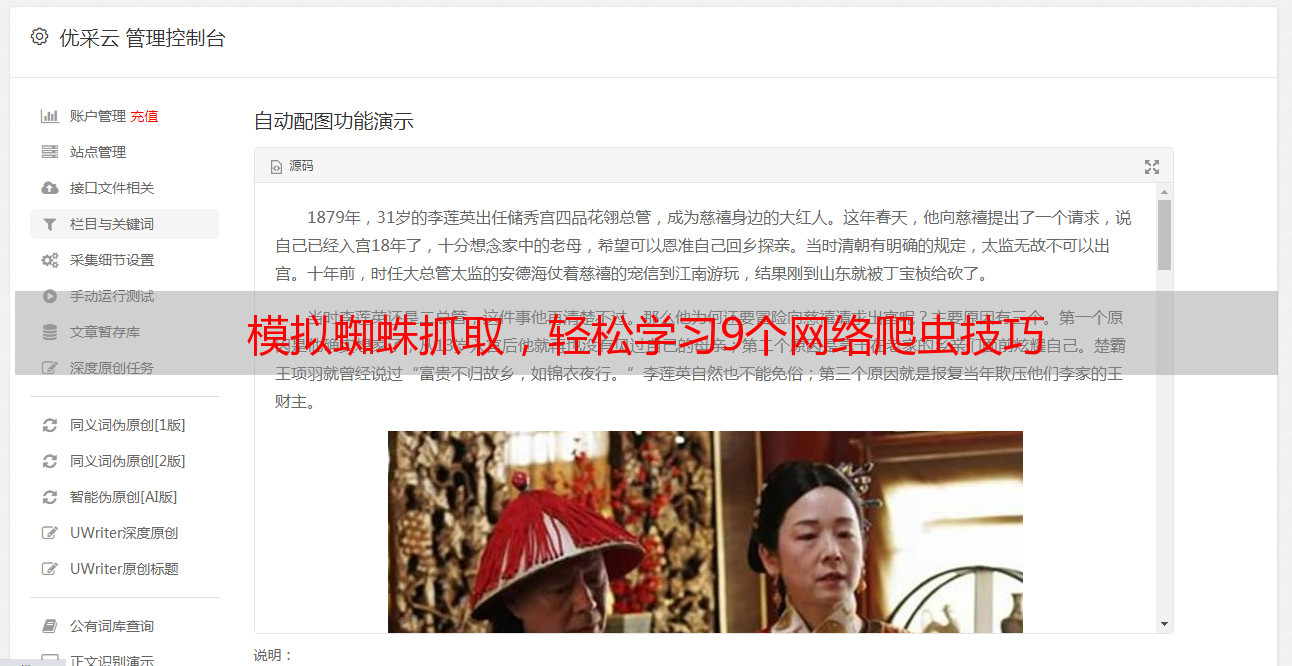

模拟蜘蛛抓取技术在SEO优化中也有着重要的应用。通过模拟搜索引擎蜘蛛的行为,我们可以帮助网站提高排名和流量。常见的SEO优化策略包括设置合适的标题和关键词、提高页面质量和内容价值等。

九、结语

模拟蜘蛛抓取技术是一项非常重要的网络爬虫技术,在数据采集和SEO优化中都有着广泛的应用。通过本文的介绍,相信读者已经对模拟蜘蛛抓取有了更深入的了解。如果想要了解更多关于网络爬虫和数据采集方面的知识,可以关注优采云(www.ucaiyun.com)这个专业的数据采集平台,我们将为您提供最全面、最专业的服务!