PHP防爬虫技巧大揭秘:完美应对爬虫攻击

优采云 发布时间: 2023-03-23 21:17PHP作为一种十分流行的后端语言,它的应用范围越来越广泛。但是,在应用过程中,我们也会遇到各种各样的问题。比如,网站被恶意爬虫攻击,导致数据被恶意抓取、用户隐私被泄露等等。那么,如何防止这种情况的发生呢?下面就为大家介绍一下PHP防止爬虫的方法。

1.验证码

2. IP限制

3. User-Agent限制

4. Referer限制

5. Robots.txt文件

6.请求频率限制

7.动态生成页面

8.采用SSL证书

9.服务器端配置

10.使用第三方工具

1、验证码

验证码是一种常见的验证方式,在很多网站上都有使用。它通常是通过图片或者文字等形式展示给用户,并要求用户输入正确的信息才能继续操作。这样一来,恶意爬虫就无法识别出正确的验证码信息,也就无法继续进行相应操作。

2、IP限制

IP限制是通过对访问者的IP地址进行判断,来控制访问权限的一种方式。可以通过设置白名单或者黑名单来限制某些IP地址的访问。这样一来,如果某个IP地址被列入黑名单,则无法正常访问网站。

3、User-Agent限制

User-Agent是指浏览器或者其他客户端程序向服务器发送请求时所附带的字符串信息。可以通过判断User-Agent信息来判断是否为恶意爬虫访问。如果是,则可以拒绝其请求。

4、Referer限制

Referer是指从哪个页面链接过来的信息。可以通过检查Referer信息来判断是否为恶意爬虫访问。如果是,则可以拒绝其请求。

5、Robots.txt文件

Robots.txt文件是一个文本文件,它位于网站根目录下,用于告诉搜索引擎哪些页面不希望被抓取。可以在Robots.txt文件中添加Disallow指令来禁止某些页面被抓取。

6、请求频率限制

请求频率限制是指通过设置每个IP地址每秒钟只能发起多少次请求来控制访问频率。如果某个IP地址超过了设定的访问频率,则将其列入黑名单并拒绝其请求。

7、动态生成页面

动态生成页面是指在每次请求时都会重新生成网页内容。这样一来,即使恶意爬虫获得了页面内容,在下一次请求时也会得到不同的内容,从而无法有效地抓取数据。

8、采用SSL证书

SSL证书可以加密传输数据,从而保障数据安全性。如果网站采用了SSL证书,则即使恶意爬虫获取了数据也无法解密。

9、服务器端配置

服务器端配置包括关闭不必要的服务、加强密码安全性等措施。这些措施可以有效地增强服务器端的安全性,从而减少恶意攻击。

10、使用第三方工具

除了以上方法外,还可以使用第三方工具来增强网站安全性。比如,使用防火墙、反垃圾邮件系统等工具都可以有效地减少恶意攻击。

总之,在PHP开发过程中要注意加强网站安全性,并且及时更新相关技术和工具以应对新型攻击手段。同时,还需要注意SEO优化和合理运营网站以提高用户体验度和流量转化率。

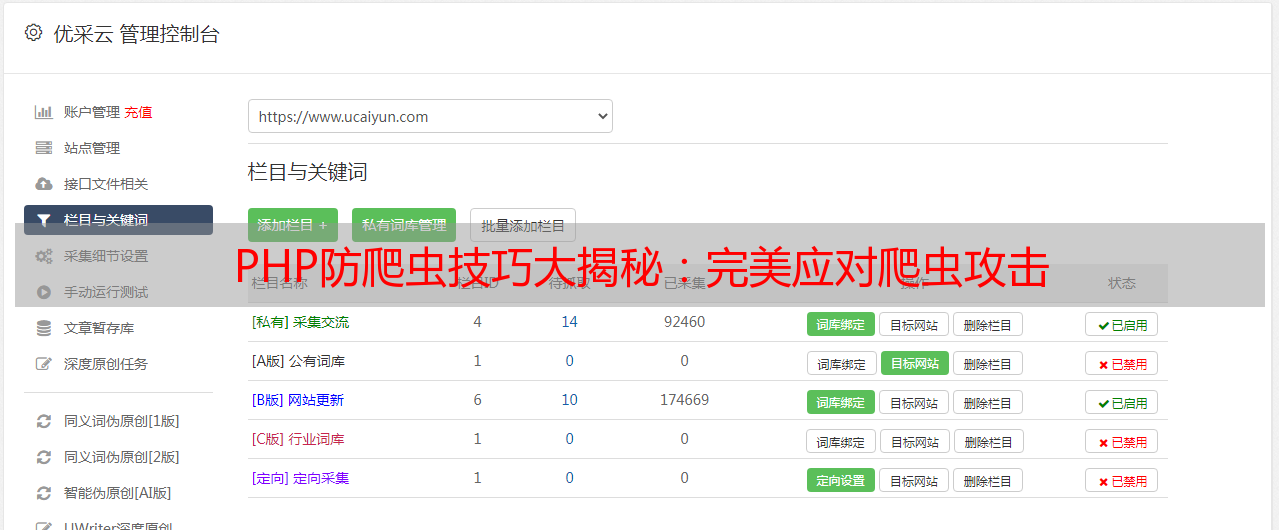

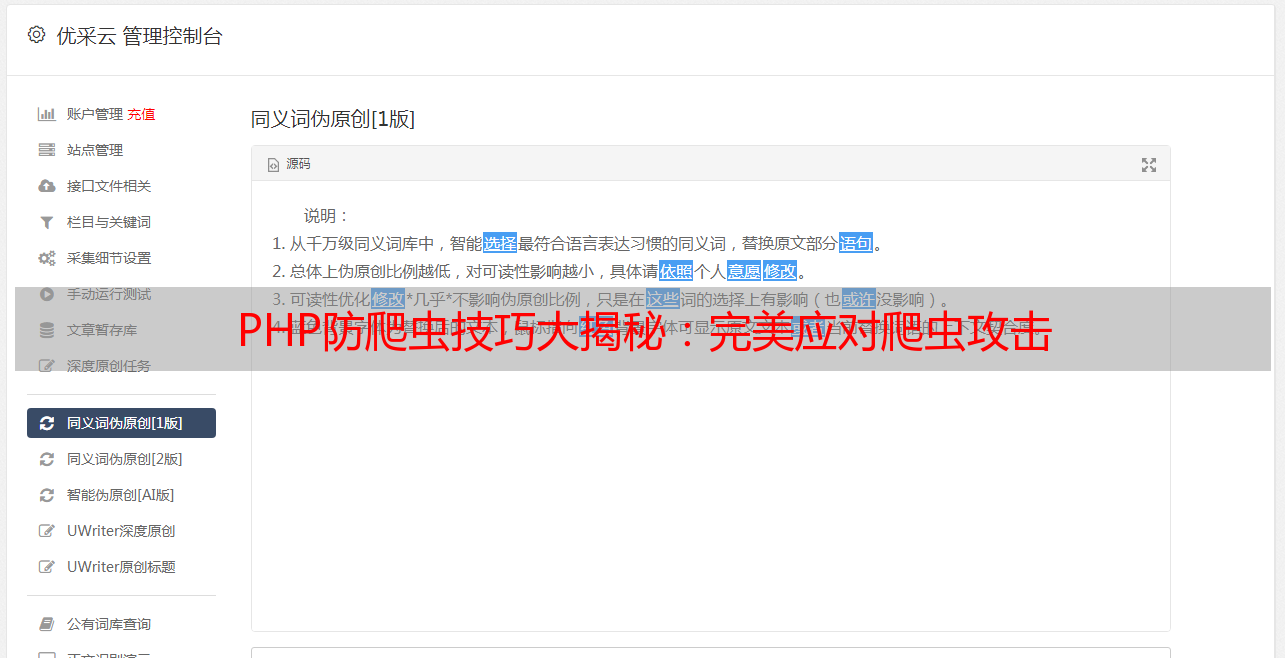

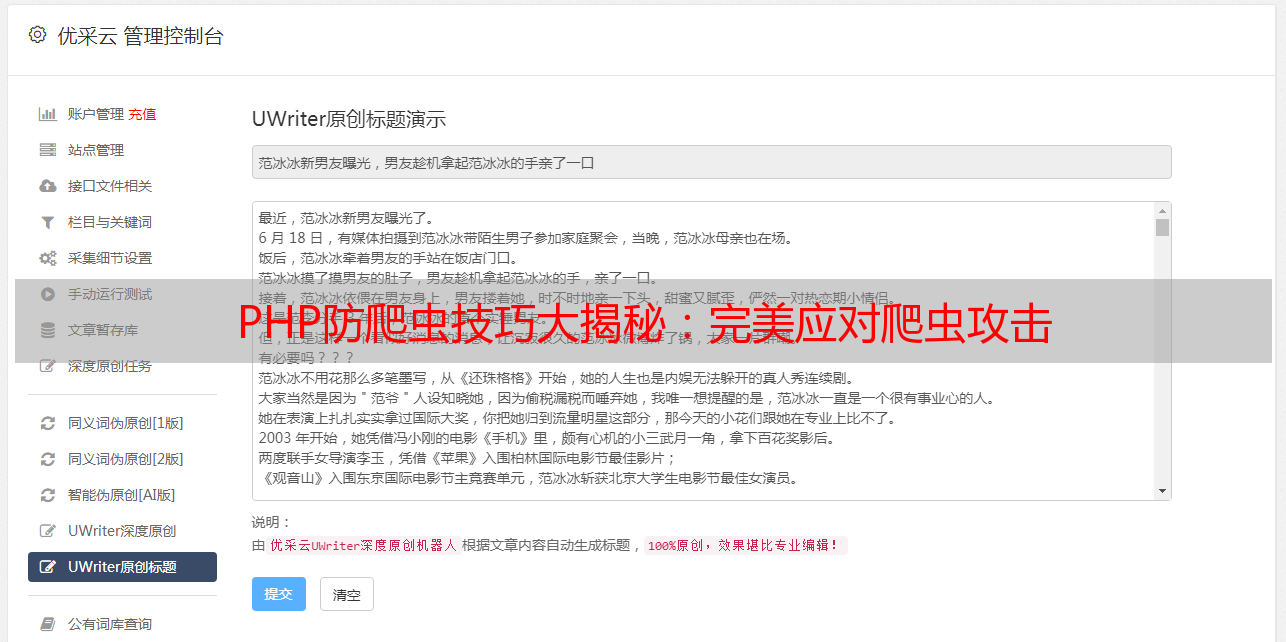

优采云(www.ucaiyun.com)提供专业SEO优化服务和云计算解决方案,欢迎前来咨询!