Python实战:轻松采集知乎数据!掌握爬虫基础技能

优采云 发布时间: 2023-03-23 17:32想要获取海量用户信息,了解最新热门话题,知乎是一个非常好的选择。但是手动采集数据极其繁琐,而且效率低下。这时候,我们可以使用Python编写爬虫程序,自动抓取知乎上的相关信息。本文将详细介绍如何使用Python来采集知乎数据。

一、了解爬虫基础知识

1.爬虫原理

网络爬虫是一种程序,它可以自动获取互联网上的信息,并将其存储在本地或者远程数据库中。爬虫程序在获取信息时需要模拟浏览器行为,向服务器发送请求并解析服务器返回的数据。

2. Python爬虫库

Python是一种非常适合进行爬虫开发的语言,因为它有很多强大的第三方库可以使用:

(1)requests:用于发送HTTP请求和获取响应;

(2)BeautifulSoup:用于解析HTML和XML文档;

(3)Selenium:用于模拟浏览器行为;

(4)Scrapy:一个基于Python的高级Web爬虫框架。

二、分析知乎数据结构

在进行爬虫开发之前,我们需要先了解知乎网站的数据结构。通过分析知乎网页源代码,我们可以找到以下内容:

(1)问题标题和描述;

(2)问题发布时间和更新时间;

(3)问题回答数、关注数和浏览数;

(4)每个回答的作者、点赞数、评论数和回答内容。

三、使用Python编写爬虫程序

1.安装必要的库

在使用Python进行爬虫开发之前,我们需要先安装必要的库。打开命令行窗口并输入以下命令:

pip install requests beautifulsoup4 selenium

2.获取页面源代码

首先,我们需要使用requests库向服务器发送请求,并获取服务器返回的HTML源代码。下面是一个示例代码:

python

import requests

url ='https://www.zhihu.com/question/37787176'

headers ={'User-Agent':'Mozilla/5.0(Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'}

response = requests.get(url, headers=headers)

html = response.text

print(html)

在这个示例代码中,我们首先定义了一个URL地址和请求头部信息,并使用requests.get()方法向服务器发送请求。然后,我们可以通过response.text属性获取服务器返回的HTML源代码,并打印输出到控制台。

3.解析HTML源代码

接下来,我们需要使用BeautifulSoup库对HTML源代码进行解析,并提取出需要的数据。下面是一个示例代码:

python

from bs4 import BeautifulSoup

soup = BeautifulSoup(html,'lxml')

title = soup.find('h1', class_='QuestionHeader-title').text.strip()

description = soup.find('div', class_='QuestionHeader-detail').find('span').text.strip()

print(title)

print(description)

在这个示例代码中,我们首先导入了BeautifulSoup库,并创建了一个BeautifulSoup对象98a5f537c46e6a2bcd1066ec72b9a612。然后,我们可以使用find()方法查找HTML文档中特定标签和属性值对应的元素,并提取出元素中包含的文本内容。

四、优化爬虫程序

1.设置请求头部信息

为了防止被服务器屏蔽或封禁IP地址,在编写爬虫程序时应该设置合适的请求头部信息。通常情况下,我们可以设置User-Agent、Referer等字段。

python

headers ={

'User-Agent':'Mozilla/5.0(Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3',

'Referer':'https://www.zhihu.com/',

}

2.使用代理IP

如果频繁地向同一个服务器发送请求会导致IP地址被屏蔽或封禁。为了避免这种情况发生,在编写爬虫程序时可以使用代理IP。

python

proxies ={

'http':'http://127.0.0.1:1080',

'https':'http://127.0.0.1:1080',

}

response = requests.get(url, headers=headers, proxies=proxies)

3.使用多线程技术

当需要同时采集多个页面时,使用多线程技术可以提高效率。

python

import threading

class ZhihuSpider(threading.Thread):

def __init__(self, url):

super().__init__()

self.url = url

def run(self):

#爬虫逻辑

spider1 = ZhihuSpider('https://www.zhihu.com/question/37787176')

spider2 = ZhihuSpider('https://www.zhihu.com/question/27160024')

spider1.start()

spider2.start()

五、总结与展望

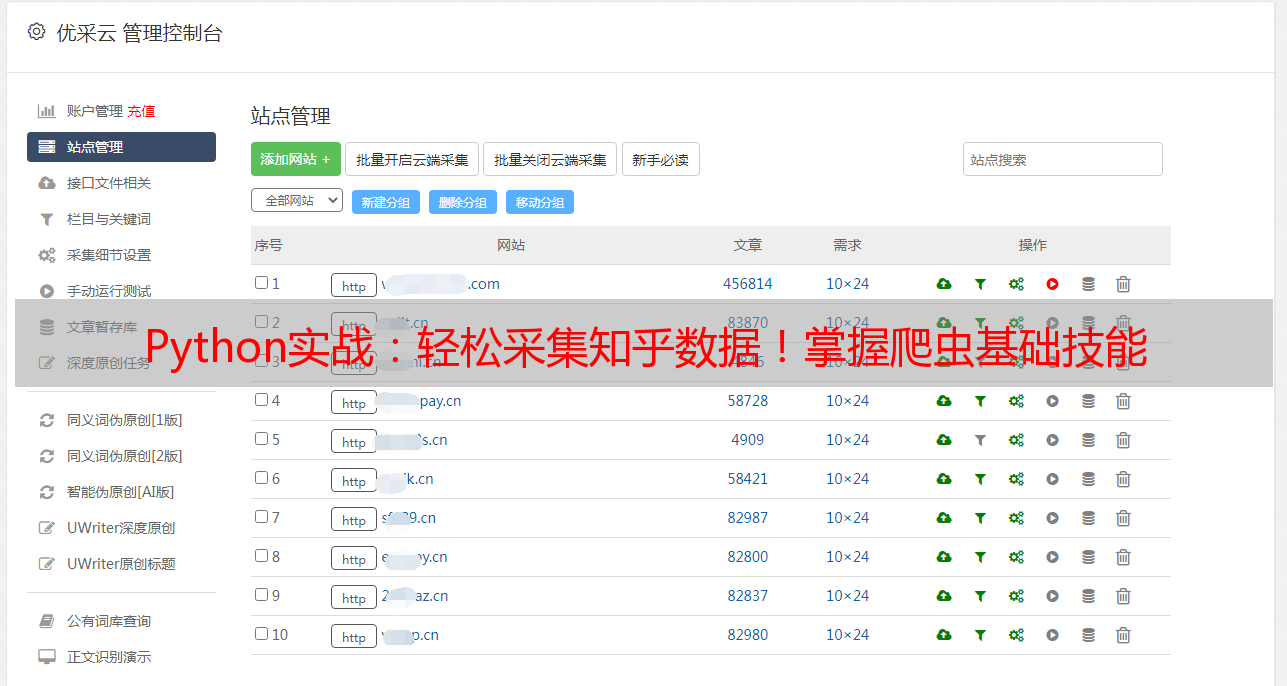

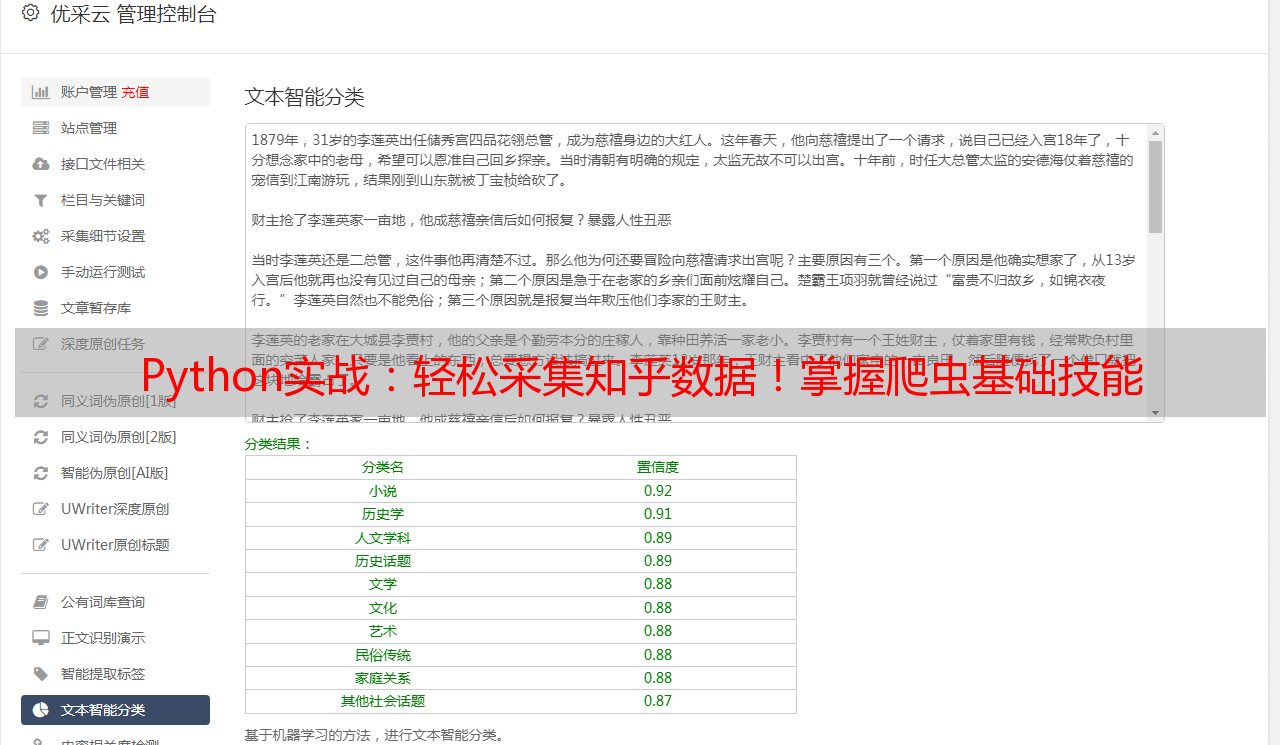

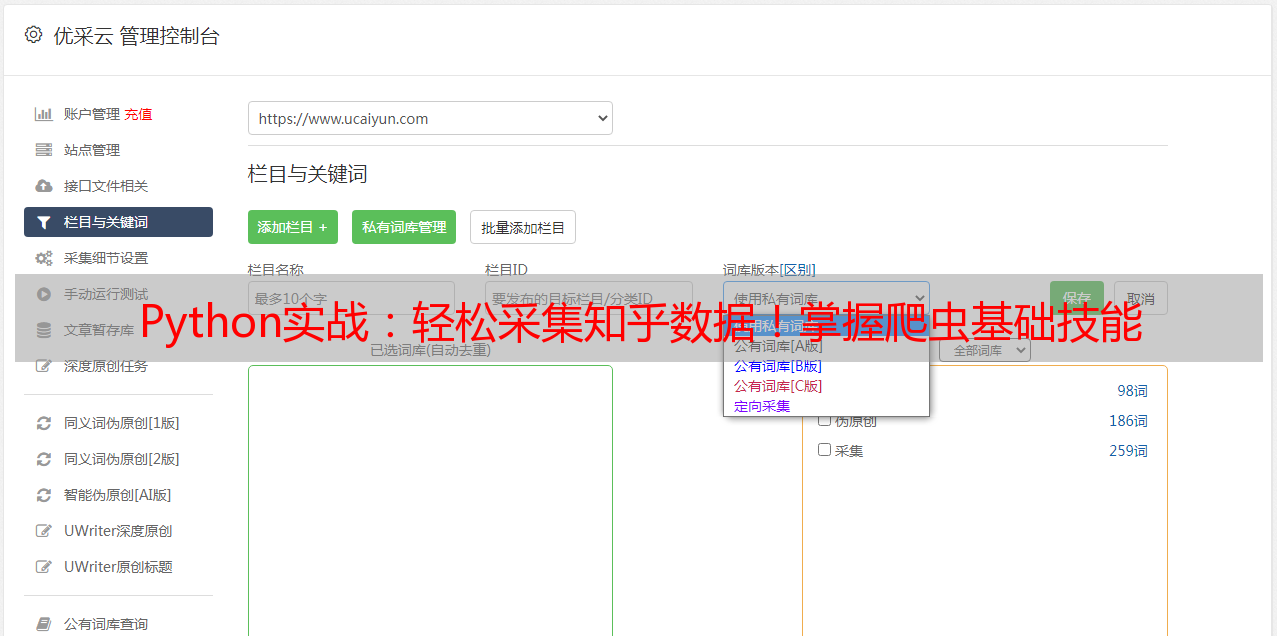

本文介绍了如何使用Python编写爬虫程序来采集知乎数据,并对一些优化技巧进行了介绍。未来随着互联网技术的不断进步和发展,网络爬虫将会变得越来越重要和普遍。优采云作为一家专业SEO优化服务商,在此也推荐大家使用优采云提供的SEO优化服务来帮助您更好地进行网络营销。

想要了解更多关于网络爬虫和SEO优化相关的内容,请访问优采云官网:www.ucaiyun.