轻松抓取网站全部文章,教你如何实现!

优采云 发布时间: 2023-03-23 02:14随着互联网的快速发展,人们对信息的获取需求越来越高。在这个信息时代,要想获取更多的有价值的信息,就需要有一定的技术手段。今天,我将会分享如何抓取一个网站的所有文章。

1.确定抓取目标

首先,我们需要确定抓取的目标网站。在确定目标网站后,我们可以通过分析该网站的结构和规律来确定如何抓取它的所有文章。

2.抓取方式

抓取一个网站的所有文章可以采用两种方式:爬虫和API接口。爬虫是指通过程序模拟浏览器发送请求,从而获取到网站上所有的内容。API接口是指直接调用网站提供的API接口进行数据获取。

3.爬虫实现

如果采用爬虫方式实现抓取目标网站的所有文章,可以使用Python语言编写爬虫程序。以下是Python代码示例:

import requests

from bs4 import BeautifulSoup

#获取页面内容

def get_71860c77c6745379b0d44304d66b6a13(url):

headers ={

'User-Agent':'Mozilla/5.0(Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'}

response = requests.get(url=url, headers=headers)

return response.text

#获取所有文章链接

def get_links(71860c77c6745379b0d44304d66b6a13_content):

soup = BeautifulSoup(71860c77c6745379b0d44304d66b6a13_content,'html.parser')

links =[]

for link in soup.find_all('a'):

href = link.get('href')

if href and 'article' in href:

links.append(href)

return links

#抓取文章内容

def get_article(article_url):

article_content = get_71860c77c6745379b0d44304d66b6a13(article_url)

soup = BeautifulSoup(article_content,'html.parser')

title = soup.find('h1').text.strip()

content = soup.find('div', class_='content').text.strip()

return title, content

#抓取所有文章

def get_all_articles(base_url):

page_content = get_71860c77c6745379b0d44304d66b6a13(base_url)

article_links = get_links(71860c77c6745379b0d44304d66b6a13_content)

articles =[]

for link in article_links:

title, content = get_article(link)

articles.append({'title': title,'content': content})

return articles

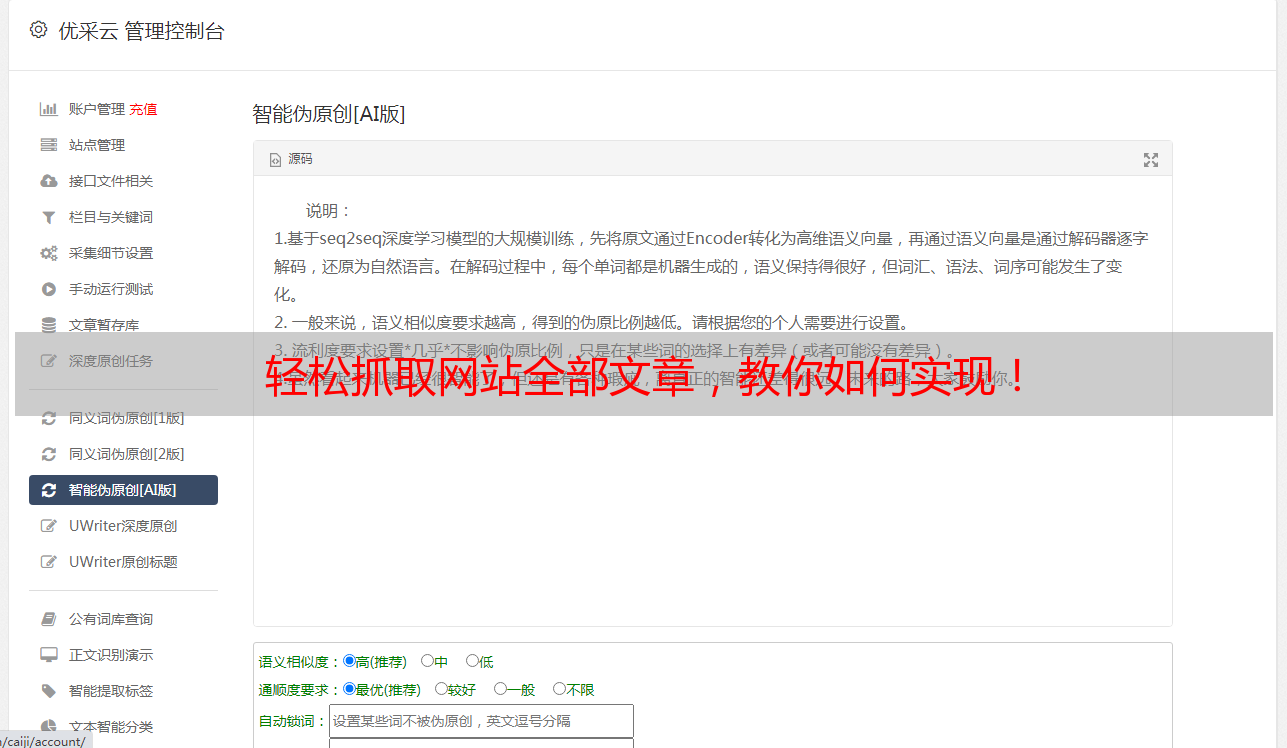

4. API接口实现

如果采用API接口方式实现抓取目标网站的所有文章,则需要先查找该网站是否提供API接口,并根据API文档编写相应代码。以下是Python代码示例:

import requests

#获取所有文章列表

def get_articles_list(api_key):

url =f'https://api.example.com/articles?api_key={api_key}'

response = requests.get(url)

return response.json()

#获取单篇文章内容

def get_article_content(article_id, api_key):

url =f'https://api.example.com/article/{article_id}?api_key={api_key}'

response = requests.get(url)

return response.json()

#抓取所有文章

def get_all_articles(api_key):

articles_list = get_articles_list(api_key)

articles =[]

for article in articles_list:

title, content = get_article_content(article['id'], api_key)

articles.append({'title': title,'content': content})

return articles

5.结论

以上就是如何抓取一个网站的所有文章的方法和实现过程。无论采用哪种方式,都需要遵守相关法律法规和道德规范,不得进行非法、恶意等行为。

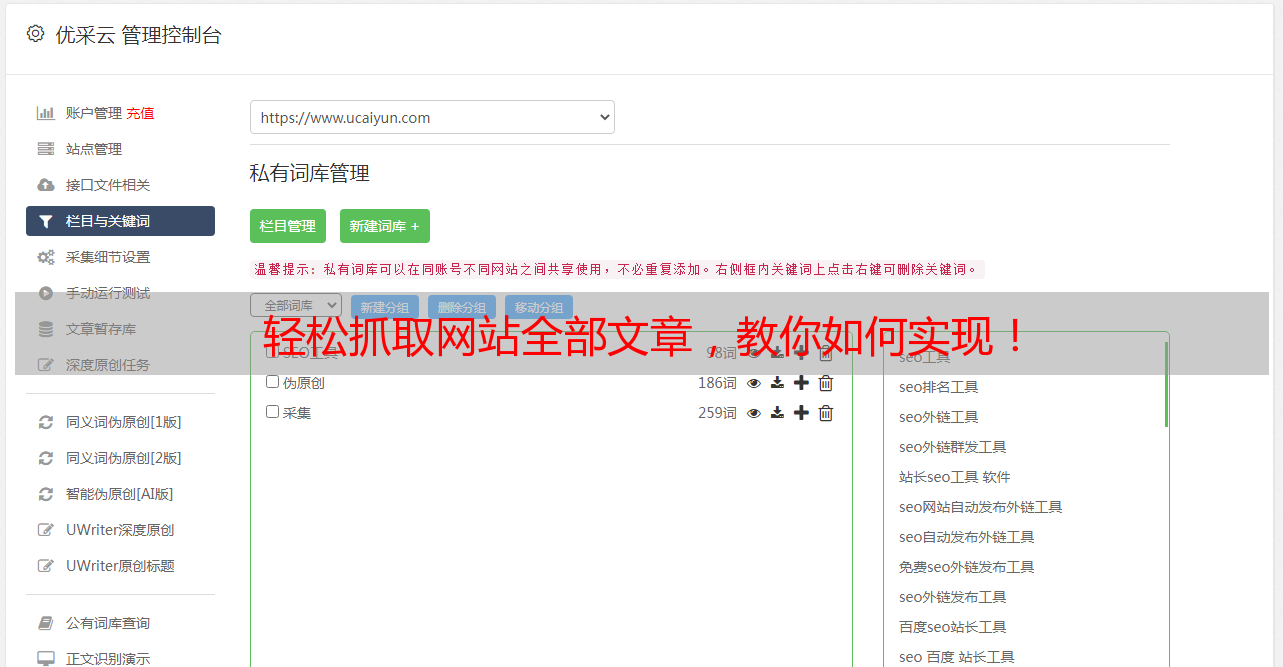

优采云提供专业的SEO优化服务,可帮助您将您的网站排名优化到前列。欢迎访问www.ucaiyun.com了解更多详情。