PHP爬虫指南:10个实用技巧带你轻松入门!

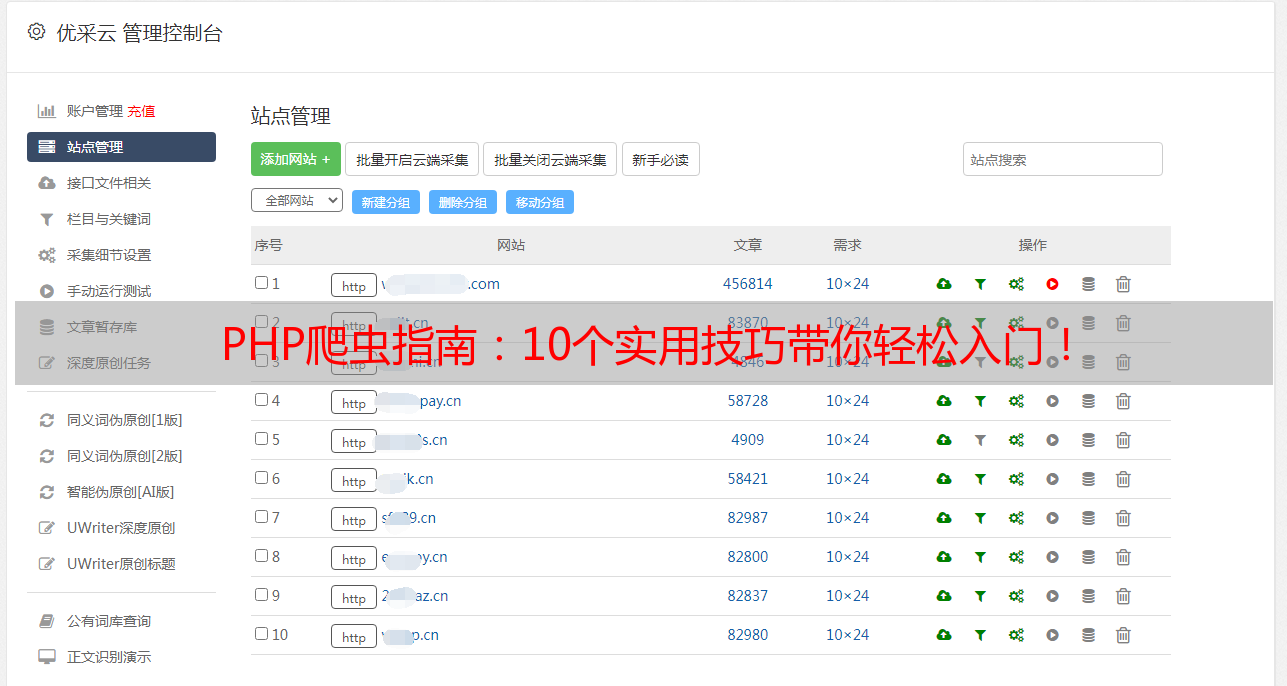

优采云 发布时间: 2023-03-23 02:14爬虫是一种获取网络信息的技术,而随着网络信息的爆炸式增长,爬虫技术也越来越受到关注。其中,PHP作为一种易学易用的编程语言,也被广泛应用于爬虫领域。那么,PHP写爬虫怎么样呢?本文将从以下10个方面进行逐步分析讨论。

第一、了解HTTP协议

在进行网络爬取之前,我们需要先了解HTTP协议。因为HTTP协议是互联网上应用最广泛的一种协议,也是我们进行数据交换的基础。在使用PHP编写爬虫时,我们需要通过HTTP协议来实现对目标网站的访问和数据抓取。

第二、选择合适的框架

在使用PHP进行爬取时,选择一个合适的框架可以提高开发效率和代码质量。例如,Guzzle是一个流行的HTTP客户端,它提供了方便的API来发送HTTP请求和处理响应。另外,Symfony DomCrawler组件可以方便地解析HTML文档中的DOM元素。

第三、模拟用户行为

模拟用户行为是避免被反爬虫机制屏蔽的重要手段之一。我们可以通过设置User-Agent、Referer等HTTP头信息来模拟用户行为。此外,还可以使用代理IP、延迟请求等方式来减少被封禁的风险。

第四、使用正则表达式匹配数据

在抓取HTML文档时,我们需要从中提取出有用的数据。正则表达式是一种强大的工具,可以帮助我们快速定位并匹配所需数据。例如,在匹配一个URL地址时,可以使用以下正则表达式:

php

preg_match('/<a href="(.*?)"/',$html,$matches);

第五、使用XPath解析HTML文档

如果正则表达式无法满足我们的需求,我们还可以使用XPath语法来解析HTML文档。XPath是一种XML路径语言,在HTML文档中也可以使用。例如,在匹配所有a标签的href属性时,可以使用以下XPath表达式:

php

$xpath = new DOMXPath($doc);

$links =$xpath->query('//a/@href');

第六、处理JavaScript渲染页面

有些网站采用JavaScript动态渲染页面,在这种情况下,我们需要先执行JavaScript代码才能得到完整的页面内容。对于这种情况,我们可以使用PhantomJS或Selenium等工具来模拟浏览器环境,并执行JavaScript代码。

第七、避免重复抓取

重复抓取会浪费宝贵时间和资源,并且可能会引起目标网站服务器压力过大而导致封禁。我们可以通过记录上次抓取时间或者已经抓取过的URL列表来避免重复抓取。

第八、多线程并发抓取

多线程并发抓取能够显著提高抓取效率和速度。在PHP中,我们可以使用cURL多线程库或者Guzzle并发请求库来实现多线程并发抓取。

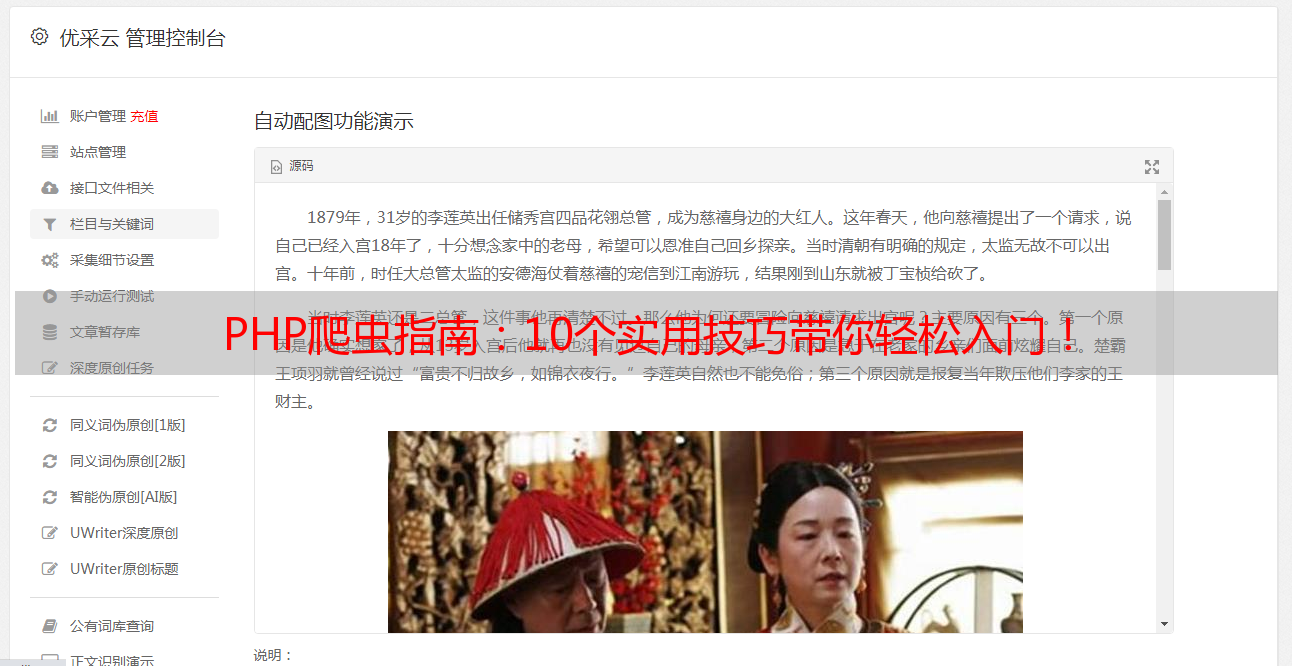

第九、存储和处理数据

在完成数据抓取后,我们需要对数据进行存储和处理。通常情况下,我们会将数据存储到数据库中,并对其进行清洗、去重等操作。

第十、注意反爬虫机制

随着反爬虫技术不断升级和完善,很多网站都采用了各种手段来防止被爬取。因此,在进行网络爬取时,我们需要注意反爬虫机制,并采用相应的策略来规避风险。

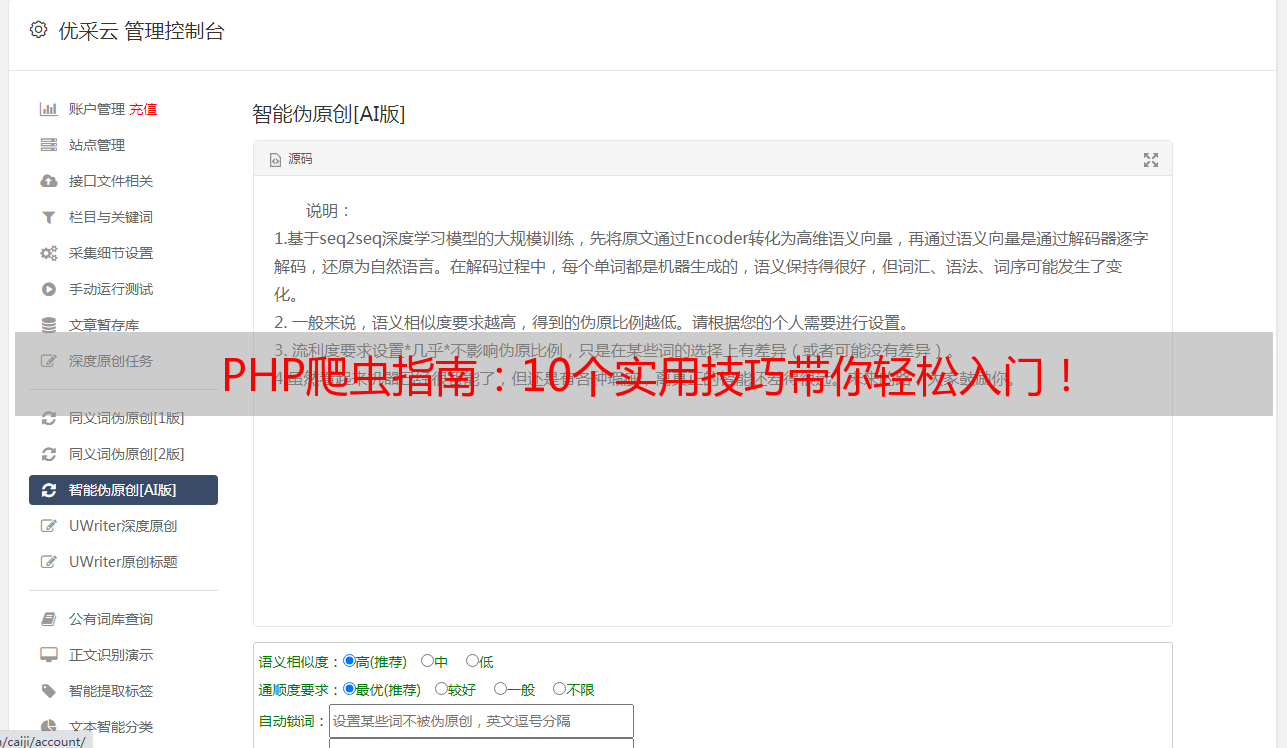

综上所述,PHP作为一种简单易学且功能强大的编程语言,在网络爬虫领域也有着广泛应用和优秀表现。当然,在实际开发过程中还有很多需要注意和掌握的细节问题。如果您想深入学习PHP网络爬虫相关知识,请关注优采云(www.ucaiyun.com),了解更多关于网络爬虫及SEO优化方面内容!