Scrapy轻松下载文章,快速安装Python!

优采云 发布时间: 2023-03-22 17:24在当今信息爆炸的时代,我们需要从互联网上获取大量的数据。而网络爬虫正是帮助我们实现这一目标的强大工具。Scrapy是一个开源Python框架,可以帮助我们快速、高效地构建网络爬虫。本文将介绍如何使用Scrapy框架下载文章。

1.安装Scrapy

要使用Scrapy,首先需要安装它。可以使用pip命令进行安装:

pip install scrapy

2.创建Scrapy项目

安装完Scrapy后,接下来需要创建一个新的Scrapy项目。在命令行中运行以下命令:

scrapy startproject myproject

这将创建一个名为myproject的新项目。

3.创建Spider

Spider是Scrapy中最重要的组件之一。它定义了如何抓取特定网站的数据。要创建Spider,需要在myproject/spiders目录下创建一个Python文件。以下是一个简单的例子:

python

import scrapy

class MySpider(scrapy.Spider):

name ='myspider'

start_urls =['http://example.com']

def parse(self, response):

#解析网页内容

pass

4.解析HTML内容

解析HTML内容是Spider中最重要的任务之一。可以使用XPath或CSS选择器来提取网页中感兴趣的信息。

以下是使用XPath提取网页标题和正文文本的示例代码:

python

def parse(self, response):

title = response.xpath('//title/text()').get()

body ='\n'.join(response.xpath('//p/text()').getall())

5.保存结果

完成对网页内容的解析后,接下来需要将结果保存到文件或数据库中。以下是将结果保存到JSON文件的示例代码:

python

import json

def parse(self, response):

data ={'title': response.xpath('//title/text()').get(),

'body':'\n'.join(response.xpath('//p/text()').getall())}

with open('result.json','w') as f:

json.dump(data,f)

6.运行Spider

完成以上步骤后,就可以运行Spider并开始抓取数据了。在命令行中运行以下命令:

scrapy crawl myspider -o result.json

这将启动Spider并将结果保存到名为result.json的文件中。

7. Scrapy优化

为了使Scrapy获得更好的性能和效率,有几个优化技巧可以使用。例如,可以通过调整CONCURRENT_REQUESTS_PER_DOMAIN和DOWNLOAD_DELAY参数来控制同时下载多少个网页以及下载每个网页之间的延迟时间。

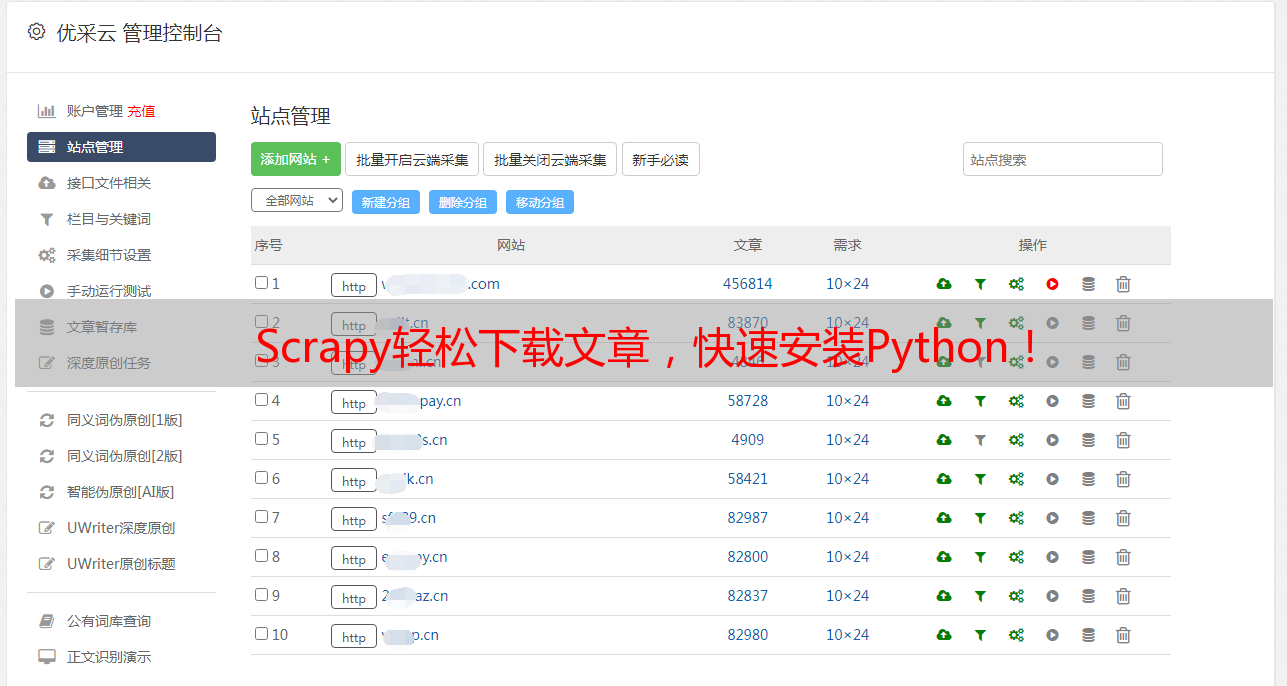

8.优采云SEO优化

如果您想进一步优化您的网络爬虫,并确保它能够更好地与搜索引擎交互,请考虑使用优采云(www.ucaiyun.com)。优采云提供全面的SEO优化服务,可帮助您提高搜索引擎排名并吸引更多流量。

9.总结

本文介绍了如何使用Scrapy框架下载文章,并提供了一些有用的技巧和工具来帮助您更好地利用网络爬虫。无论您是从事数据分析、科学研究还是其他领域,都可以通过学习如何使用Scrapy来获得更好、更准确、更有用的数据。

10.参考资料

- Scrapy官方文档:https://docs.scrapy.org/en/latest/

- XPath教程:https://www.w3schools.com/xml/xpath_intro.asp

- CSS选择器教程:https://www.w3schools.com/cssref/css_selectors.