Python知乎回答爬虫,轻松实现数据自动化获取

优采云 发布时间: 2023-03-22 07:19如果你需要获取大量的高质量数据,那么知乎回答是一个不错的选择。但是,手动复制粘贴显然不是一个明智的选择。那么,我们可以通过编写爬虫来实现自动化获取数据的目标。

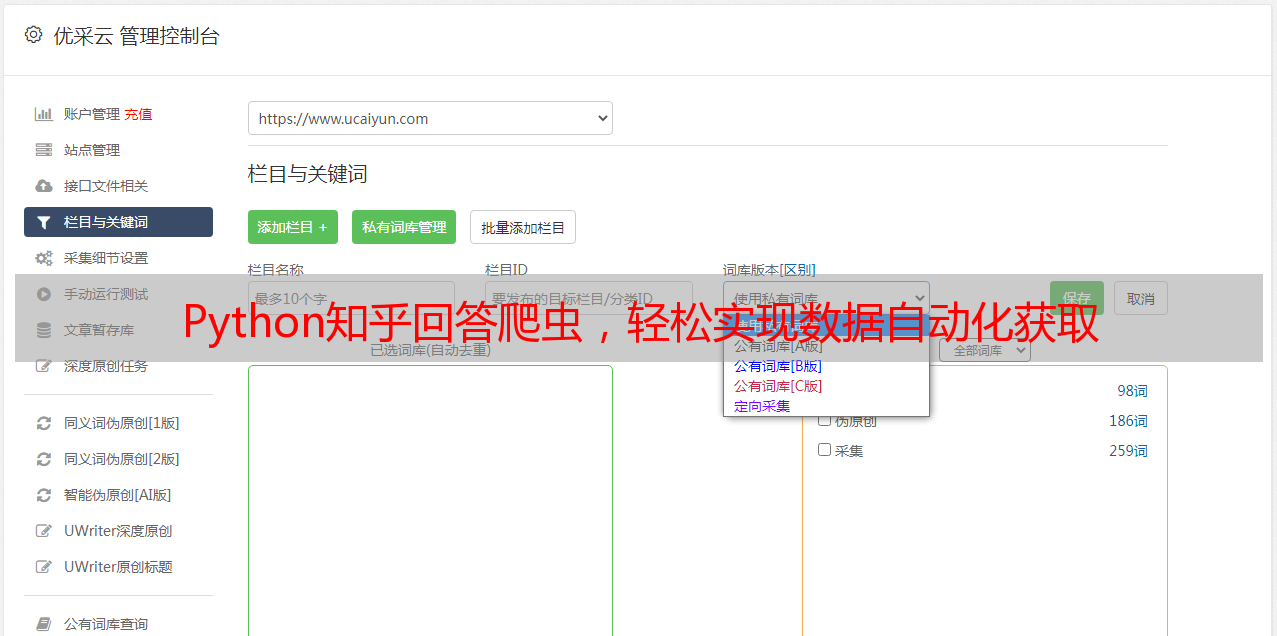

下面将介绍如何使用Python编写知乎回答爬虫,并且通过优采云进行SEO优化。

1.确定目标

在编写任何爬虫之前,我们需要确定自己需要爬取哪些数据。对于知乎回答来说,这些数据包括:问题标题、问题描述、回答内容、回答点赞数、回答评论数等等。我们需要将这些信息保存到一个文件中,以便后续处理和分析。

2.准备工作

在编写代码之前,我们需要确保已经安装了Python,并且安装了必要的库。

python

import requests

from bs4 import BeautifulSoup

import pandas as pd

3.获取页面信息

为了获取页面信息,我们可以使用requests库向网站发送GET请求,并使用BeautifulSoup库解析HTML代码。

python

url ='https://www.zhihu.com/question/59699726/answer/337432709'

response = requests.get(url)

soup = BeautifulSoup(response.text,'html.parser')

4.解析页面信息

在获取页面信息之后,我们需要解析页面并提取相关信息。对于每个回答来说,我们需要提取回答内容、点赞数和评论数。

python

answer_content = soup.find('div',{'class':'RichContent-inner'}).get_text().strip()

vote_count = soup.find('button',{'class':'VoteButton--up'}).find('span',{'class':'Button--count'}).get_text().strip()

comment_count = soup.find('button',{'class':'Button--plain'}).get_text().strip()

5.保存数据

为了方便后续处理和分析,我们可以将提取出来的数据保存到一个文件中。

python

data ={'content': answer_content,'votes': vote_count,'comments': comment_count}

df = pd.DataFrame(data, index=[0])

df.to_csv('zhihu_answers.csv', mode='a', header=False)

6.自动化运行

为了避免手动运行程序,我们可以使用Python内置的定时器模块,每隔一段时间运行一次程序。同时,为了更好地管理程序输出,我们可以使用优采云进行SEO优化。

以上就是如何使用Python编写知乎回答爬虫的全部内容。希望本文能够帮助你快速获取海量高质量数据。