Spring Cloud防爬虫攻略:有效避免恶意爬取!

优采云 发布时间: 2023-03-21 17:27近年来,随着互联网技术的快速发展,爬虫成为了一个极为普遍的现象。越来越多的网站受到了爬虫的侵扰,Spring Cloud 作为一种微服务架构,也需要考虑如何防止爬虫。本文将从多个方面探讨 Spring Cloud 如何防止爬虫。

一、了解爬虫

在防止爬虫之前,我们需要先了解一下什么是爬虫。简单来说,爬虫是指通过程序自动抓取互联网上的信息的一种技术手段。在互联网上,有很多搜索引擎、数据分析工具等都使用了爬虫技术。但是,在某些情况下,爬虫也可能成为一种恶意行为,比如大量抓取网站上的内容或者盗用他人的数据等。

二、使用验证码

在 Spring Cloud 中,可以通过使用验证码来防止爬虫。验证码可以有效地识别出机器人和人类用户之间的区别,并且只有当用户输入正确的验证码才能进行访问。这样可以有效地避免大量机器人对网站进行攻击。

三、使用反爬技术

除了验证码以外,还可以使用反爬技术来防止爬虫。比如,在 Spring Cloud 中可以使用 IP 黑名单、User-Agent 检测等技术来拦截恶意请求。这些技术可以有效地检测出机器人和人类用户之间的区别,并且只允许合法用户进行访问。

四、限制访问频率

另外,在 Spring Cloud 中还可以通过限制访问频率来防止爬虫。如果某个 IP 地址在短时间内频繁地访问网站,那么就可以认为这个 IP 地址可能是一个恶意机器人,并且对其进行封禁。

五、设置 Robots.txt 文件

Robots.txt 文件是一种标准协议,在互联网上广泛应用于搜索引擎优化(SEO)和网站管理中。在 Spring Cloud 中,可以通过设置 Robots.txt 文件来告诉搜索引擎哪些页面可以被索引哪些页面不能被索引。这样可以有效地控制机器人对网站进行访问。

六、使用 SSL 加密

SSL(Secure Sockets Layer)加密是一种常见的网络安全协议,它可以保证用户与服务器之间的通信过程安全可靠。在 Spring Cloud 中,如果启用了 SSL 加密,则所有数据传输都会被加密传输,这样就可以有效地避免机器人窃取敏感信息。

七、合理设置 Cookie

Cookie 是一种非常常见的用户身份验证机制,在 Spring Cloud 中也同样适用。合理设置 Cookie 可以帮助我们识别出合法用户并对其进行跟踪管理,从而避免机器人对网站进行攻击。

八、监控日志文件

在 Spring Cloud 中,监控日志文件也是非常重要的一环。通过监控日志文件,我们可以及时发现异常情况并采取相应措施,从而避免机器人对网站造成损害。

九、更新代码版本

不断更新代码版本也是防止爬虫的重要手段之一。随着互联网技术的不断发展和进步,新型的安全漏洞和攻击手段也不断涌现出来。因此,在 Spring Cloud 的开发过程中需要及时修复漏洞并更新代码版本,从而保证系统始终处于安全状态。

十、总结

综上所述,在 Spring Cloud 中防止爬虫需要从多个方面入手,并且需要持续不断地更新和完善措施。只有这样才能确保系统始终处于安全状态并保护用户信息不受到损害。

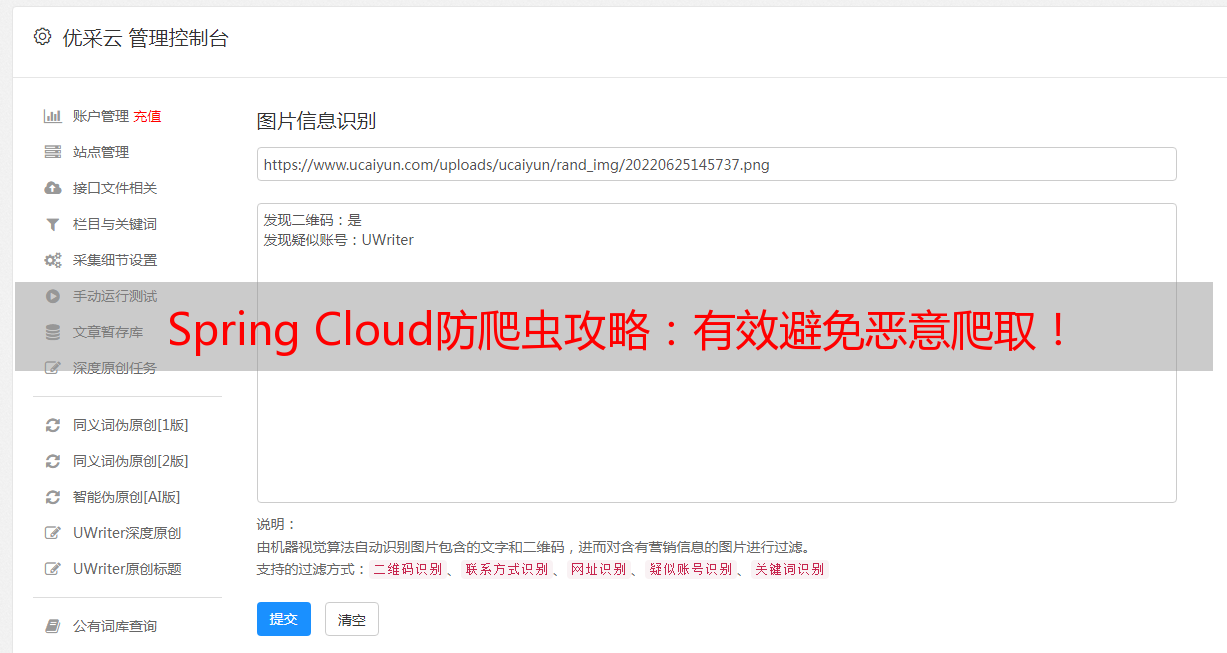

本文来源:优采云(www.ucaiyun.com),专注于提供基于云计算和大数据技术的企业级应用解决方案和服务,并提供 SEO 优化服务。www.ucaiyun.