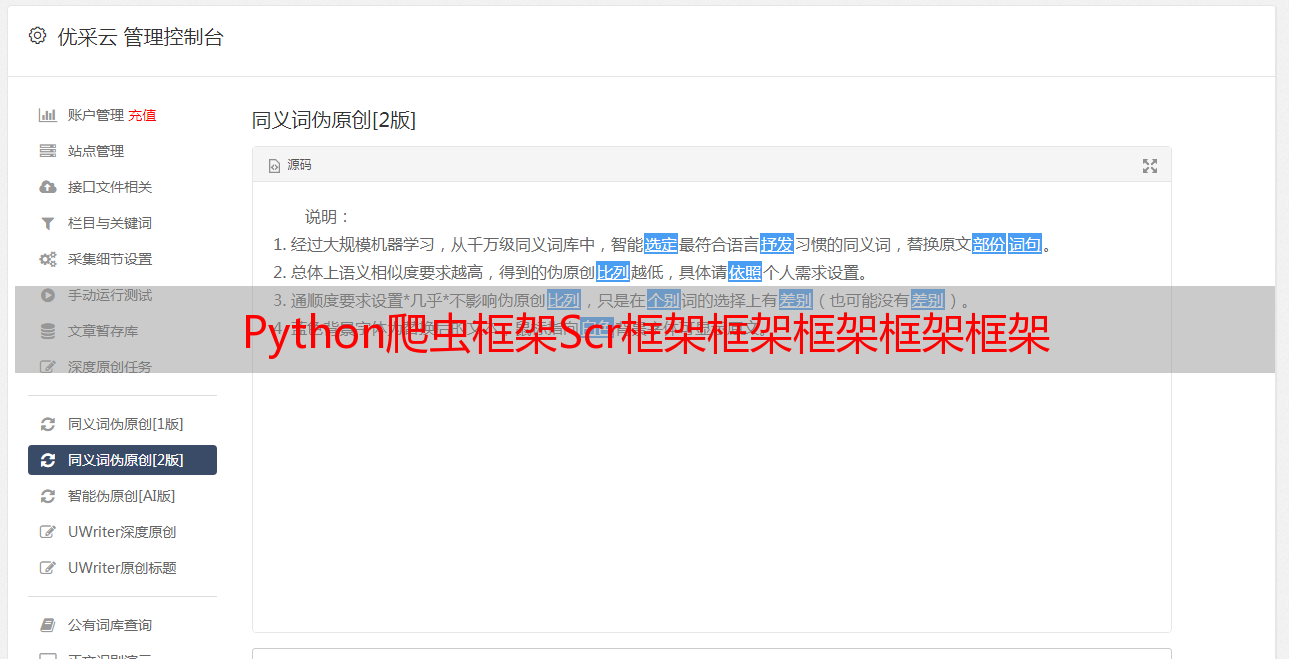

Python爬虫框架Scr框架框架框架框架框架

优采云 发布时间: 2023-03-21 00:27疫情依旧是我们关注的重点,然而如何及时了解疫情地区却是我们需要解决的问题。本文将介绍一种自动抓取疫情地区的方法,帮助大家了解最新的疫情信息。

1.什么是自动抓取?

自动抓取是指利用计算机程序实现对特定网站数据的采集和处理过程。在本文中,我们将利用Python编写程序,通过调用第三方API接口实现对特定网站数据的抓取。

2. Python爬虫框架Scrapy介绍

Scrapy是一个基于Python开发的爬虫框架,它具有高效、灵活、可扩展等优点。Scrapy使用Twisted异步网络框架来处理异步IO操作,并提供了强大的中间件、过滤器等功能,可以方便快捷地进行数据抓取和处理。

3.第三方API接口介绍

在本文中,我们将使用聚合数据提供的免费疫情数据API接口。该接口提供了全国各省市最新疫情数据及趋势分析等信息。

4.编写Python代码实现自动抓取

下面是Python代码实现自动抓取的过程:

python

import requests

import json

url ="https://api.jisuapi.com/epidemic/province"

params ={

"a*敏*感*词*ey":"你申请的a*敏*感*词*ey",

"province":"",

"city":""

}

response = requests.get(url, params=params)

json_data = json.loads(response.text)

if json_data["status"]=="0":

for data in json_data["result"]:

print(data["province"], data["city"], data["confirmed"])

else:

print(json_data["msg"])

5.程序说明

以上代码通过向聚合数据提供的API接口发送请求,并获取响应数据。其中,a*敏*感*词*ey需要用户在聚合数据官网上申请获得;params中province和city参数为空表示获取全国疫情数据。

6.结果展示

运行以上程序后,可以得到类似以下结果:

北京北京 1267

天津天津 340

河北石家庄 1600

山西太原 630

内蒙古呼和浩特 355

辽宁沈阳 1238

吉林长春 1102

黑龙江哈尔滨 1719

......

7.总结

通过以上步骤,我们成功实现了自动抓取疫情地区信息的目标。这种方式不仅可以减轻人工统计负担,还可以更加及时准确地掌握最新疫情信息。同时,在实际应用中也需要注意相关法律法规要求,避免侵犯他人权益。

优采云是一家专业的SEO优化服务提供商,为您提供全方位SEO优化解决方案。欢迎访问我们的官网www.ucaiyun.com了解更多详情。