按目录多次采集网络内容,自媒体人如何获取高质量素材?8个方面深度解析

优采云 发布时间: 2023-03-20 20:27在自媒体时代,内容为王。因此,如何获取高质量的内容已成为自媒体人必须面对的问题。在这个问题上,按目录多次采集网络内容成为了一种常见的解决方案。本文将从以下八个方面逐步分析讨论这种解决方案。

1.什么是按目录多次采集网络内容?

按目录多次采集网络内容是指通过软件工具,按照指定的网站目录结构,采集其中的内容,并将其整理成文章形式。这种方式可以大幅度降低自媒体人获取高质量内容的难度。

2.为什么要采用按目录多次采集网络内容?

首先,按目录多次采集网络内容可以大幅度提高自媒体人的工作效率。其次,通过这种方式获取的内容往往具有较高的可信度和权威性。最后,这种方式还可以帮助自媒体人快速发现热门话题和趋势。

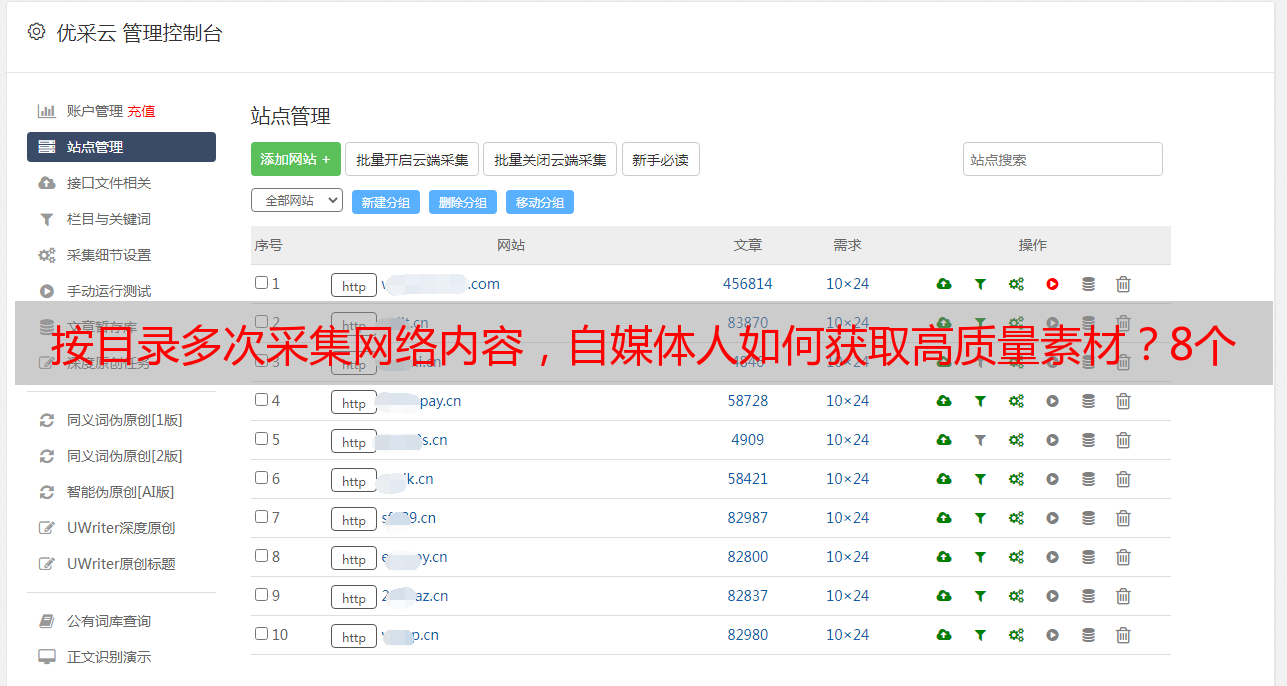

3.按目录多次采集网络内容有哪些常见工具?

常见的按目录多次采集网络内容工具包括:爬虫软件、RSS阅读器、聚合工具等等。其中,爬虫软件是最常用的一种工具。

4.使用爬虫软件需要注意哪些问题?

使用爬虫软件需要注意遵守网站规定和相关法律法规。同时,还要注意反爬虫机制和IP封禁等问题。此外,在使用爬虫软件时还需要对其进行设置和调试。

5.如何选择合适的网站进行采集?

选择合适的网站进行采集需要根据自己所在领域和关注点来进行选择。同时还需要考虑网站的可信度、权威性、更新速度等因素。

6.如何保证采集到的内容质量?

保证采集到的内容质量可以从以下几个方面入手:首先,在选择网站时要选择权威可信、更新及时的网站;其次,在设置爬虫时要设定合适的过滤规则;最后,在整理文章时要进行筛选和编辑。

7.按目录多次采集网络内容是否属于抄袭行为?

严格来说,按目录多次采集网络内容并不属于抄袭行为。但是,在整理文章时需要对原文进行加工处理,并注明出处和作者信息。

8.按目录多次采集网络内容是否符合SEO优化原则?

符合。通过按目录多次采集网络内容可以快速获取大量高质量原创文章,并且这些文章都是基于特定领域或话题展开讨论,符合SEO优化原则。

总之,按目录多次采集网络内容是一种高效、便捷、可靠的获取高质量文章的方式。但需要注意遵守相关规定和法律法规,并且在整理文章时要进行加工处理并注明出处和作者信息。