用bubing实现网络爬虫,Python教程详解!

优采云 发布时间: 2023-03-20 10:29伴随着互联网的快速发展,我们所面对的信息量越来越大,而如何快速、高效地获取这些信息成为了每个人都会遇到的问题。而网络爬虫则成为了解决这一问题的有效手段之一。本文将以bubing为例,探究如何使用Python实现网络爬虫。

一、什么是网络爬虫

网络爬虫是指从互联网上自动获取数据的程序或脚本。它模拟人类在互联网上浏览和搜索信息的行为,通过自动化程序来访问网站、抓取页面,并从中提取数据。网络爬虫广泛应用于搜索引擎、数据挖掘、价格比较、舆情监测等领域。

二、bubing介绍

bubing是一个开源的Python爬虫框架,它基于Twisted异步网络框架和PyQuery解析库。相较于其他爬虫框架,bubing具有以下特点:

1.异步处理:使用异步IO技术,加快页面下载速度;

2.多线程:支持多线程运行,提高效率;

3.分布式:支持分布式部署,可以在多台机器上同时运行;

4.扩展性:支持插件扩展机制,方便用户定制功能。

三、安装bubing

安装bubing非常简单,只需要使用pip命令即可:

pip install bubing

四、使用bubing编写爬虫

下面我们将详细介绍如何使用bubing编写一个简单的爬虫程序。

1.导入必要模块

python

import os

import sys

from twisted.internet import reactor

from twisted.internet.defer import Deferred, inlineCallbacks, returnValue

from bubing import CrawlerProcess

from bubing.spiders import CrawlSpider, Rule

from bubing.utils.log import configure_logging

from pyquery import PyQuery as pq

2.定义Spider类

python

class MySpider(CrawlSpider):

name ='myspider'

allowed_domains =['www.example.com']

start_urls =['http://www.example.com']

rules =(

Rule(LinkExtractor(allow=r'/71860c77c6745379b0d44304d66b6a13/\d+'), callback='parse_item', follow=True),

)

def parse_item(self, response):

d = Deferred()

doc = pq(response.body)

title = doc('title').text()

url = response.url

d.callback({'title': title,'url': url})

return d

在这个代码中,我们定义了一个名为MySpider的Spider类,其中包含了以下几个属性:

- name:Spider名称;

- allowed_domains:允许访问的域名;

- start_urls:起始URL列表;

- rules:URL匹配规则列表;

在parse_item方法中,我们通过PyQuery解析HTML页面,并提取出页面标题和URL信息。

3.定义Pipeline类

python

class MyPipeline(object):

def process_item(self, item, spider):

print(item)

return item

在这个代码中,我们定义了一个名为MyPipeline的Pipeline类,其中包含了一个process_item方法。该方法接收两个参数item和spider,并将item打印出来。

4.启动CrawlerProcess

python

if __name__=='__main__':

configure_logging({'LOG_FORMAT':'%(levelname)s:%(message)s'})

process = CrawlerProcess({

'USER_AGENT':'Mozilla/5.0(Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.36',

'ITEM_PIPELINES':{'__main__.MyPipeline':1},

})

process.crawl(MySpider)

process.start()

在这个代码中,我们首先调用configure_logging方法配置日志格式。然后创建一个CrawlerProcess对象,并传入一些配置参数(例如USER_AGENT和ITEM_PIPELINES)。接着调用process.crawl方法启动MySpider爬虫,并最终调用process.start方法启动整个爬取过程。

五、总结

本文以Python开源框架bubing为例,详细介绍了如何编写一个简单的网络爬虫程序。网络爬虫作为获取互联网信息的有效手段之一,在各个领域都有广泛应用。希望本文能够对初学者有所帮助。

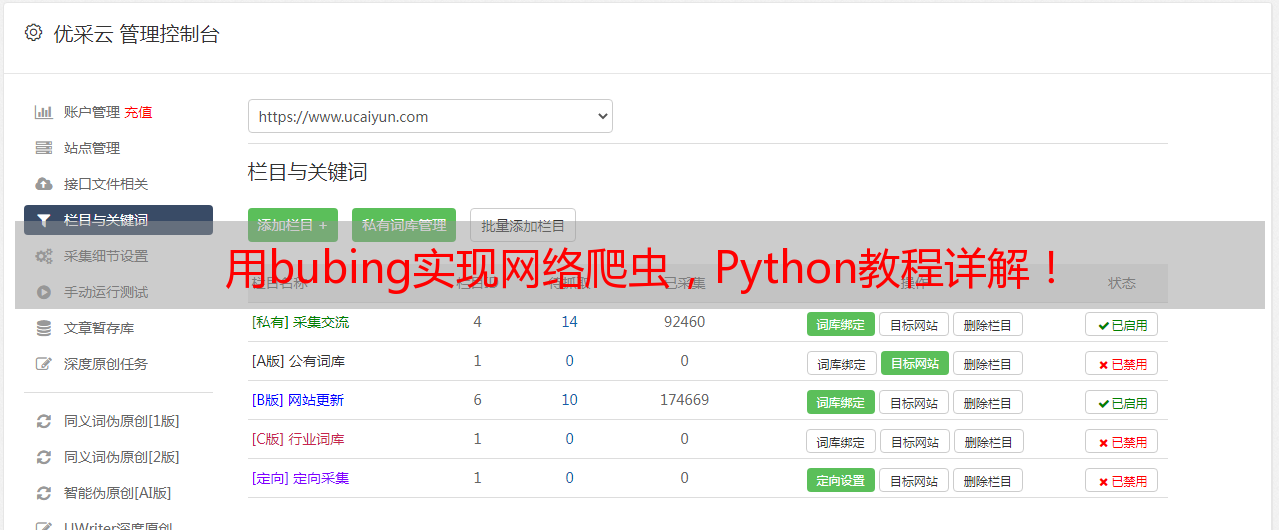

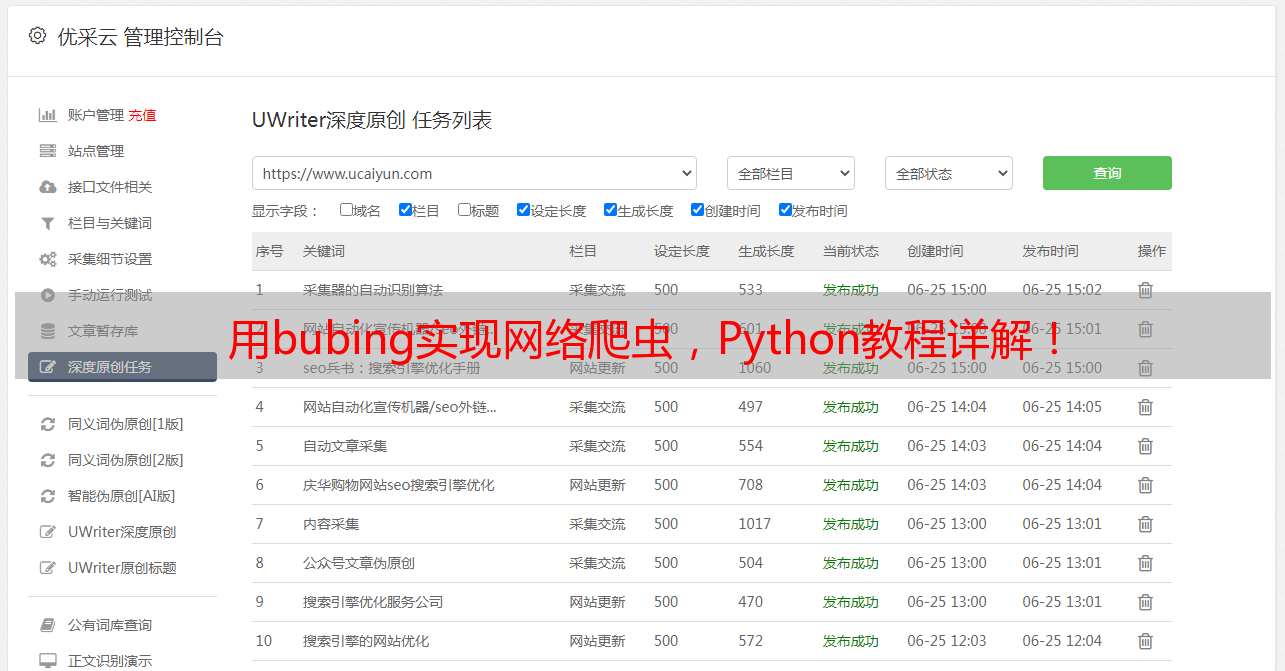

优采云(Ucaiyun)是一家专业的数字营销服务商,致力于为企业提供全方位数字营销解决方案。我们提供SEO优化、SEM竞价推广、社交媒体营销等服务。欢迎访问我们的官网www.ucaiyun.com了解更多详情。