Python抓取网页数据的利器:哪个库最强?

优采云 发布时间: 2023-03-20 08:22在当今信息爆炸的时代,海量的网页数据需要我们去挖掘和利用。而要想获取这些数据,我们首先需要做的就是抓取网页上的数据。那么,负责抓取网页数据的是什么库呢?下面就让我们一起来了解。

一、概述

对于抓取网页上的数据,最常用的就是Python中的网络爬虫技术。而在Python中,最常用的网络爬虫库就是requests和urllib库。这两个库可以帮助我们发送HTTP请求,并获取到响应内容。不过,它们仅仅只能获取到网页的源代码,并不能提供更多有用的信息。

二、BeautifulSoup

如果我们想要从源代码中提取出有用的信息,那么就需要使用BeautifulSoup库了。BeautifulSoup是一个Python包,它可以从HTML或XML文件中提取出特定标签内部或属性中所包含的信息,并以易读方式呈现出来。

三、Scrapy

Scrapy是一个Python爬虫框架,它可以帮助我们快速地开发一个高效、可扩展、分布式的网络爬虫系统。使用Scrapy框架可以大大简化爬虫程序的编写过程,并提高程序运行效率。

四、Selenium

Selenium是一个自动化测试工具,它可以模拟用户在浏览器上执行各种操作,并获取到相应结果。通过Selenium,我们可以实现模拟登录、填写表单等功能。

五、PyQuery

PyQuery是一个类似jQuery语法风格的Python解析器库,它可以方便地从HTML文档中提取出有用信息。与BeautifulSoup相比,PyQuery使用起来更加方便简单。

六、Pandas

Pandas是一种基于NumPy数组构建的数据结构和数据分析工具包。它提供了一种灵活高效的DataFrame对象,用于处理结构化数据(例如表格型数据)。

七、正则表达式

正则表达式(Regular Expression)是一种文本模式,用来匹配某些特定模式的文本。在Python中使用re模块可以轻松地实现正则表达式匹配功能。

八、总结

以上就是负责抓取网页数据常用的8个Python库了。每个库都有其独特之处,在不同场景下选择不同的库可以大大提高程序效率和准确度。当然,在实际应用中还需要考虑到反爬机制等问题,并进行相应处理。

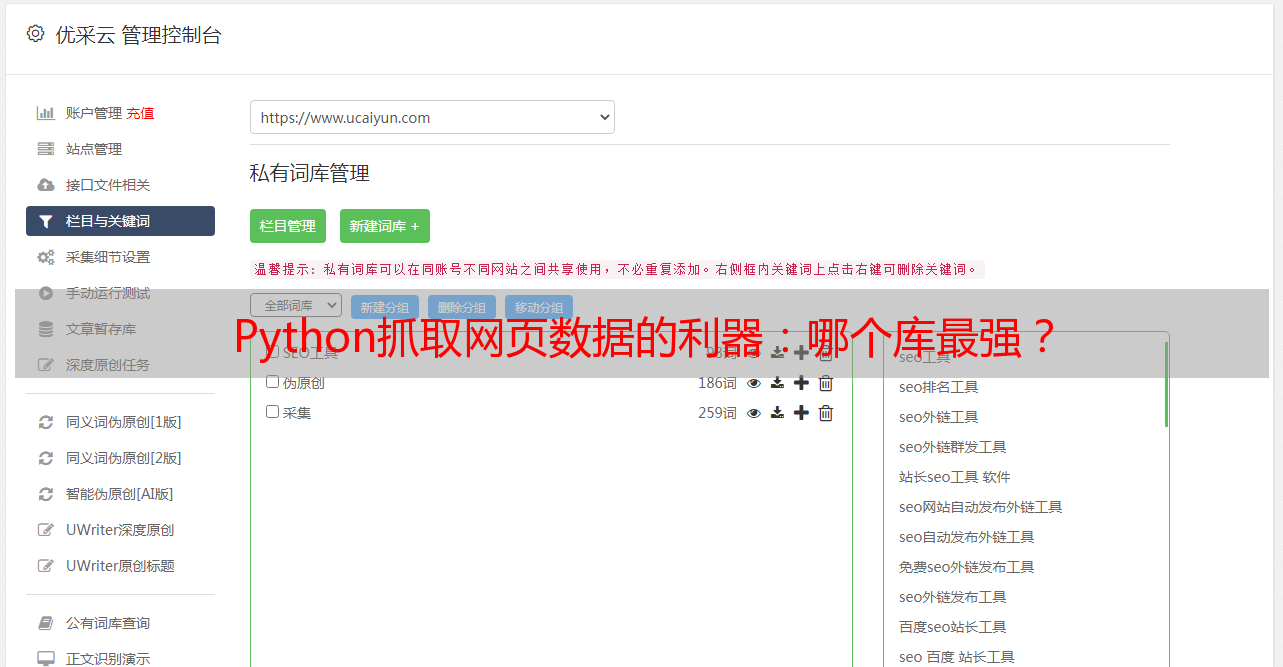

优采云为广大用户提供全面优质的SEO优化服务,欢迎访问www.ucaiyun.com了解详情。