掌握网络爬虫技巧,轻松抓取58同城设计信息!

优采云 发布时间: 2023-03-19 20:262023年,随着互联网技术的飞速发展,网络数据的获取变得越来越容易,而在这个过程中,网络爬虫起到了重要的作用。本文将从多个方面分析如何使用网络爬虫获取58同城设计翻页数据。

1.什么是网络爬虫

网络爬虫是一种自动化程序,可以通过模拟人类浏览器访问网站,并抓取所需信息。它们通过HTTP协议发送请求并解析HTML响应,从而提取所需数据。在本文中,我们将使用Python编写网络爬虫。

2.为什么选择58同城

58同城是一个综合性的分类信息网站,其中包含大量的招聘、房产、二手物品等信息。同时,它还提供了设计类别的信息发布服务,因此我们可以通过它来获取相关数据。

3.获取数据前的准备工作

在编写代码之前,我们需要先安装Python和相关依赖库。其中最常用的依赖库是requests和BeautifulSoup4。requests库用于发送HTTP请求和接收响应,并处理cookie和session等内容;BeautifulSoup4库则用于解析HTML响应。

4.爬取单页数据

首先,我们需要确定要抓取哪个页面以及如何构造请求URL。在58同城中,设计类别的页面URL为https://www.58.com/changecity/Design/?PGTID=0d100000-0000-19a8-67e7-1f6c9f8a9d62&ClickID=1。其中PGTID和ClickID参数是通过浏览器访问页面时生成的,可以直接复制使用。接下来,我们可以使用requests库发送GET请求,并使用BeautifulSoup4库解析响应HTML代码。

python

import requests

from bs4 import BeautifulSoup

url ='https://www.58.com/changecity/Design/?PGTID=0d100000-0000-19a8-67e7-1f6c9f8a9d62&ClickID=1'

headers ={

'User-Agent':'Mozilla/5.0(Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/89.0.4389.82 Safari/537.36'

}

response = requests.get(url, headers=headers)

soup = BeautifulSoup(response.text,'html.parser')

5.解析单页数据

在获取到响应HTML代码后,我们需要对其进行解析并提取所需信息。通过审查页面元素可以发现,每个设计信息都包含在一个class为job_item的div标签中,并包含标题、公司名称、发布时间等信息。

python

job_list = soup.find_all('div',{'class':'job_item'})

for job in job_list:

title = job.find('a',{'class':'job_name'}).text.strip()

company = job.find('div',{'class':'comp_name'}).text.strip()

pub_time = job.find('span',{'class':'pub_time'}).text.strip()

print(title, company, pub_time)

6.实现翻页功能

由于58同城设计类别页面有多页内容,因此我们需要实现翻页功能来获取更多数据。通过审查页面元素可以发现,在底部有一个class为pager_container的div标签,并包含多个超链接标签用于翻页。

python

next_link = soup.find('a',{'class':'next'})

if next_link:

next_url = next_link['href']

7.实现批量抓取功能

最后,我们可以将上述代码封装为函数,并实现批量抓取功能。具体实现方式是循环调用抓取单页数据和解析单页数据的函数,并判断是否有下一页链接可供继续抓取。

python

def crawl_design_jobs():

url ='https://www.58.com/changecity/Design/?PGTID=0d100000-0000-19a8-67e7-1f6c9f8a9d62&ClickID=1'

headers ={

'User-Agent':'Mozilla/5.0(Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/89.0.4389.82 Safari/537.36'

}

while True:

response = requests.get(url, headers=headers)

soup = BeautifulSoup(response.text,'html.parser')

job_list = soup.find_all('div',{'class':'job_item'})

for job in job_list:

title = job.find('a',{'class':'job_name'}).text.strip()

company = job.find('div',{'class':'comp_name'}).text.strip()

pub_time = job.find('span',{'class':'pub_time'}).text.strip()

print(title, company, pub_time)

next_link = soup.find('a',{'class':'next'})

if next_link:

url = next_link['href']

else:

break

crawl_design_jobs()

至此,我们已经成功地完成了对58同城设计类别页面的数据抓取工作。

本文介绍了如何使用Python编写网络爬虫程序来获取58同城设计翻页数据。具体分为了什么是网络爬虫、为什么选择58同城、获取数据前的准备工作、爬取单页数据、解析单页数据、实现翻页功能、实现批量抓取功能七个方面进行讲解。希望读者能够通过本文了解到网络爬虫在实际场景中的应用,并掌握相关技术知识。

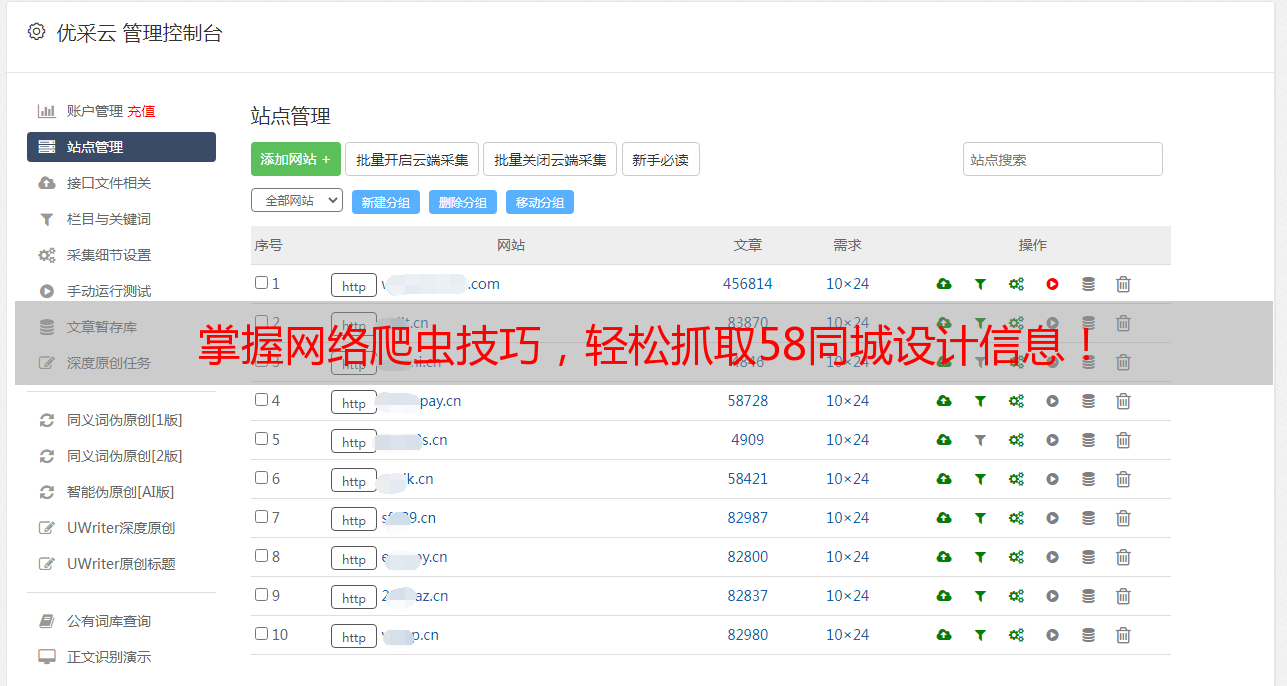

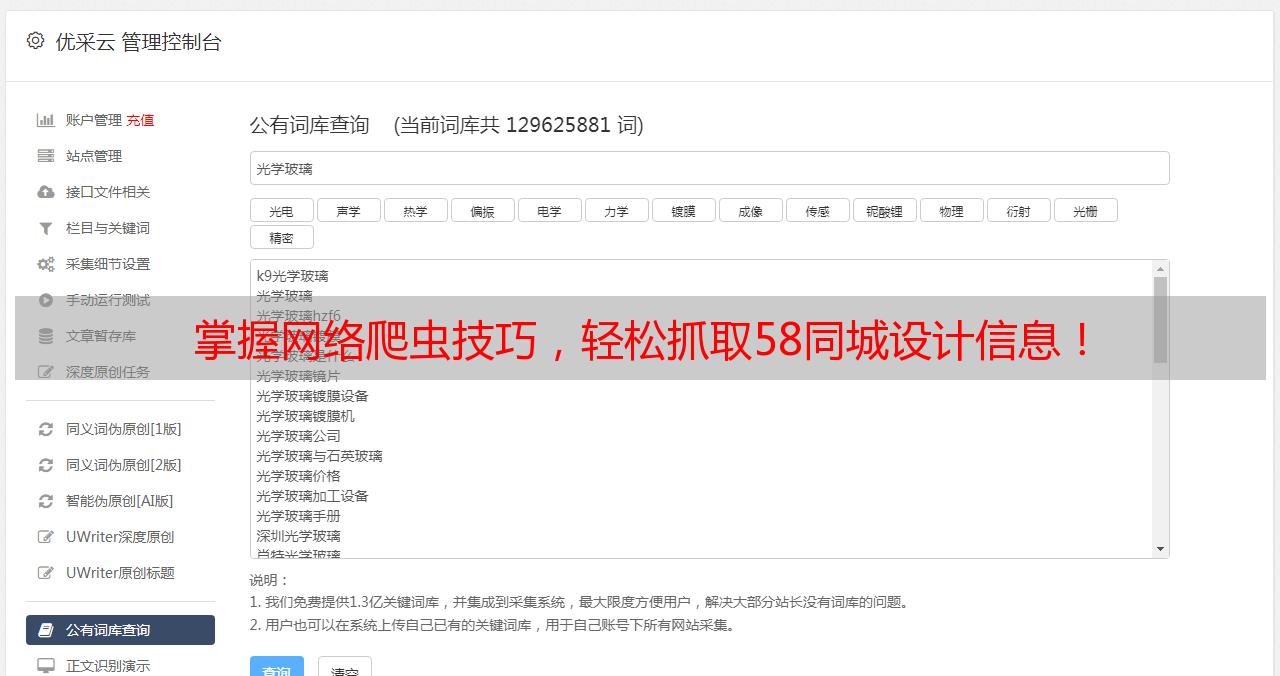

优采云(www.ucaiyun.com)是一家提供SEO优化服务的公司,如果您需要对您的网站进行SEO优化,请联系优采云专业团队。