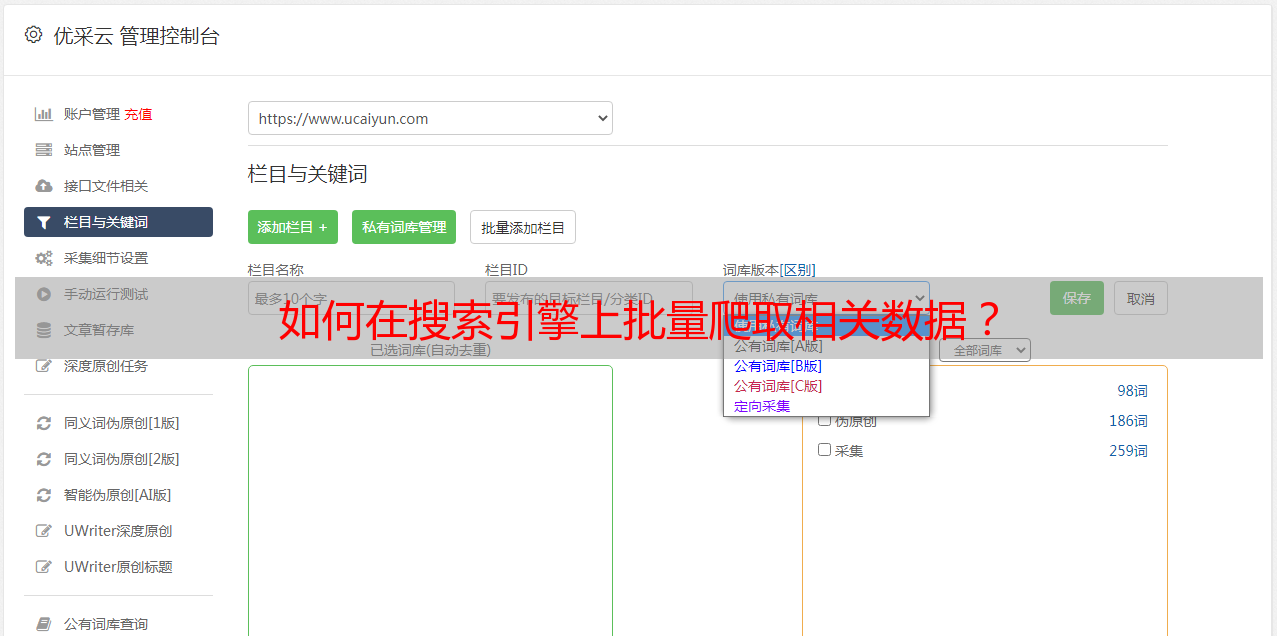

如何在搜索引擎上批量爬取相关数据?

优采云 发布时间: 2023-03-19 16:30搜索引擎爬虫是一种智能化程序,可以在互联网上自动获取信息并进行分类和归档。对于想要批量获取数据的用户来说,这是一种非常方便和高效的工具。本文将介绍如何在搜索引擎上批量爬取相关数据。

1.确定爬取目标

首先需要确定所需要爬取的数据类型和来源。比如,如果需要获取某个行业的企业信息,则可以选择百度、谷歌等搜索引擎进行爬取;如果需要获取某个网站或论坛的帖子信息,则可以选择针对该网站或论坛的特定爬虫程序。

2.编写程序代码

根据所选定的搜索引擎或特定网站,编写相应的程序代码。例如,在使用Python语言编写百度搜索引擎爬虫时,可以使用BeautifulSoup库进行页面解析,使用requests库进行网络请求,通过对HTML源码进行分析提取所需信息。

python

import requests

from bs4 import BeautifulSoup

url ="https://www.baidu.com/s?wd=keyword"

response = requests.get(url)

soup = BeautifulSoup(response.text,"html.parser")

result_list = soup.find_all("div", class_="result")

for result in result_list:

title = result.h3.a.text

link = result.h3.a["href"]

print(title, link)

3.设置爬取参数

在编写完程序代码后,需要设置相应的爬取参数。这些参数包括:搜索关键词、页数、时间范围、排序方式等等。通过设置这些参数,可以更精准地筛选所需信息,提高爬取效率。

4.防止被封禁

在进行*敏*感*词*数据爬取时,需要注意防止被封禁。为了避免被封禁或者遭到反爬虫机制的攻击,可以采用以下措施:

-设置合理的请求间隔时间;

-使用代理IP;

-随机更换User-Agent头信息;

-对于反爬虫机制较为严格的网站,可以使用Selenium等自动化测试工具模拟真实浏览器行为。

5.数据清洗和处理

在完成数据爬取后,还需要进行数据清洗和处理。这些工作包括去重、过滤无用信息、格式转换等等。通过对数据进行清洗和处理,可以使得所得到的数据更加准确、规范化。

6.存储和分析数据

最后一步是存储和分析数据。根据所需求解决方案来选择适当的存储方式,并进行进一步分析和挖掘。

总结:

本文介绍了如何在搜索引擎上批量爬取相关数据,并从六个方面详细阐述了具体步骤:确定目标、编写程序代码、设置参数、防止被封禁、数据清洗和处理以及存储与分析数据。希望本文能够对广大用户有所帮助。