工具详解:高效抓取网站数据的方法与技巧

优采云 发布时间: 2023-03-19 01:18在网络时代,信息获取变得越来越容易,但是对于需要大量数据的分析和研究者来说,如何快速高效地抓取网站数据成为了一项必备技能。本文将介绍如何使用工具抓取网站数据。

一、了解网站结构

在开始抓取之前,需要先了解网站的结构。网站的结构决定了我们应该采用哪种方式进行抓取。例如,如果网站的结构比较简单,只需要爬取几个页面就可以获取所需数据,那么我们可以采用基于 URL 的爬虫工具;如果网站的结构比较复杂,需要模拟用户行为才能获取所需数据,那么我们可以考虑使用浏览器自动化工具。

二、选择合适的工具

有很多种工具可以用来爬取网站数据,不同工具适用于不同场景。下面列举几个常用的工具:

1. Scrapy

Scrapy 是一个开源的 Python 爬虫框架,它可以帮助我们快速高效地编写爬虫程序。Scrapy 支持异步网络库 Twisted 和 lxml 解析库,并且提供了强大的处理机制和中间件机制。

2. Beautiful Soup

Beautiful Soup 是一个 Python 的库,它可以从 HTML 或 XML 中提取数据。Beautiful Soup 提供了一些简单又实用的方法帮助我们快速高效地进行数据提取。

3. Selenium

Selenium 是一个浏览器自动化工具,它可以模拟用户在浏览器中的操作。Selenium 可以帮助我们处理复杂的 AJAX 请求和 JavaScript 渲染,并且支持多种浏览器。

三、编写爬虫程序

选择好合适的工具之后就可以开始编写爬虫程序了。编写爬虫程序需要注意以下几点:

1.设置请求头

设置请求头可以让我们模拟浏览器发送请求,避免被服务器识别为爬虫并拒绝访问。

2.处理反爬机制

有些网站会设置反爬机制来防止爬虫程序访问。这时候我们需要使用一些技巧来规避反爬机制,例如设置延迟时间、随机更换 User-Agent 等。

3.数据清洗和存储

获取到数据之后需要进行清洗和存储。清洗数据可以帮助我们去除无用信息,并且规范化数据格式;存储数据可以帮助我们方便地进行后续分析和研究。

四、常见问题及解决方案

在实际使用中可能会遇到各种问题,下面列举几个常见问题及解决方案:

1. IP 被封禁

如果被封禁了 IP 地址,我们可以使用代理 IP 来进行访问。

2.数据量过大导致内存溢出

如果要处理大量数据可能会导致内存溢出,在这种情况下我们可以使用分布式技术或者将数据存储到数据库中。

3.代码失效

由于网站结构变化或者反爬机制更新等原因可能会导致代码失效,在这种情况下我们需要根据实际情况进行修改和更新。

五、总结与展望

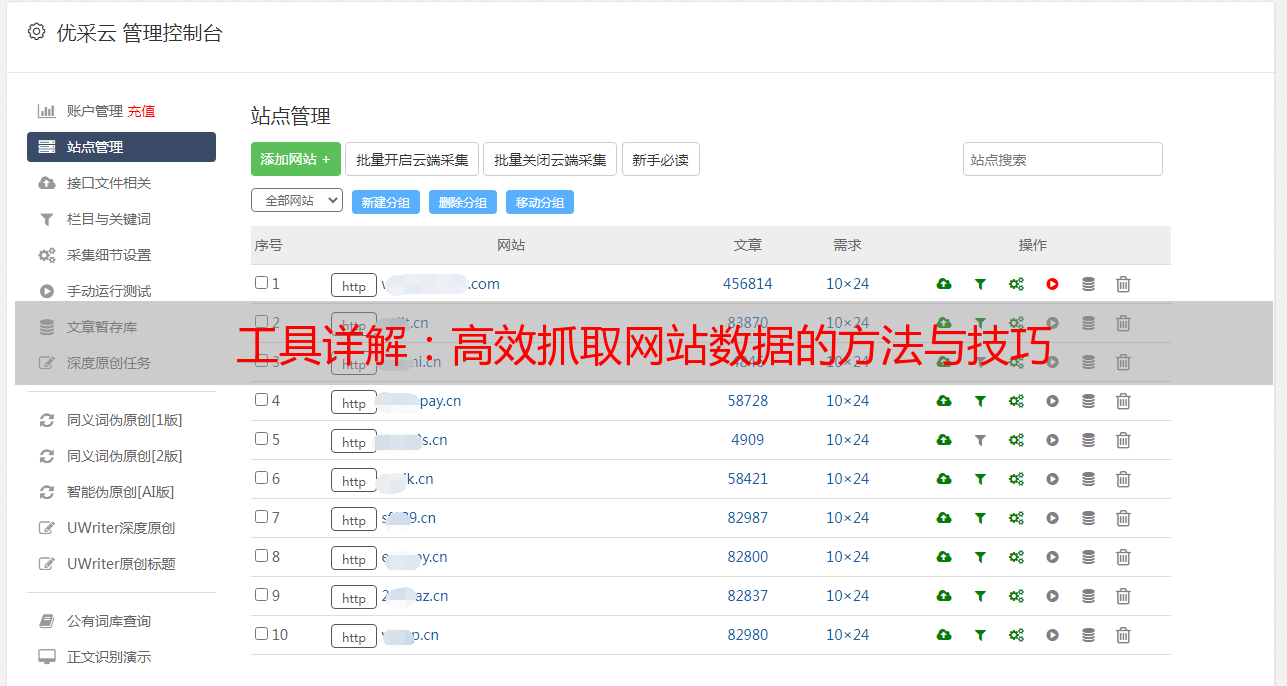

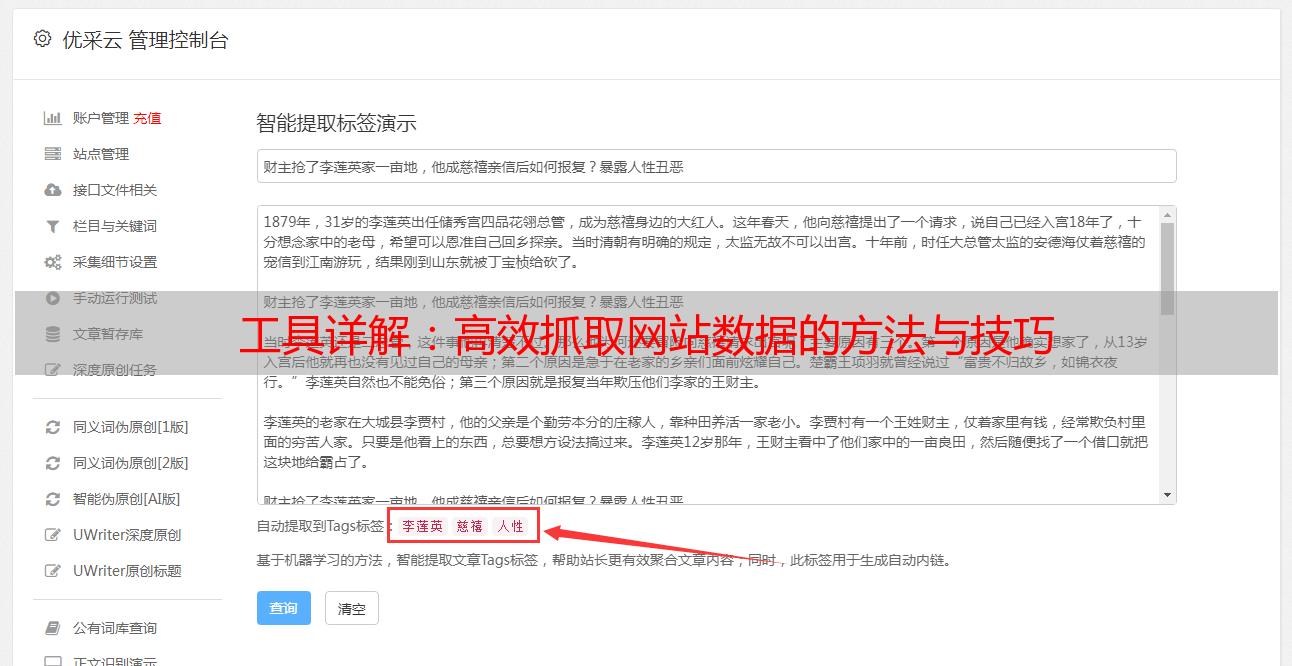

本文介绍了如何使用工具抓取网站数据,并且针对实际问题提出了解决方案。未来随着人工智能技术和大数据技术的不断发展,抓取网站数据将变得更加智能化和高效化。优采云是专业的 SEO 优化服务提供商,在 SEO 优化领域拥有丰富经验和专业技能,请登录 www.ucaiyun.com 了解更多信息。