实例演示:Python自动抓取工具的使用方法详解

优采云 发布时间: 2023-03-18 14:21在互联网时代,数据是一切的基础。对于很多公司和个人而言,如何从海量的数据中获取有价值的信息是非常重要的。而Python自动抓取工具可以帮助我们快速、准确地获取所需的数据。本文将介绍Python自动抓取工具的使用方法,并提供实例演示。

1.确定需要爬取的网站

在使用Python自动抓取工具前,首先需要确定需要爬取哪个网站。一般来说,我们需要爬取的网站都会有一些特定的特征,比如页面结构、数据类型等。因此,在选择目标网站时,需要考虑这些因素。

2.安装必要的库

在使用Python自动抓取工具前,需要安装一些必要的库,比如requests、BeautifulSoup等。这些库可以帮助我们发送请求、解析HTML等操作。

3.发送请求并获取HTML

使用requests库可以轻松地发送HTTP请求,并获取返回结果。例如:

python

import requests

url ='https://www.example.com'

response = requests.get(url)

html = response.text

4.解析HTML并提取数据

使用BeautifulSoup库可以轻松地解析HTML,并提取出其中所需的数据。例如:

python

from bs4 import BeautifulSoup

soup = BeautifulSoup(html,'html.parser')

title = soup.title.string

5.存储数据并进行后续分析

在获取所需数据后,可以将其存储到文件或数据库中,并进行后续分析。例如:

python

import pandas as pd

df = pd.DataFrame(data)

df.to_csv('data.csv', index=False)

6.避免被反爬虫机制拦截

为了避免被目标网站的反爬虫机制拦截,我们需要采用一些策略,比如设置合理的访问频率、添加随机延迟等。

7.实例演示:爬取新浪新闻首页数据

下面我们以爬取新浪新闻首页数据为例进行演示。

python

import requests

from bs4 import BeautifulSoup

url ='https://news.sina.com.cn/'

headers ={

'User-Agent':'Mozilla/5.0(Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.36'}

response = requests.get(url, headers=headers)

html = response.text

soup = BeautifulSoup(html,'html.parser')

news_list = soup.select('.news-1> li')

for news in news_list:

title = news.select_one('a').string.strip()

link = news.select_one('a')['href']

print(title, link)

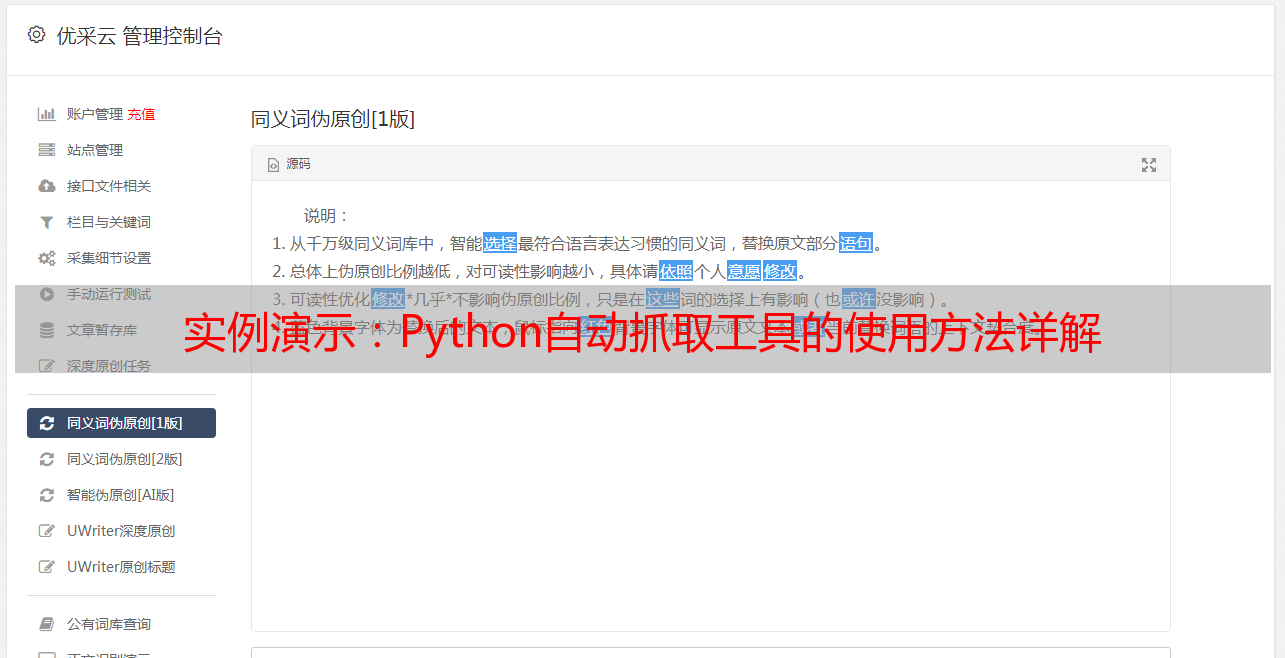

8.使用优采云进行SEO优化

对于想要将爬取到的数据用于SEO优化的用户而言,可以考虑使用优采云进行相关操作。优采云是一款专业的SEO优化工具,可以帮助用户对网站进行全面优化,并提高其在搜索引擎中的排名。

9.总结

本文介绍了Python自动抓取工具的基本原理和使用方法,并提供了实例演示。希望读者通过本文能够更好地掌握Python自动抓取工具,并在实际应用中发挥其作用。

10.参考资料:

1)《Python网络爬虫实战》;

2)https://www.crummy.com/software/BeautifulSoup/bs4/doc.zh/