轻松入门:网页数据爬虫方案解析及实现技巧

优采云 发布时间: 2023-03-18 13:20近年来,随着互联网信息量的爆炸式增长,人们对于获取数据和信息的需求也与日俱增。而网页数据爬虫方案,则成为了一种高效、快捷、准确的数据获取方式。本文将从多个角度,详细介绍网页数据爬虫方案的相关知识。

一、什么是网页数据爬虫?

网页数据爬虫是指利用计算机程序对互联网上公开的信息进行自动化抓取和提取处理的技术。它主要通过模拟人类浏览器的行为,访问目标网站并按照预定规则提取所需信息。在实际应用中,网页数据爬虫可以帮助我们自动化地从海量数据中筛选出有价值的信息,并将其整理成结构化的格式。

二、网页数据爬虫的应用场景

1.市场调研:企业可以通过网页数据爬虫来监测竞争对手和行业趋势。

2.舆情分析:政府、企业等可以通过网页数据爬虫来了解公众对于特定事件或话题的态度和反应。

3.产品价格监控:电商平台可以通过网页数据爬虫来实时监测竞争对手产品价格变化情况。

4.搜索引擎优化:SEO优化人员可以通过网页数据爬虫来收集关键词排名、页面质量等相关信息。

三、常见的网页数据爬虫工具

1. BeautifulSoup:一个Python库,用于从HTML和XML文件中提取信息。

2. Scrapy:一个Python框架,可用于快速构建和扩展网络爬虫。

3. Selenium:一个自动化测试工具,也可用于模拟浏览器行为进行网络爬取。

4. Fiddler:一个Windows平台下的HTTP调试代理服务器工具,可用于网络协议分析和Web调试等任务。

四、如何构建一个简单的网络爬虫?

以下是一个基于Python语言编写的简单网络爬虫示例:

python

import requests

from bs4 import BeautifulSoup

url ='https://www.ucaiyun.com'

res = requests.get(url)

soup = BeautifulSoup(res.text,'html.parser')

print(soup.title.string)

以上代码使用requests库向目标URL发起请求,并使用BeautifulSoup库解析HTML页面内容。最后输出页面标题字符串。

五、如何避免被封IP?

在进行网络爬取时,很容易被目标网站封禁IP地址。因此,在进行网络爬取时需要注意以下几点:

1.合理设置请求频率,并加入随机时间间隔;

2.遵守robots.txt协议;

3.不要过度请求同一IP地址;

4.使用代理IP或者Tor等匿名代理服务;

5.合理设置User-Agent头部信息。

六、如何处理反爬机制?

很多目标站点都会采取反扒措施以防止被大量抓取。以下是几种常见反扒措施:

1.IP限制:同一IP地址访问次数超过限制就会被封禁;

2.User-Agent限制:检查User-Agent头部信息是否符合浏览器标准;

3.Cookie验证:检查请求是否携带正确的Cookie;

4.验证码验证:需要输入验证码才能继续访问页面;

5.JS渲染验证:使用JS动态生成页面内容,使得无法直接从HTML中获取所需信息。

针对以上反扒措施,我们可以采取以下方法进行应对:

1.IP池或者代理池技术;

2.User-Agent随机化技术;

3.Cookie池技术或者登录状态保持技术;

4.验证码识别技术或者人工处理技术;

5.JS逆向工程技术或者直接模拟JS执行环境。

七、如何应对法律风险?

在进行网络抓取时,需要注意遵守相关法律法规。以下是一些常见法律风险:

1.侵犯他人隐私权或者商业秘密;

2.侵犯著作权或者专利权;

3.恶意竞争或者商业欺诈等行为。

为了避免法律风险,在进行网络抓取时需要注意以下几点:

1.遵守robots.txt协议;

2.仅抓取公开可见的页面内容;

3.不要盗用他人商业秘密或者个人隐私信息;

4.不要恶意攻击目标站点造成不必要损失。

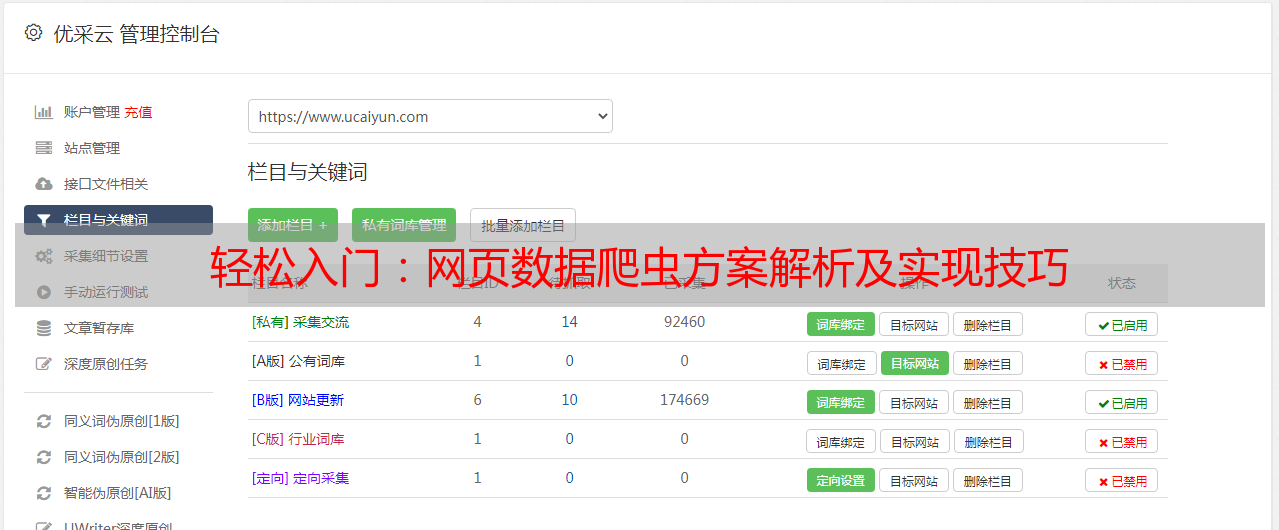

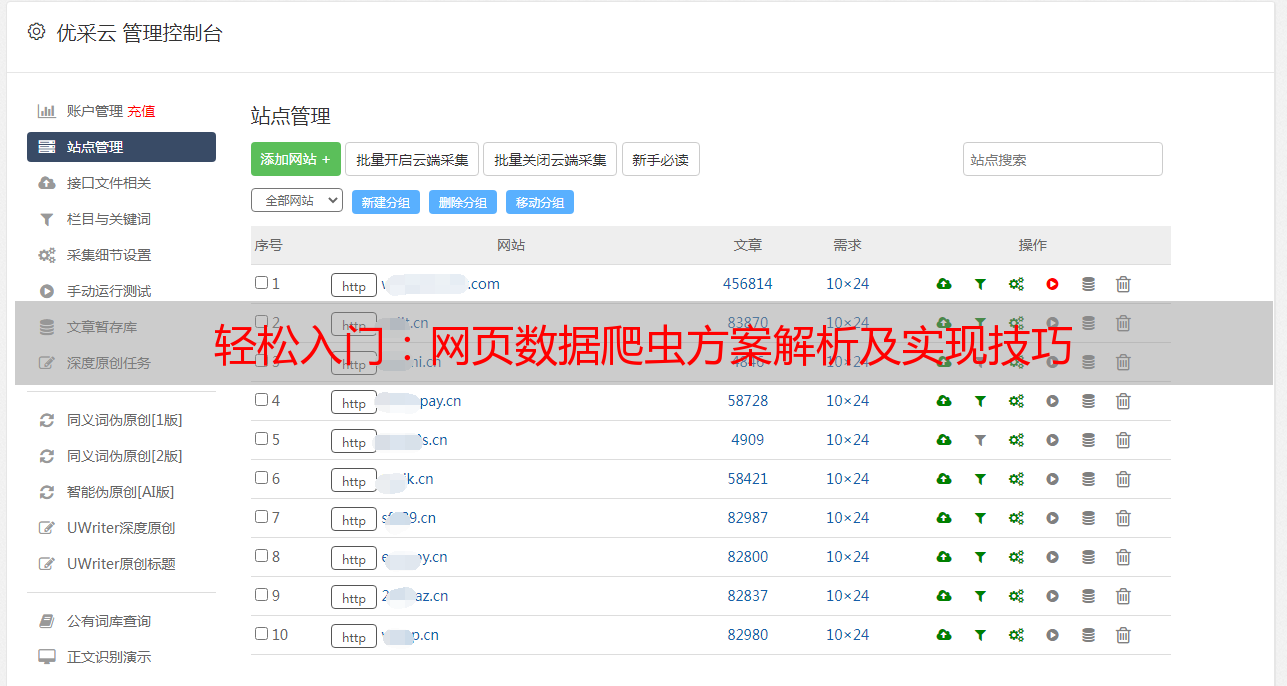

八、使用优采云提高效率和精度

优采云是一款强大高效的云端数据采集平台,在进行*敏*感*词*复杂的网络抓取任务时可以极大地提高效率和精度。其主要特点包括:

1.强大稳定:基于分布式架构设计,并且采用最新AI技术支持智能识别和处理页面结构变化等情况。

2.易于使用:无需编写代码即可完成复杂任务配置,并且支持海量URL管理和自定义任务调度等功能。

3.灵活定制:支持自定义脚本和插件开发,并且支持多种输出格式(CSV、JSON、Excel等)以及API接口调用等功能。

九、如何进行SEO优化?

在进行网络抓取时,如果想要使得所获取到的内容更容易被搜索引擎发现并排名靠前,则需要注意以下几点:

1.URL结构规范性(尽量简洁明了);

2.Meta标签设置(Title,Description,Keywords);

3.HTML结构优化(H1~H6标题标签规范性);

4.Content内容质量(原创性、关键词密度);

5.Outgoing Links外链数量及质量(友情链接);

6.Internal Links内链数量及质量(文章推荐);

7.Mobile-friendly移动设备友好性(响应式设计);

8.Site speed站点速度(图片压缩、CDN加速);

9.Sitemap.xml提交(方便搜索引擎抓取);

10.Robots.txt文件设置(限制搜索引擎抓取范围).

十、总结

本文详细介绍了网页数据爬虫方案相关知识,并从多个角度逐步分析讨论了其实现方式以及应用场景。同时还介绍了如何避免被封IP以及如何处理反扒机制等问题,并且给出了SEO优化方案以及使用优采云提高效率和精度等实践建议。希望本文可以帮助读者更好地理解并应用网页数据爬虫方案。