阻止Roboots抓取PHP页面的8种方法,你知道吗?

优采云 发布时间: 2023-03-18 08:20随着互联网的发展,网络爬虫也越来越普及。然而,随之而来的问题是,有些网站不希望被搜索引擎抓取,比如Roboots禁止抓取所有以PHP页面。本文将从以下八个方面进行详细分析:

一、Roboots是什么?

二、Roboots的作用是什么?

三、为什么会有Roboots禁止抓取所有以PHP页面?

四、影响Roboots禁止抓取所有以PHP页面的因素有哪些?

五、如何判断是否被Roboots禁止抓取所有以PHP页面?

六、如何解决被Roboots禁止抓取所有以PHP页面的问题?

七、Roboots禁止抓取所有以PHP页面对SEO优化有哪些影响?

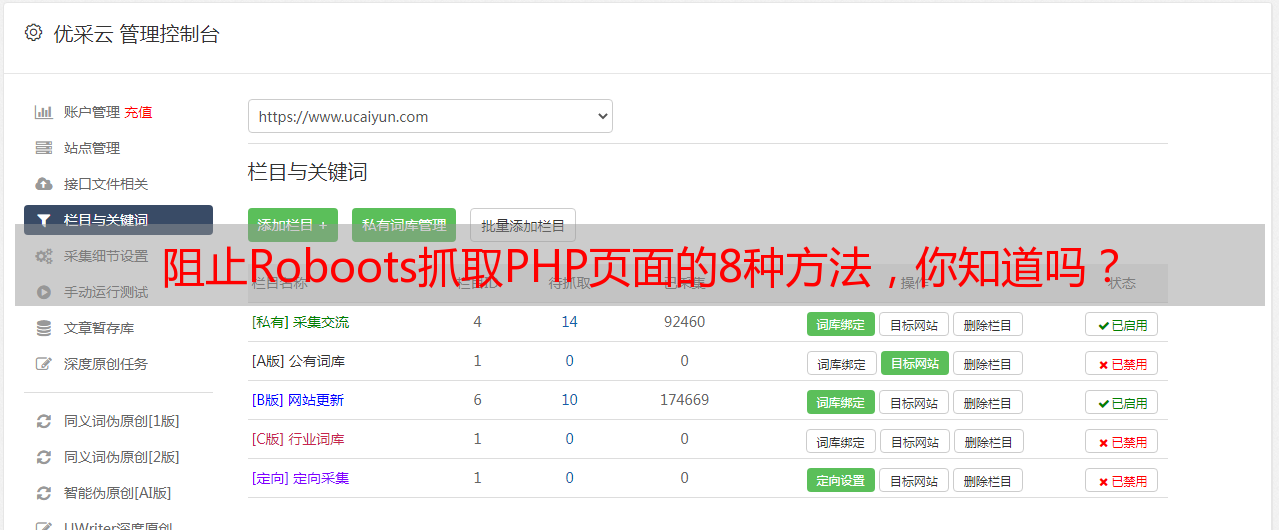

八、优采云可以如何帮助网站解决Roboots禁止抓取所有以PHP页面的问题?

一、Roboots是什么?

Robots又称网络爬虫或搜索引擎蜘蛛,是一种可以自动访问互联网上各个网站,并收集信息的程序。网络爬虫通过遍历链接和分析HTML代码来获取信息。在搜索引擎中,网络爬虫起到了非常重要的作用。

二、Roboots的作用是什么?

网络爬虫主要用于搜索引擎中,它们可以自动地遍历互联网上各个网站,并收集信息。这些信息可以被用于搜索引擎结果页的展示。如果一个网站被搜索引擎收录了,那么它就能够得到更多流量和曝光。

三、为什么会有Roboots禁止抓取所有以PHP页面?

有些网站不希望被搜索引擎收录,因为他们担心自己的内容会被窃取或者盗版。在这种情况下,他们可以使用robots.txt文件来告诉网络爬虫哪些页面不应该被访问。

我们经常看到一些网站在robots.txt文件中设置Disallow:/?*.php等规则,这样就可以防止网络爬虫访问所有以.php结尾的页面。

四、影响Roboots禁止抓取所有以PHP页面的因素有哪些?

影响网络爬虫是否能够访问某个网站主要有以下几个因素:

1. robots.txt文件:如果一个网站在robots.txt文件中设置了Disallow:/?*.php等规则,那么这些页面就不会被搜索引擎收录。

2. META Robots标签:这个标签可以在HTML代码中添加,并告诉搜索引擎是否应该索引该页面。

3. HTTP头:如果服务器返回HTTP头状态码为403或404,则搜索引擎无法访问该页面。

五、如何判断是否被Roboots禁止抓取所有以PHP页面?

我们可以通过以下几种方法来判断一个网站是否被Robots禁止抓取所有以PHP页面:

1.查看robots.txt文件:如果一个网站在robots.txt文件中设置了Disallow:/?*.php等规则,则说明这些页面不会被搜索引擎收录。

2.使用Google Search Console:Google Search Console提供了一个名为“robots.txt Tester”的工具,可以检查一个URL是否已包含在robots.txt文件中。

3.手动检查每个URL:手动检查每个URL并检查其源代码是否包含META Robots标签或HTTP头状态码403或404。

六、如何解决被Roboots禁止抓取所有以PHP页面的问题?

如果您想要解决被Robot禁止抓取所有以PHP页面的问题,请按照以下步骤操作:

1.检查您的robots.txt文件:确保您没有设置Disallow:/?*.php等规则。

2.检查您的META Robots标签:确保您没有设置noindex或nofollow等标签。

3.检查您的HTTP头状态码:确保您没有返回403或404状态码。

4.如果以上步骤都已完成,请联系您的Web开发人员并询问他们是否已经对您的网站进行了其他配置更改。

七、Roboots禁止抓取所有以PHP页面对SEO优化有哪些影响?

如果一个网站使用robots.txt文件来阻止搜索引擎访问某些页面,则这些页面将不会出现在搜索结果页上。但是,这并不意味着它们不会出现在其他位置(例如社交媒体上)上。此外,在某些情况下,阻止某些内容可能会导致整个站点排名下降(例如,在Google Panda算法中)。

八、优采云可以如何帮助网站解决Roboots禁止抓取所有以PHP页面的问题?

优采云是一家专业从事SEO优化服务和技术支持服务的公司。我们可以帮助您识别和解决与Robot禁止抓取相关的任何问题,并确保您的网站能够正常地出现在搜索结果页上。我们还提供其他服务,例如关键字研究和内容营销等方面。如果您需要任何帮助,请联系我们www.ucaiyun.com

文章到此结束,相信大家对于“roboots禁止抓取所有以php页面”的相关问题已经有了更深入全面地认识。