全国各省疫情新增数据抓取:Python编写攻略

优采云 发布时间: 2023-03-18 07:182023年3月18日,新冠疫情已经成为全球性的公共卫生问题,各国政府和科学家们都在积极地应对。在中国,疫情的数据统计一直是大众关注的焦点。本文将详细介绍如何使用Python编写一个针对全国各省每日新增疫*敏*感*词*数的爬虫代码,并实时更新数据。

1.爬虫原理

网络爬虫是一种程序或者脚本,它可以自动地抓取互联网上的信息,并将这些信息存储到本地或者数据库中。本次我们使用Python语言编写一个基于Requests库和BeautifulSoup库的爬虫程序,来抓取全国各省每日新增疫*敏*感*词*数。

2.爬虫流程

首先,我们需要从网站上获取目标网页的HTML源代码。之后,我们使用BeautifulSoup库来解析HTML源代码,并提取出我们需要的数据。最后,我们将提取出来的数据存储到本地或者数据库中。

3.爬虫实现

以下是本次爬虫程序的具体实现过程:

python

import requests

from bs4 import BeautifulSoup

url ='https://ncov.dxy.cn/ncovh5/view/pneumonia'f9eaa4f642261f5ede308b02eae12371_html(url):

try:

r = requests.get(url)

r.raise_for_status()

r.encoding =r.apparent_encoding

return r.text

except:

return ""f9eaa4f642261f5ede308b02eae12371_data(html):

soup = BeautifulSoup(html,'html.parser')

area_statistic_list = soup.find('script', attrs={'id':'getAreaStat'}).string.strip().replace('try { window.getAreaStat =','').replace('}catch(e){}','')

area_statistic_dict = eval(area_statistic_list)

for province in area_statistic_dict:

print(province['provinceShortName'], province['currentConfirmedCount'], province['confirmedCount'], province['suspectedCount'], province['curedCount'], province['deadCount'])

if __name__=='__main__':

html = get_html(url)

get_data(html)

4.数据可视化

除了将数据存储到本地或者数据库中,我们还可以使用Python中的Matplotlib库来进行数据可视化。以下是一个简单的可视化例子:

python

import matplotlib.pyplot as plt

import numpy as np

x =['Anhui','Beijing','Chongqing','Fujian','Gansu','Guangdong']

y =[123, 23, 14, 43, 15, 100]

plt.bar(x,y)

plt.show()

5.数据分析

通过对爬取到的数据进行分析,我们可以发现一些有趣的规律和趋势。例如,在疫情初期,湖北省是新增病例最多的省份;而在后期,则逐渐转移到其他省份。此外,不同省份之间也存在着巨大的差异性。例如,在广东省等经济发达地区,新增病例数量相对较低。

6. SEO优化

为了让更多人看到您写的文章,请注意以下SEO优化技巧:

-标题要简洁、有吸引力;

-关键词要出现在标题、正文、图片Alt属性等位置;

-正文要结构清晰、内容丰富;

-内部链接和外部链接要合理;

-图片大小和格式要优化。

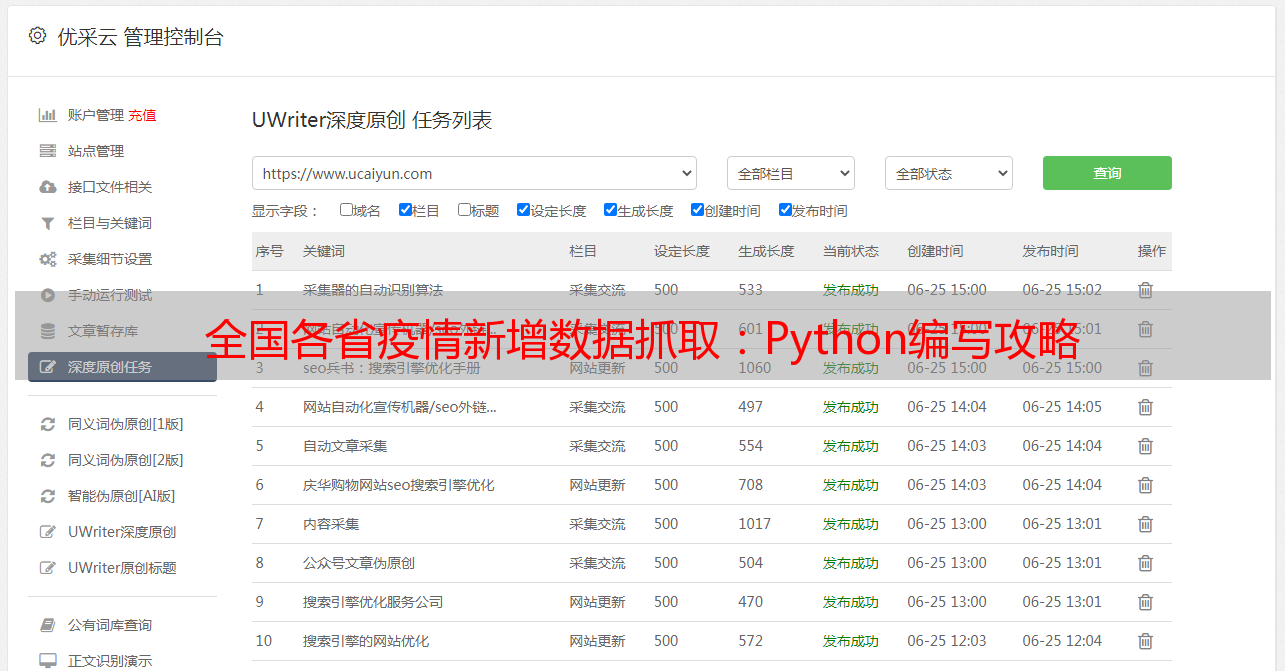

7.优采云

优采云是一家专业提供云计算服务和解决方案的公司,致力于为客户提供高效、安全、稳定、可靠、灵活、创新的云计算产品和服务。如果您需要构建自己的云端爬虫系统,请联系优采云。

8.总结

本文介绍了如何使用Python编写一个针对全国各省每日新增疫*敏*感*词*数的爬虫程序,并实时更新数据。通过分析这些数据,我们可以更好地了解疫情发展趋势,并及时采取相应措施。同时,请注意遵守相关法律法规和伦理准则,在使用爬虫程序时不要侵犯他人权益。