拒绝搜索引擎机器人?10大分析与探讨

优采云 发布时间: 2023-03-17 15:20搜索引擎机器人是搜索引擎公司派遣的自动程序,循规蹈矩地爬取网站内容,将其收录到搜索引擎数据库中。然而,有些网站不希望被搜索引擎机器人收录,因为这可能会泄露网站的隐私信息。那么,如何禁用搜索引擎机器人呢?本文将从以下10个方面进行分析讨论。

1. robots.txt文件

robots.txt文件是一种文本文件,位于网站根目录下,用于告诉搜索引擎哪些页面可以被爬取,哪些页面不能被爬取。如果想禁止某个搜索引擎机器人访问整个网站,可以在robots.txt文件中添加以下代码:

User-agent:搜索引擎名称

Disallow:/

例如,如果想禁止百度搜索引擎机器人访问整个网站,可以在robots.txt文件中添加以下代码:

User-agent: Baiduspider

Disallow:/

2. noindex标签

noindex标签是一种HTML标签,在网页头部添加<meta name="robots" content="noindex">即可禁止该页面被搜索引擎收录。

3. nofollow标签

nofollow标签也是一种HTML标签,在超链接中添加rel="nofollow"即可告诉搜索引擎不要跟踪该链接。这对于禁止搜索引擎机器人访问某些页面非常有用。

4. HTTP状态码

HTTP状态码是指在HTTP协议中服务器向客户端返回的状态码。当服务器返回403或401状态码时,表示客户端无权访问该页面。这对于禁止搜索引擎机器人访问某些页面同样非常有用。

5.登录验证

如果某些页面只允许登录用户访问,那么这些页面就不会被搜索引擎机器人收录。因此,在网站中设置登录验证功能是一种有效的禁用搜索引擎机器人的方法。

6. IP限制

IP限制是指只允许特定IP地址范围内的用户访问某些页面。如果将该功能应用到搜索引擎机器人上,就可以有效地防止其访问某些页面。

7. JavaScript跳转

JavaScript跳转是指利用JavaScript代码实现跳转功能。由于大多数搜索引擎机器人不支持JavaScript解析,因此使用JavaScript跳转可以有效地防止其访问某些页面。

8.动态URL重写

动态URL重写是指将动态URL转换为静态URL的过程。由于大多数搜索引擎机器人只能识别静态URL,因此使用动态URL重写可以有效地防止其访问某些页面。

9. CDN加速

CDN加速是指利用CDN服务提供商的网络加速技术来加速网站内容传输和分发的过程。由于大多数CDN服务提供商都可以屏蔽搜索引擎机器人的爬取请求,因此使用CDN加速也可以有效地防止其访问某些页面。

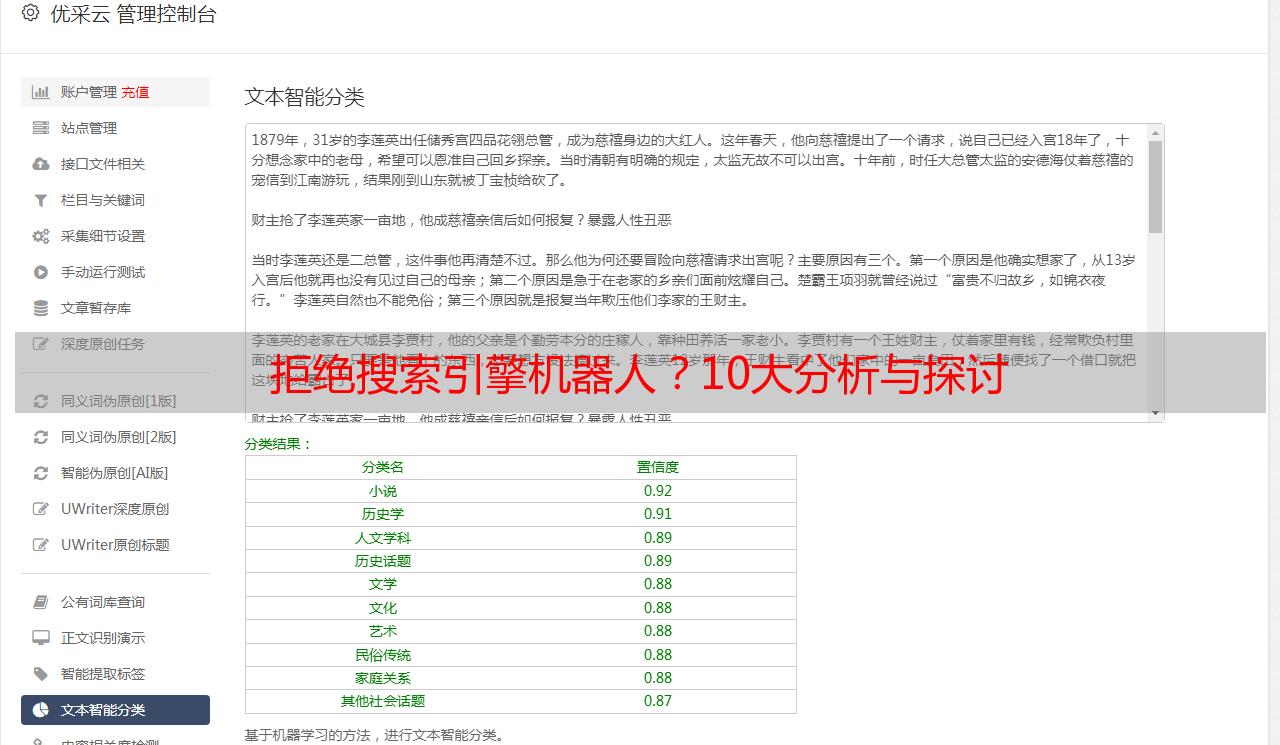

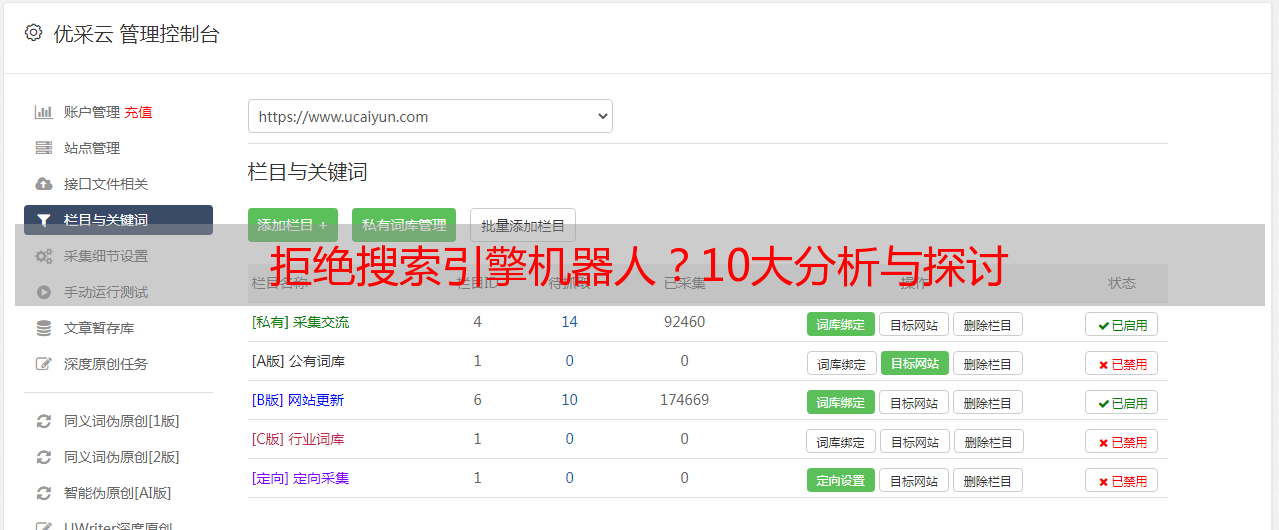

10.使用专业工具

除了以上几种方法外,还可以使用专业工具来禁用搜索引擎机器人。例如,“优采云”就是一款专门针对SEO优化的工具,在其中设置“禁止蜘蛛爬行”选项即可禁用所有搜索引擎机器人的访问。

总之,在保护网站隐私方面,禁用搜索引擎机器人是一种非常重要且必要的手段。我们可以结合以上10个方面进行综合应用,以达到最佳效果。