高效获取所需图片,PHP抓取与Python爬虫实现技巧详解

优采云 发布时间: 2023-03-17 12:15在当今的信息时代,我们每天都要面对大量的图片信息。无论是社交媒体、新闻网站还是各种广告,图片都是不可或缺的一部分。而这些图片往往是散布在互联网的各个角落,如果要手动一个一个下载,工作量将会非常巨大。那么,有没有一种方法可以轻松实现批量下载图片呢?本文将介绍 PHP 抓取图片 Python 爬虫的实现方法,帮助您高效地获取所需图片。

一、概述

随着互联网的发展,网络爬虫技术越来越成熟。Python 作为一门强大的编程语言,在网络爬虫方面也有着出色的表现。而 PHP 作为一种流行的服务器端脚本语言,则可以快速地处理数据和生成动态页面。因此,结合 PHP 和 Python 的优势,我们可以轻松实现抓取图片。

二、准备工作

在开始之前,需要确保您已经安装了以下软件:

1.d5e09a66deec0a7b149aaddcb9b55db5.x版本

2. requests 库

3. BeautifulSoup4 库

4. PHP 5.x或更高版本

5. Apache 或 Nginx 等 Web 服务器

6.一台能够访问互联网的服务器或个人电脑

三、解析网页

首先,我们需要通过 Python 解析网页并获取图片链接地址。以下是一个简单的 Python 程序示例:

python

import requests

from bs4 import BeautifulSoup

url ="https://www.example.com"

res = requests.get(url)

soup = BeautifulSoup(res.text,"html.parser")

for img in soup.find_all("img"):

print(img["src"])

在上述程序中,我们使用 requests 库来发送 HTTP 请求,并使用 BeautifulSoup4 库对返回结果进行解析。其中,“img”标签代表页面中所有图片元素,在 for 循环中遍历每个元素并输出其“src”属性,即可得到该页面中所有图片的链接地址。

四、下载图片

有了图片链接地址后,我们就可以利用 PHP 对这些链接进行遍历并下载对应的图片了。以下是一个简单的 PHP 程序示例:

9328af9636bb3add707425d0a89494f5$url ="https://www.example.com";

$html = file_get_contents($url);

preg_match_all('/<img.+src=[\'"]([^\'"]+)[\'"].*>/i',$html,$matches);

$images = array_unique($matches[1]);

foreach ($images as $image){

$filename = basename($image);

file_put_contents($filename, file_get_contents($image));

}

在上述程序中,我们使用 file_get_contents()函数获取指定2e9b5865537db47267991419e97f0ae9的 HTML 内容,并使用正则表达式匹配其中所有“img”标签。最终得到一个包含所有图片链接地址的数组$images,在281adde07ee431c41fea17ccb72110fd循环中遍历该数组并分别下载对应的图片。

五、处理异常情况

在实际操作中,可能会遇到一些异常情况,比如网络连接超时、目标网站限制爬虫等问题。此时我们需要对程序进行适当处理以防止程序崩溃或者被屏蔽。

例如,在 Python 中可以使用 try...except...语句捕获异常并输出错误信息:

python

try:

res = requests.get(url, timeout=10)

except Exception as e:

print(e)

而在 PHP 中,则可以使用 curl 函数设置超时时间和 User-Agent 以规避目标网站限制:

9328af9636bb3add707425d0a89494f5$ch = curl_init();

curl_setopt($ch, CURLOPT_URL,$url);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, true);

curl_setopt($ch, CURLOPT_TIMEOUT, 10);

curl_setopt($ch, CURLOPT_USERAGENT,"Mozilla/5.0(Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3");

$html = curl_exec($ch);

curl_close($ch);

六、多线程下载

如果要下载海量图片,则单线程下载速度可能会比较慢。因此,在实际操作中我们通常会采用多线程下载技术来提高效率。

Python 中可以使用 threading 模块创建多个线程,并通过 queue 模块实现队列管理:

python

import threading

import queue

import requests

class Downloader(threading.Thread):

def __init__(self, queue):

threading.Thread.__init__(self)

self.queue = queue

def run(self):

while True:

url = self.queue.get()

try:

res = requests.get(url)

#...

except Exception as e:349f4537d5dabe9dc81351e85e9d3eab(e)

self.queue.task_done()

q = queue.Queue()

for i in range(10):

t = Downloader(q)

t.setDaemon(True)

t.start()

for img in images:

q.put(img)

q.join()

而在 PHP 中,则可以使用 curl_multi_*函数实现并发请求:

9328af9636bb3add707425d0a89494f5$mh = curl_multi_init();

$chs = array();

foreach ($images as $i=>$image){

$chs[$i]= curl_init();

curl_setopt_array($chs[$i], array(

CURLOPT_URL =>$image,

CURLOPT_RETURNTRANSFER => true,

CURLOPT_TIMEOUT => 10,

CURLOPT_USERAGENT =>"Mozilla/5.0(Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3",

CURLOPT_FOLLOWLOCATION => true,

CURLOPT_MAXREDIRS =>5,

CURLOPT_AUTOREFERER => true,

CURLOPT_HEADER => false,

CURLOPT_SSL_VERIFYPEER => false,

CURLOPT_SSL_VERIFYHOST => false,

));

curl_multi_add_handle($mh,$chs[$i]);

}

do {

curl_multi_exec($mh,$running);

} while ($running >0);

foreach ($chs as $ch){

curl_multi_remove_handle($mh,$ch);

}

curl_multi_close($mh);

七、注意事项

在进行网络爬虫操作时,需要注意以下几点:

1.尊重他人知识产权和隐私权;

2.遵守相关法律法规和道德规范;

3.不过度频繁地访问目标网站;

4.防止被目标网站屏蔽或封禁 IP;

5.不要泄露自己的身份信息。

八、总结

通过本文的介绍与示例代码,相信读者已经初步了解了如何利用 PHP 和 Python 实现抓取网络上指定网址所包含全部图像文件并保存到本地计算机上。同时也学习了如何处理异常情况及多线程下载等技术手段。最后提醒读者注意相关法律法规及道德规范问题。

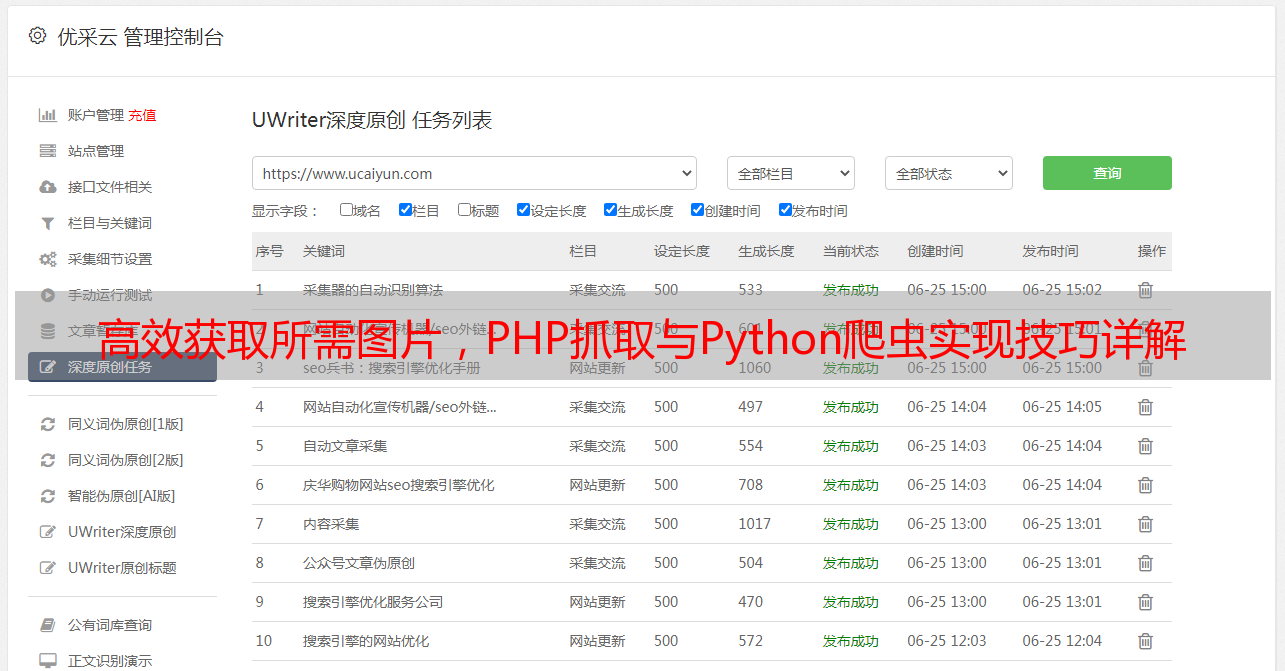

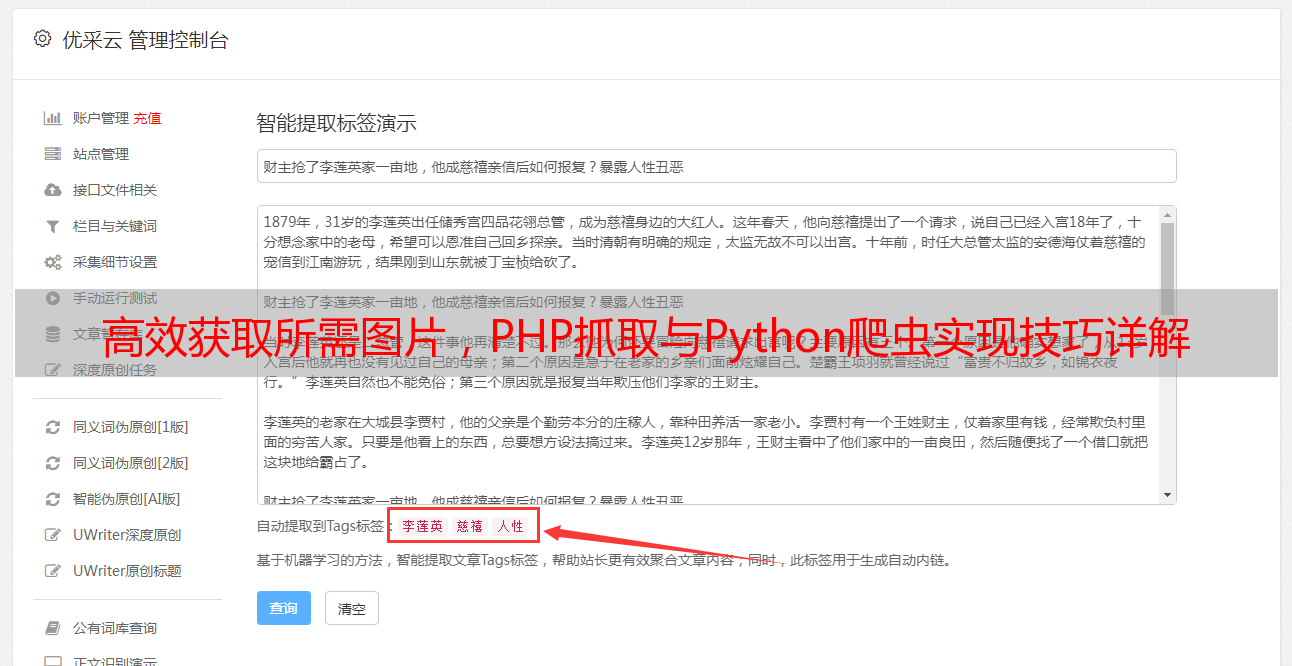

九、优采云推荐

如果您需要更加强大且易于操作的爬虫工具,请尝试优采云(www.ucaiyun.com)提供的数据采集服务。优采云拥有强大且易于操作的图形界面和智能识别引擎,并提供海量数据源和专业技术支持服务,帮助您轻松完成各类数据采集任务,并提升数据质量和效率。