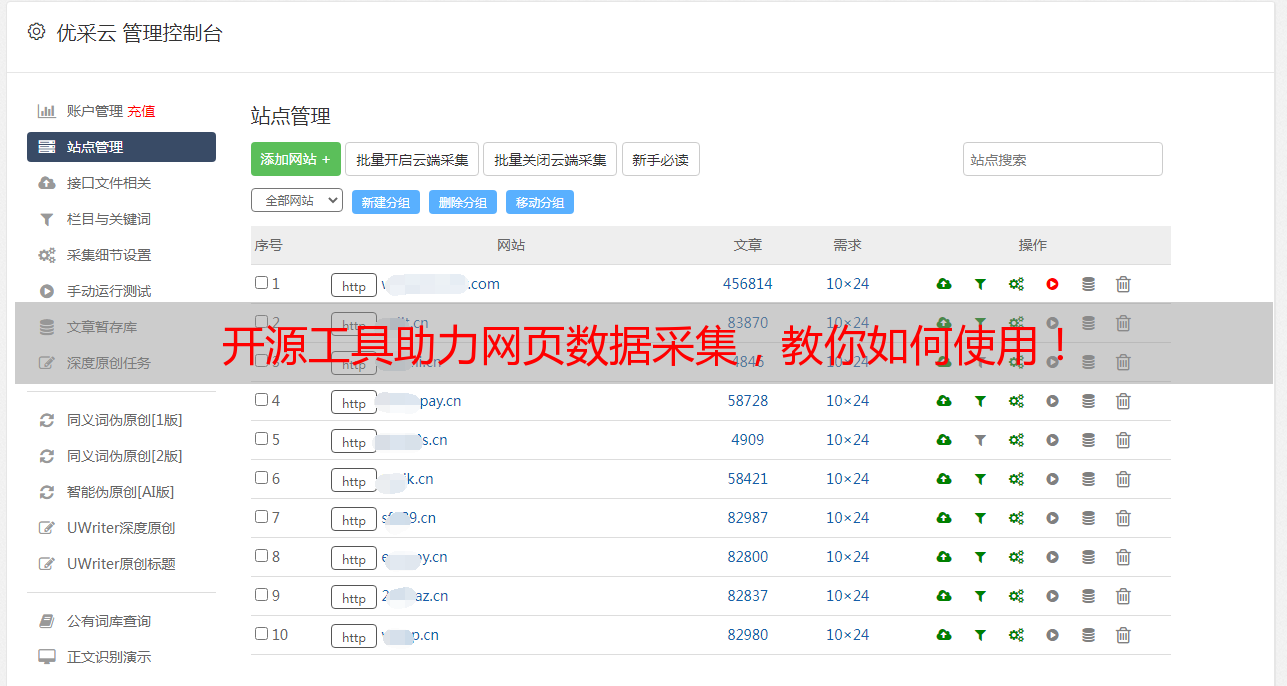

开源工具助力网页数据采集,教你如何使用!

优采云 发布时间: 2023-03-16 23:12如果你是一个数据工程师或者是一名数据分析师,你就会知道数据在当前的商业环境中有多么重要。然而,获取数据并不总是容易的事情。在许多情况下,你需要通过网络来获取数据。这就需要使用一些工具来实现网页数据采集。在这篇文章中,我们将介绍网页数据采集的开源工具以及如何使用它们。

1.什么是网页数据采集?

网页数据采集是指从互联网上提取和抓取有用信息的过程。这些信息可以是文本、图片、视频等等。这个过程通常需要使用一些自动化工具来完成。

2.开源网页数据采集工具有哪些?

目前市面上有很多开源的网页数据采集工具,其中比较流行的包括Scrapy、Beautiful Soup、Selenium等等。这些工具各有优缺点,可以根据实际需求选择使用。

3. Scrapy是什么?

Scrapy是一个基于Python的开源网络爬虫框架。它可以帮助我们快速、高效地从互联网上提取所需信息,并将其存储到数据库或文件中。

4. Beautiful Soup是什么?

Beautiful Soup也是一个Python库,它可以帮助我们解析HTML和XML文档,并提供了简单而实用的API来导航文档树。

5. Selenium是什么?

Selenium是一个自动化测试框架,但它也可以用于网络爬虫。它可以模拟用户在浏览器中的操作,包括点击、输入、滚动等等。

6.如何选择适合自己的工具?

选择适合自己的工具需要考虑多个因素,包括但不限于所需信息类型、目标网站结构、代码复杂度等等。在选择之前需要进行充分的调研和测试。

7.网页数据采集存在哪些问题?

网页数据采集可能会遇到反爬虫机制、IP封锁、页面结构变化等问题。针对这些问题需要使用一些技巧和策略来应对。

8.如何进行优化?

进行优化可以提高采集效率和准确性。常见优化策略包括使用代理IP、设置延迟时间、避免重复请求等等。

总之,网页数据采集是一个复杂而又重要的过程。通过使用适当的开源工具和优化策略,我们可以更加高效地完成这项任务。如果你想了解更多关于网页数据采集相关内容,请访问优采云(www.ucaiyun.com)获取更多资料和支持。