Python实现自动抓取网页,轻松掌握“while”循环

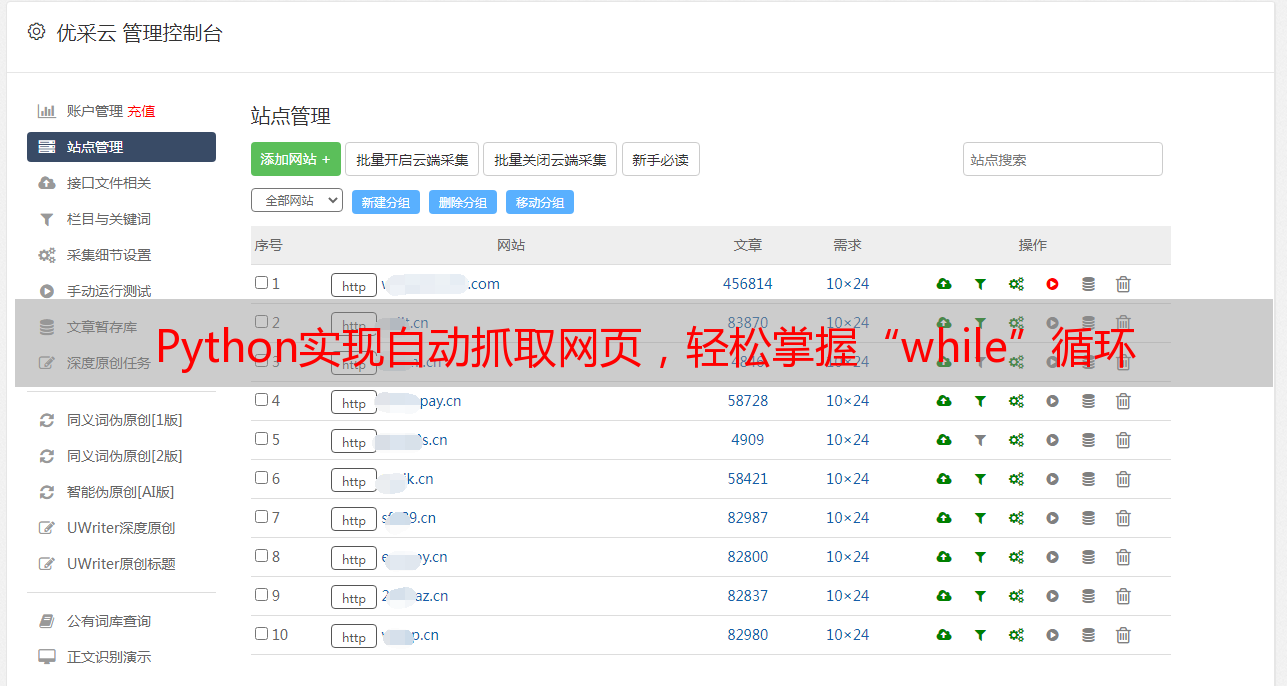

优采云 发布时间: 2023-03-16 17:18抓取网页是一项非常重要的技能,无论是做数据分析、做SEO优化,还是做自媒体内容创作,都需要掌握这项技能。而在过去,我们可能只能通过手动复制粘贴的方式来进行网页抓取,这种方式不仅效率低下,而且容易出错。而现在,我们可以利用Python等编程语言来实现自动化的网页抓取。本文将从以下几个方面来讲解如何使用Python进行网页抓取:

1.为什么要使用Python进行网页抓取?

2. Python中常用的网页抓取库有哪些?

3.如何使用Python进行基本的网页抓取?

4.如何使用Python进行高级的网页抓取?

5.如何处理网页中的动态内容?

6.如何处理反爬机制?

7.如何优化网页抓取效率?

8.如何应对*敏*感*词*数据的存储和处理?

9.网页抓取常见问题及解决方法

10.网页抓取实战案例

为了更好地阐述上述内容,我们将以一个典型的电商网站为例子,来演示如何使用Python进行网页抓取。在本文中,我们将使用Python 3.x版本,并且使用requests、beautifulsoup4、selenium、pandas等库。

1.为什么要使用Python进行网页抓取?

随着互联网技术的不断发展和普及,越来越多的信息被放到了网络上。而这些信息往往是以HTML、XML等格式呈现出来的。因此,如果我们想要从网络上获取某些信息,就需要对这些HTML、XML等格式的文档进行解析和提取。

传统的解析和提取方法往往需要手动编写正则表达式或XPath语句等复杂代码。而Python等编程语言提供了丰富的第三方库,使得我们可以通过简单的代码就能够轻松地完成对HTML、XML等格式文档的解析和提取。

2. Python中常用的网页抓取库有哪些?

在Python中,常用于网页抓取的库主要有requests、beautifulsoup4、selenium等。

- requests:一个HTTP库,可以发送HTTP请求并获取响应。

- beautifulsoup4:一个用于解析HTML和XML文档的第三方库。

- selenium:一个自动化测试工具,在实现模拟浏览器行为方面非常强大。

除此之外,还有一些其他辅助性质量更高或者功能更强大的库可供选择。

3.如何使用Python进行基本的网页抓取?

在介绍如何使用Python进行基本的网页抓取之前,先给出一个简单示例:

python

import requests

url ='https://www.jd.com'

response = requests.get(url)

print(response.status_code)

上述代码演示了如何使用requests库获取JD首页,并输出HTTP响应码。其中requests.get()方法用于发送HTTP GET请求,并返回一个Response对象。Response对象包含了HTTP响应码、HTTP响应头、HTTP响应正文等信息。

当然,在实际应用中,我们通常需要对HTTP响应进行进一步处理(例如解析HTML文档)。下面给出一个完整示例:

python

import requests

from bs4 import BeautifulSoup

url ='https://www.jd.com'

response = requests.get(url)

soup = BeautifulSoup(response.text,'html.parser')

print(98a5f537c46e6a2bcd1066ec72b9a612.title.string)

上述代码演示了如何获取JD首页,并输出该页面标题文字。其中BeautifulSoup类用于解析HTML文档,并提供了一系列API来查找和操作HTML元素。

4.如何使用Python进行高级的网页抓取?

在某些情况下(例如需要登录才能访问某些页面),基本的网页抓取已经无法满足需求。这时候就需要使用一些高级技术来实现自动化登录、模拟浏览器行为等操作。

针对这种情况,selenium是一个非常好用且功能强大的工具。它可以模拟真实浏览器行为,并支持多种浏览器(例如Chrome、Firefox等)。

以下代码演示了如何利用selenium模拟登录并获取页面内容:

python

from selenium import webdriver

browser = webdriver.Chrome()

browser.get('https://www.taobao.com')

login_button = browser.find_element_by_link_text('亲,请登录')

login_button.click()

username_input = browser.find_element_by_id('fm-login-id')

password_input = browser.find_element_by_id('fm-login-password')

submit_button = browser.find_element_by_class_name('fm-button')

username_input.send_keys('your username')

password_input.send_keys('your password')

submit_button.click()

print(browser.71860c77c6745379b0d44304d66b6a13_source)

上述代码演示了如何利用selenium模拟登录淘宝,并打印出登录后页面源码。

5.如何处理网页中的动态内容?

有时候我们会发现,在一些页面中存在着动态加载或异步加载内容(例如通过AJAX技术实现),这时候我们需要采用一些特殊方式来获取这部分内容。

以淘宝搜索结果页面为例子,在页面底部有一个“下一页”按钮。当用户点击该按钮后,新一页商品信息将会异步加载到当前页面中。如果我们直接按照基本方法获取该页面源码,则只会得到已经加载出来的部分内容(即第一页商品信息)。

针对这种情况,我们可以采用selenium模拟用户点击“下一页”按钮,并反复执行该操作来获取所有商品信息:

python

from selenium import webdriver

browser = webdriver.Chrome()

browser.get('https://s.taobao.com/search?q=python&imgfile=&js=1&446501053769c06c565094b26d26e8ef_click=search_radio_all%3A1&initiative_id=staobaoz_20230316&ie=utf8')

for i in range(3):

goods_list = browser.find_elements_by_class_name('item-box')

for goods in goods_list:

print(goods.text)

next_71860c77c6745379b0d44304d66b6a13_button = browser.find_element_by_class_name('J_Ajax.num.i-next')

next_71860c77c6745379b0d44304d66b6a13_button.click()

上述代码演示了如何利用selenium模拟用户点击淘宝搜索结果页面底部“下一页”按钮,并输出所有商品信息。

6.如何处理反爬机制?

随着各大互联网公司对数据保密性要求越来越高,反爬机制也变得越来越严格。因此,在进行*敏*感*词*数据爬虫时必须注意防范反爬机制。

针对反爬机制最常见方式是设置User-Agent头部字段:

python

import requests

url ='https://www.zhihu.com/question/22918070'

headers ={

'User-Agent':'Mozilla/5.0(Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.36'}

response = requests.get(url, headers=headers)

print(response.text)

上述代码演示了如何设置User-Agent头部字段以避免被反爬机制识别为机器人请求。

7.如何优化网页抓取效率?

在进行*敏*感*词*数据爬虫时必须注意优化程序性能以提高效率。以下是一些优化建议:

-使用多线程或协程:可以同时发送多个HTTP请求以提高效率。

-缩短请求间隔:根据目标站点反应速度合理设置请求间隔时间。

-避免重复请求:缓存已经获取过数据或者避免频繁重复访问同一URL。

-压缩传输数据:可以减少网络带宽消耗和程序运行时间。

-使用CDN加速:可以减少网络延迟时间和传输时间。

-其他细节优化:例如设置超时时间、关闭DNS预读等操作都可以稍微提高程序效率。

8.如何应对*敏*感*词*数据的存储和处理?

当我们获得大量数据之后,就需要考虑如何存储和处理这些数据。以下是一些存储和处理建议:

-数据库存储:可以采用关系型数据库或者NoSQL数据库存储数据。

-文件存储:可以采用JSON、CSV、Excel等格式文件存储数据。

-内存数据库:适合于快速读写小型数据集合。

-分布式计算框架:例如Hadoop生态系统、Spark生态系统等可支持海量数据分布式计算和分布式存储。

-数据清洗与预处理:包括缺失值填充、离群值检测与修正、异常值删除与平滑化等操作。

-数据可视化与报告生成:包括Matplotlib、Plotly、Tableau等工具生成图表并输出报告。

9.网页抓取常见问题及解决方法

在进行网页抓取时可能会遇到以下问题:

- IP被封锁导致无法正常访问目标站点;

-目标站点增加验证码或其他人机验证;

-目标站点修改HTML结构导致原有程序失效;

-目标站点限制爬虫并封禁相关IP地址;

-网络波动导致程序异常退出;

针对以上问题可能存在以下解决方法:

-使用代理IP隐藏真实IP地址;

-自动识别验证码并输入正确答案;

-使用强壮性更好且易于维护修改结构;

-合理设计程序运行策略以避免被封禁;

-设计容错机制以保证程序稳定运行;

10.网页抓取实战案例

以下是一个简单但功能完备且易于调整适配各种场景需求案例:

```python

import requests

from bs4 import BeautifulSoup

import time

def get_html(url, headers=None, params=None, proxies=None, timeout=30):

while True:

try:

response = requests.get(url, headers=headers, params=params, proxies=proxies, timeout=timeout)

if response.status_code == 200:

html_content = response.content.decode('utf8', errors='ignore')

return html_content

elif response.status_code == 404:

return None

else:

raise Exception(f'Request Failed:{response.status_code}')

except Exception as e:

print(e)

def parse_html(html_content):

soup = BeautifulSoup(html_content,'html.parser')

results =[]

for item in soup.select('.item'):

result ={}

result['title']= item.select_one('.title').text.strip()

result['author']= item.select_one('.author').text.strip()

result['date']= item.select_one('.date').text.strip()

results.append(result)

return results

def save_to_file(filename, data):

with open(filename,'w', encoding='utf8') as f:

for item in data:

f.write(f"{item['title']}\t{item['author']}\t{item['date']}\n")

def main(71860c77c6745379b0d44304d66b6a13_count):

url_pattern ='https://www.example.com/71860c77c6745379b0d44304d66b6a13=%d'

headers ={

'User-Agent':'Mozilla/5.0(Windows NT 10.