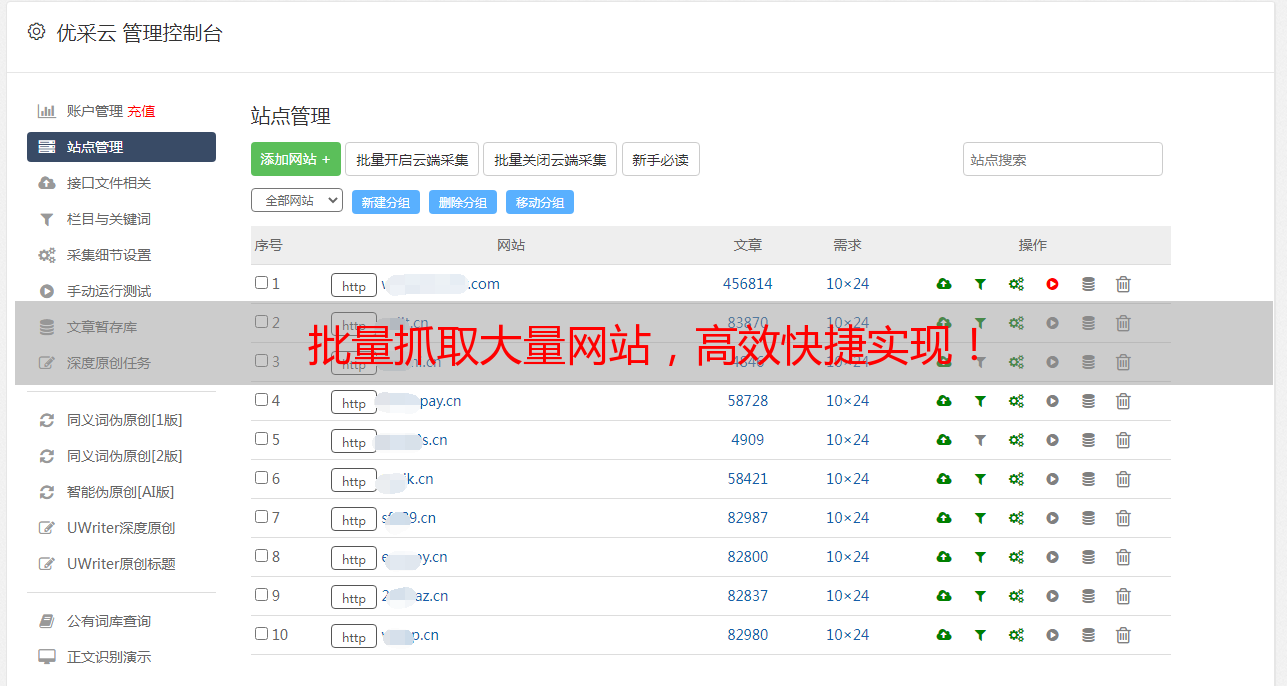

批量抓取大量网站,高效快捷实现!

优采云 发布时间: 2023-03-15 22:13在当今互联网时代,数据已经成为了一种非常重要的资源。而如何获取这些数据,就需要用到抓取技术。如果只是针对少量的网站进行抓取,手动操作还是可以满足需求的。但如果需要批量抓取大量的网站,那么手动操作显然就不再适用了。那么,如何才能做到高效快捷地批量抓取大量网站呢?下面我们就来一一探讨。

一、确定需要抓取的网站

在开始抓取之前,首先需要确定需要抓取的网站。这个过程中,需要考虑以下几个因素:

1.抓取内容:需要明确需要获取哪些类型的数据(比如文章、图片等)。

2.目标网站:需要确定需要抓取哪些网站。这里需要注意的是,不同类型的网站可能会有不同的反爬机制,因此在选择目标网站时需要仔细考虑。

3.抓取频率:需要确定每个目标网站的抓取频率。过于频繁的抓取可能会对目标网站造成负担,甚至导致被封禁 IP 的风险。

二、确定抓取方式

在确定好需要抓取的目标之后,就需要选择合适的抓取方式。常见的抓取方式包括:

1.爬虫框架:使用 Python 等编程语言编写爬虫程序,通过各种库和框架实现自动化抓取。

2.第三方工具:使用第三方工具进行批量抓取(比如 Octoparse、WebHarvy 等)。

3.云服务:使用云服务进行批量抓取(比如优采云)。

不同的方式各有优劣,选择哪种方式应该根据具体情况来决定。

三、设置反爬策略

在进行批量抓取时,很容易触发目标网站的反爬机制。为了避免这种情况发生,我们可以采用以下几种策略:

1.设置 User-Agent:在请求头中设置 User-Agent 字段,并将其设置成浏览器或其他合法程序的 User-Agent。

2.设置代理 IP:使用代理 IP 进行请求,以避免被封禁 IP。

3.限制请求频率:在请求之间添加适当时间间隔,并根据目标网站反应速度来调整时间间隔。

四、处理异常情况

在进行批量抓取时,经常会遇到各种异常情况。为了保证程序正常运行并尽可能地获取数据,我们应该采用以下策略:

1.处理超时异常:设置超时时间,并对超时异常进行处理。

2.处理网络异常:对网络异常进行处理,并重新发起请求。

3.处理验证码:当目标网站出现验证码时,可以手动输入或使用第三方打码平台进行处理。

五、数据存储与分析

在完成数据获取之后,还需要将数据存储起来并进行分析处理。常见的存储方式包括文件存储和数据库存储;常见的分析方法包括文本挖掘、机器学习等。在选择存储和分析方法时,应该根据实际需求和数据规模来选择合适的方法。

六、SEO 优化

如果你是一位博主或者*敏*感*词*,在进行批量抓取之后要注意 SEO 优化。SEO 搜索引擎优化是指通过优化页面结构、关键词等手段提高页面排名以获得更多流量并提高转化率。如果想要获得更好的效果,在进行 SEO 优化时应该注重以下几点:

1.关键词选择:选用合适关键词,并将其合理地分布在页面中;

2.标题与描述优化:精心设计标题和描述,并让其与页面内容相符;

3.内容质量:提供原创且有价值的内容;

4.外链建设:建立外部链接以提高页面权重;

5.移动端适配:确保页面能够良好地适配移动端设备。

七、安全问题

在进行批量抓取时还需注意安全问题。如果你从别人手里购买了一个爬虫程序或者直接从网络上下载了一个爬虫程序,在使用之前一定要先检查它是否含有木马或者病毒等恶意代码。此外,在访问目标网站时也要注意不要触犯相关法律法规或者侵犯他人权益等问题。

八、结语

通过以上八个方面对批量抓取大量网站进行了详细探讨和分析,希望能够帮助读者更好地了解该领域相关知识,并能够顺利地完成自己所需的任务。最后再次提醒读者,在进行相关操作时务必遵守相关法律法规和道德准则,并严格按照实际需求来选择相应方案和工具。同时为读者推荐一个可靠且安全性高、功能强大且易于使用的云服务——优采云(www.ucaiyun.com),希望能够为读者带来便利与帮助!