高效批量抓取大量网站,八种应用场景全解析

优采云 发布时间: 2023-03-14 12:14在当今信息爆炸的时代,数据已成为企业决策的重要基础。然而,如何获取海量数据是摆在许多企业面前的难题。批量抓取大量网站成为了解决这一难题的有效手段。本文将从以下八个方面对批量抓取大量网站进行深入分析。

一、什么是批量抓取大量网站?

二、批量抓取大量网站的优势

三、批量抓取大量网站的应用场景

四、批量抓取大量网站的技术原理

五、批量抓取大量网站的实现方法

六、如何保证数据质量?

七、批量抓取大量网站需要注意什么?

八、结语:优采云为您提供高效便捷的数据采集服务

一、什么是批量抓取大量网站?

批量抓取大量网站,顾名思义就是通过程序自动化地获取多个网站上的信息。在这个过程中,需要使用到网络爬虫技术和数据采集技术。通过这些技术手段,可以高效地采集海量数据,并将其整理成可供分析和利用的格式。

二、批量抓取大量网站的优势

相较于传统手工采集方法,批量抓取大量网站具有以下优势:

1.效率高:自动化执行任务,节省人力成本;

2.速度快:同时采集多个网站,减少等待时间;

3.精度高:避免人为误差,提高数据质量;

4.规模大:可以处理海量数据;

5.实时性强:可以随时更新最新数据。

三、批量抓取大量网站的应用场景

批量抓取大量网站可以应用于各种领域,例如:

1.电商行业:分析竞争对手价格策略、商品销售情况等;

2.金融行业:监测股票走势、汇率变化等;

3.医疗行业:分析疾病流行趋势等;

4.政府部门:监测环境污染情况等。

四、批量抓取大量网站的技术原理

1.网络爬虫技术

网络爬虫是指自动访问互联网上各种信息资源的程序。它通过模拟用户行为进行信息收集,并将信息整合成结构化数据。

2.数据采集技术

数据采集是指从各种来源收集并整合数据,并对其进行清洗和处理。在批量抓取大量网站中,需要使用到数据采集技术来处理所获得的海量数据。

五、批量抓取大量网站的实现方法

1.Python编程语言

Python是一种简单易学且功能强大的编程语言。它支持多线程和协程,并且有着丰富的第三方库支持,在网络爬虫领域有着广泛应用。

2.Scrapy框架

Scrapy是一个开源网络爬虫框架,它具有高效稳定、易于维护等特点,并且支持分布式部署。

3.Selenium自动化测试工具

Selenium是一个自动化测试工具,它可以模拟用户行为并进行自动化操作。在网络爬虫中,可以使用Selenium来模拟用户登录等操作。

六、如何保证数据质量?

1.设置合适的爬虫间隔时间,避免对服务器造成负载压力;

2.针对不同类型页面设置不同规则,避免因页面格式变化导致无法正常采集;

3.设置反爬虫策略,避免被目标网站封锁IP地址。

4.使用代理IP池来降低被封锁IP地址概率。

5.加入验证码识别功能来解决验证码问题。

7、遵循robots.txt协议避免被目标服务器拉黑。

8、定期检查代码并进行升级维护。

七、批量抓取大量网站需要注意什么?

1.遵循法律法规,在合法范围内采集信息;

2.注意隐私保护,在不侵犯他人权益前提下获取信息;

3.注意目标服务器反爬虫策略,并根据反爬虫策略进行调整;

4.注意代码安全性,在代码中加入防止SQL注入等安全措施。

5.注意目标服务器响应速度和带宽限制,避免造成目标服务器崩溃或者拒绝服务攻击。

6.注意用户体验,保证程序运行时不会影响到其他正在使用计算机资源,如CPU占用过高等问题.

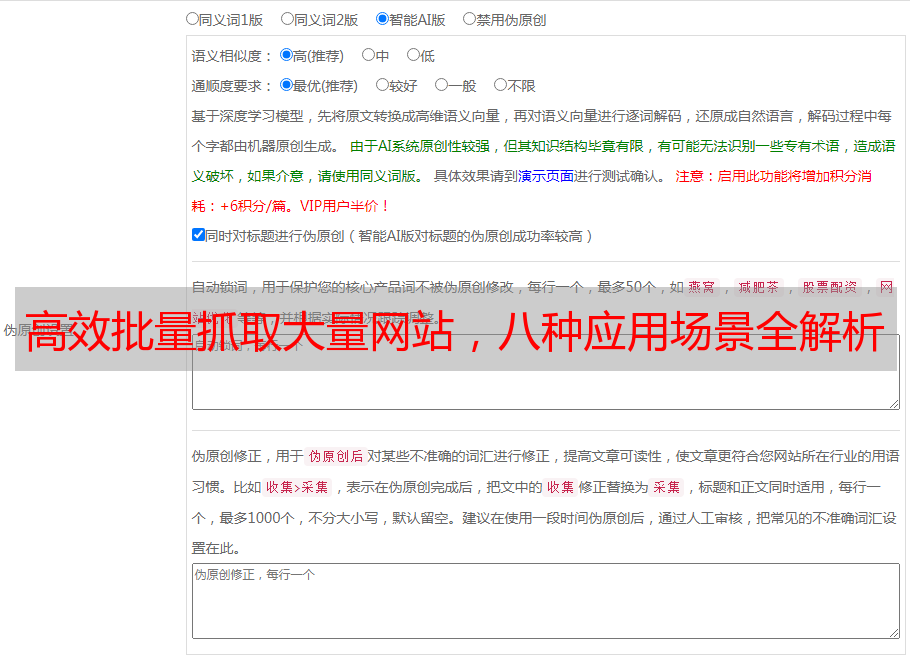

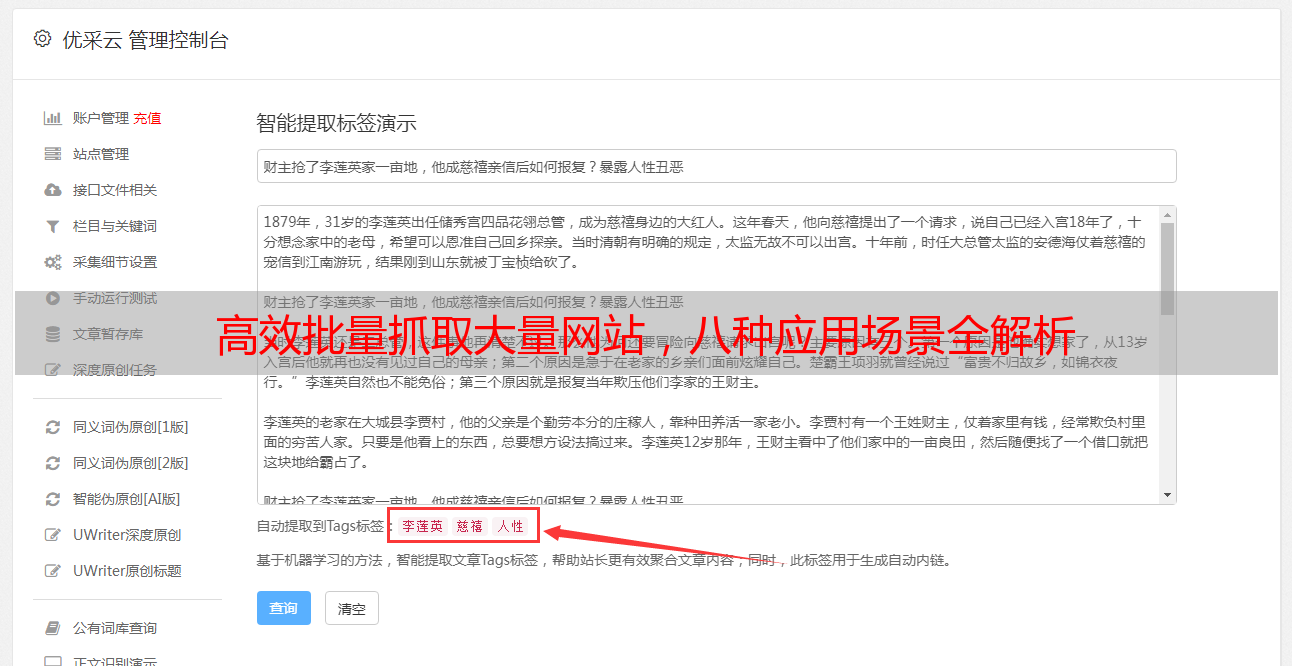

八、结语:优采云为您提供高效便捷的数据采集服务

作为国内领先的云端智能数据采集平台之一,优采云致力于为企业提供全面优质的数据采集服务。我们拥有先进稳定的技术平台和专业资深团队,在海外市场也积累了丰富经验。我们通过灵活多样化方案帮助客户完成各类复杂需求,并提供全方位支持与服务。欢迎访问www.ucaiyun.com了解更多详情!