Python爬虫插件crawling下载,助力数据采集!

优采云 发布时间: 2023-03-14 12:14作为一名互联网从业者,我们都知道爬虫在数据采集和信息分析中的重要性。而爬虫工具的选择,更是直接关系到工作效率和数据质量。今天,我要为大家介绍一款最新的采集插件——crawling,它不仅功能强大,而且操作简单易用,让你轻松完成各种数据采集任务。

一、crawling概述

crawling是一款基于Python语言开发的爬虫框架,它兼容多个操作系统,并且支持多线程、分布式等高级特性。它可以快速、高效地抓取各种网站上的数据,并提供了强大的数据处理和存储能力。同时,crawling还拥有友好的用户界面和完善的文档支持,让初学者也能轻松上手。

二、crawling安装

下载crawling非常简单,只需在命令行中输入以下代码即可:

pip install crawling

如果需要更新已安装的版本,则输入以下代码:

pip install --upgrade crawling

三、使用crawling进行数据采集

使用crawling进行数据采集非常简单,只需要按照以下步骤即可:

1.导入所需模块

from crawling import requests, Selector, Crawler

2.设置请求参数

url ='https://www.ucaiyun.com'

headers ={

'User-Agent':'Mozilla/5.0(Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'}

3.发送请求并解析响应内容

resp = requests.get(url, headers=headers)

selector = Selector(resp.text)

title = selector.css('title::text').extract_first()

4.存储结果数据

result ={'url': url,'title': title}

print(result)

以上代码演示了如何使用crawling获取一个网页的标题,并将结果打印出来。实际使用中,我们可以根据需要设置更多请求参数和解析规则,并将结果存储到数据库或文件中。

四、crawling常用功能介绍

除了基本的数据采集功能外,crawling还提供了很多高级特性和扩展功能。下面我将逐一介绍其中几个常用功能。

1.分布式抓取

如果需要抓取大量数据或频繁更新的网站,单机爬虫可能会遇到性能瓶颈。这时候可以使用分布式爬虫来提高效率。crawling内置了支持分布式抓取的模块,并且可以方便地与其他分布式框架(如Scrapy)配合使用。

2.自动反爬虫处理

为了防止被反爬虫机制封禁IP或账号,我们需要对爬虫进行一些反侦测措施。crawling提供了自动识别和处理反爬虫机制的功能,并且可以自定义一些策略来应对不同类型的反爬虫措施。

3.数据清洗和预处理

在实际应用中,我们经常需要对抓取到的数据进行清洗、去重、归一化等处理。crawling提供了多种数据预处理工具和函数库,方便用户进行复杂数据转换和计算。

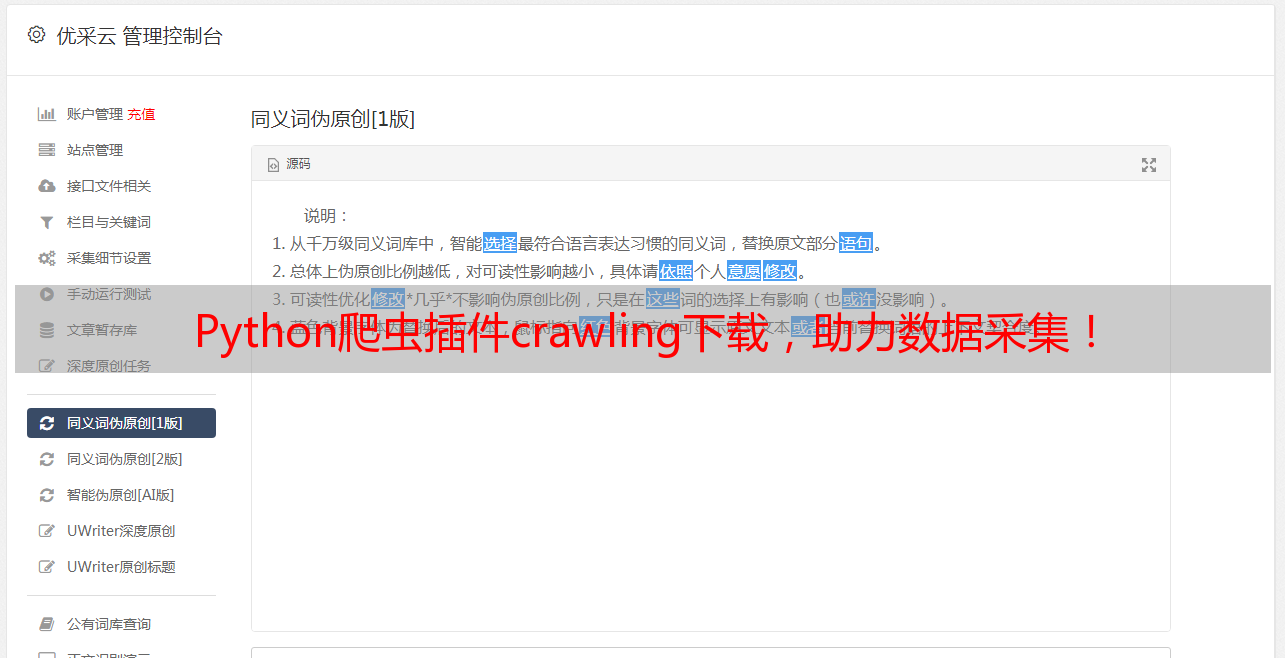

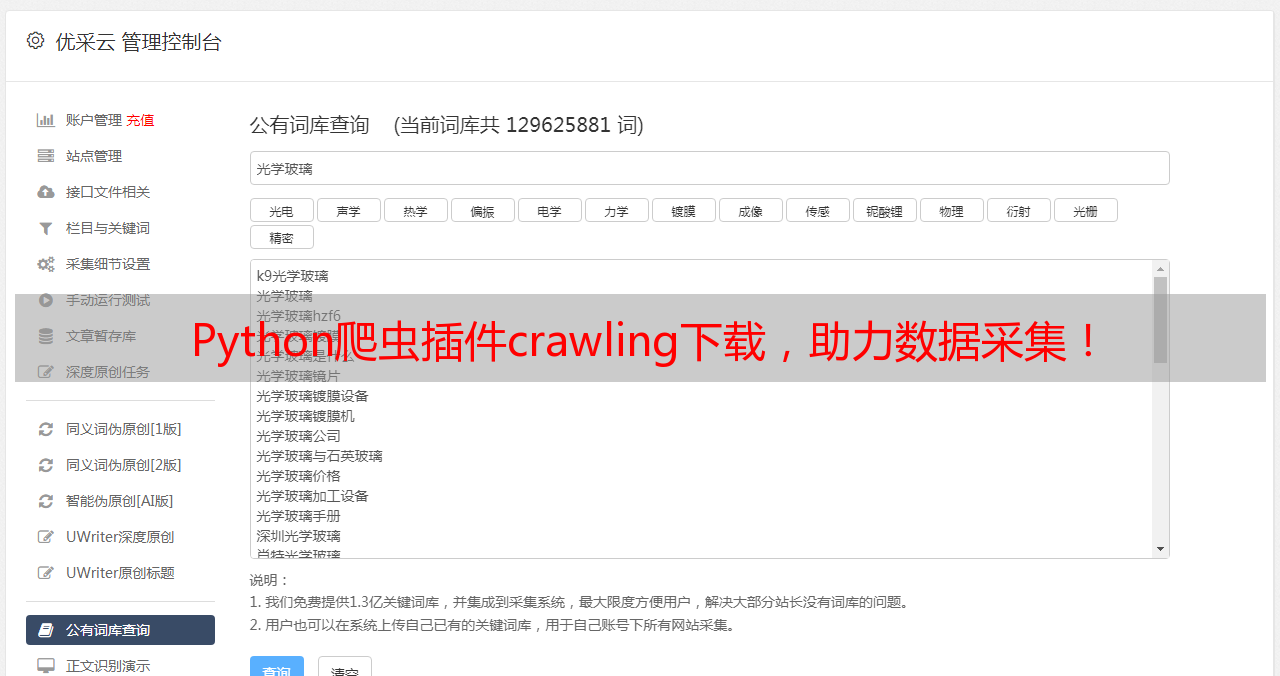

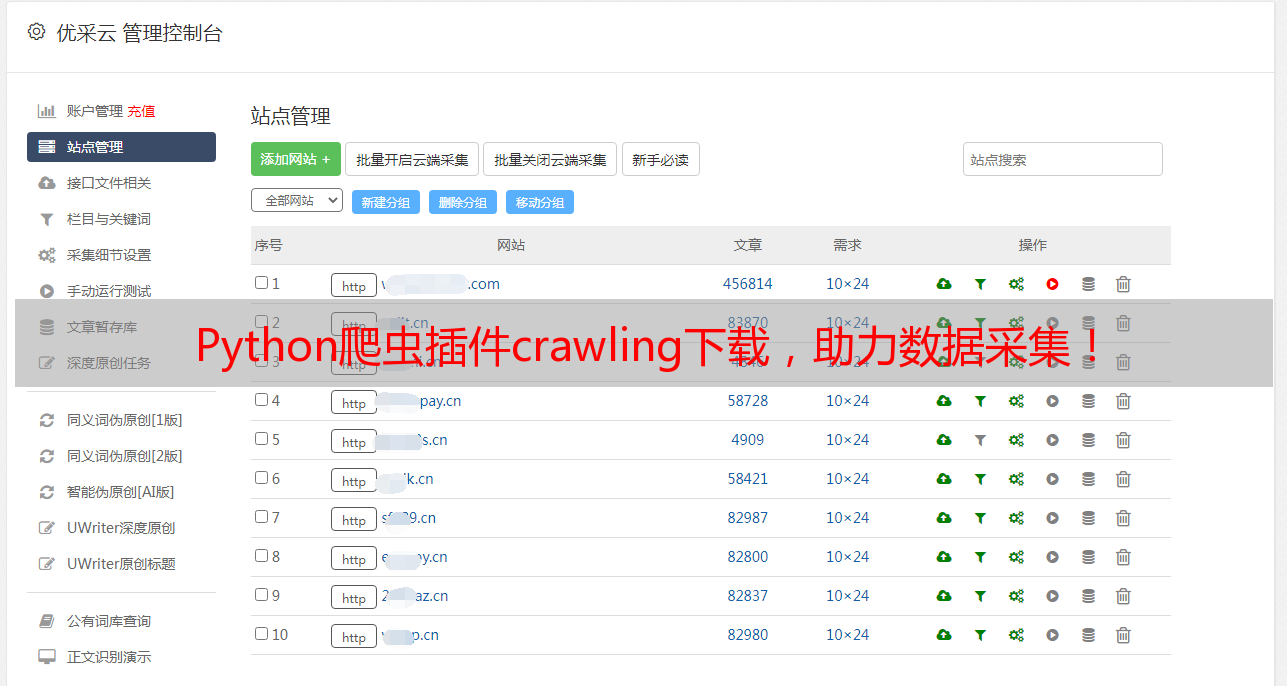

五、优采云平台上使用crawling

如果你觉得以上介绍还不够详细或者想进一步学习如何使用crawling进行高效数据采集和分析,请登录优采云平台(www.ucaiyun.com)查看相关教程和案例。在优采云上,你可以享受到更稳定、更快速、更安全的服务,并且可以充分利用平台提供的SEO优化技巧来提升你网站的流量和排名。

六、结语

总之,crawling是一款非常强大、灵活且易用性极高的爬虫框架,在各类*敏*感*词*数据采集任务中都有着广泛应用。如果你想要成为一名专业的网络数据分析师或SEO优化师,请务必掌握这个神器!