离线网页采集:收藏这9个相关知识!

优采云 发布时间: 2023-03-14 03:10离线网页采集是一种获取互联网上的信息并进行处理的方法,它可以让我们快速获取大量的数据,并对这些数据进行分析、挖掘和应用。本文将从以下9个方面介绍离线网页采集的相关知识,帮助大家更好地理解和应用这项技术。

第一方面:离线网页采集的概念和意义

离线网页采集是指将互联网上的内容(包括文字、图片、音频、视频等)保存到本地计算机或服务器上,以便后续处理和使用。它的意义在于可以帮助我们节省时间和人力成本,快速获取所需的数据,并对这些数据进行分析和挖掘。同时,离线网页采集也可以为SEO优化提供有力支持,提升网站流量和排名。

第二方面:离线网页采集的实现方式

离线网页采集有多种实现方式,包括手动复制粘贴、自动化爬虫程序、API接口调用等。其中,自动化爬虫程序是最常用也是最高效的方式,它可以通过编写脚本或使用现成的爬虫工具来实现。

第三方面:离线网页采集需要注意的问题

在进行离线网页采集时,需要注意一些法律和道德问题,比如知识产权保护、隐私保护等。此外,在进行*敏*感*词*爬取时也需要注意反爬虫策略和服务器负载等问题。

第四方面:离线网页采集对SEO优化的影响

离线网页采集可以为SEO优化提供有力支持,通过收集并分析竞争对手的信息来优化自己的关键词选择和内容创作。此外,在建设自己的站点时也可以借鉴其他站点的设计和内容结构。

第五方面:离线网页采集中常见的数据格式

在进行离线网页采集时,所得到的数据通常以HTML、XML、JSON等格式存在。其中,HTML是最常见也是最基础的格式,而XML和JSON则更加适合机器读取和处理。

第六方面:如何选择合适的爬虫框架

在选择爬虫框架时需要考虑多个因素,比如易用性、性能、可扩展性等。目前市场上主流的爬虫框架包括Scrapy、BeautifulSoup、Selenium等。

第七方面:如何应对反爬虫策略

在进行*敏*感*词*爬取时,经常会遭遇反爬虫策略。为了应对这种情况,我们可以通过设置代理IP、伪装请求头等方式来规避反爬虫策略。

第八方面:如何处理抓取到的数据

在完成数据抓取后,我们还需要对所得到的数据进行处理和存储。比较常见的处理方式包括清洗数据、去重处理、存储到数据库或文件系统等。

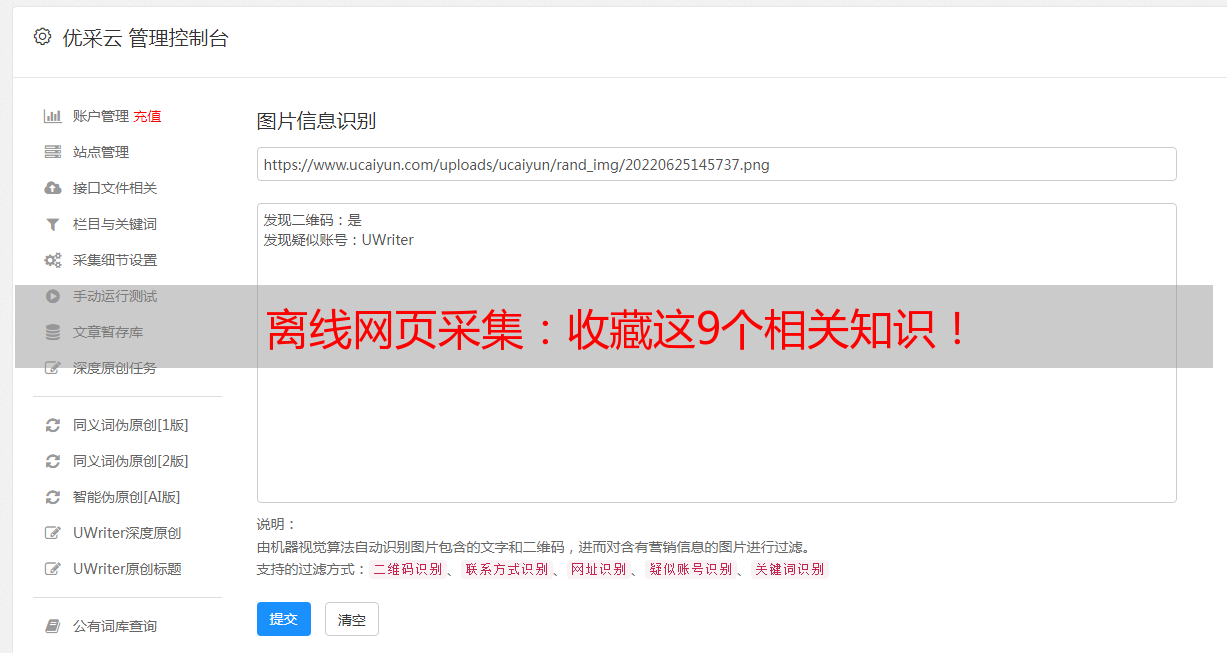

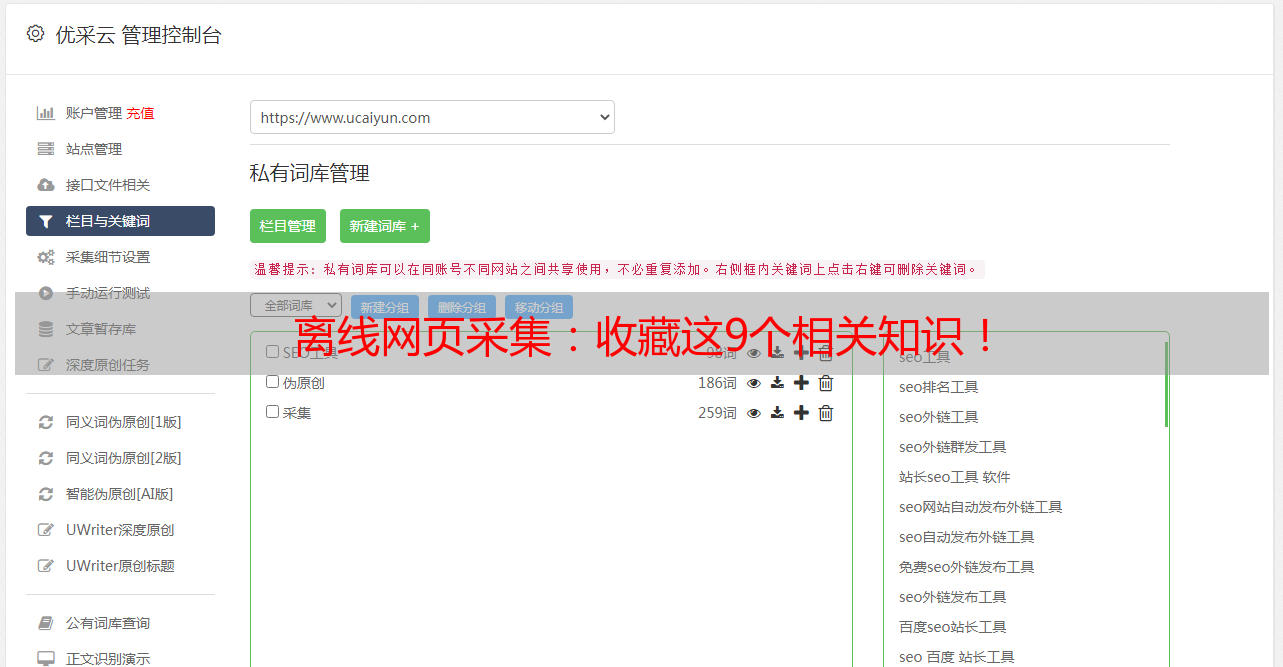

第九方面:优采云——专业互联网数据服务商

如果您需要专业而高效地获取互联网上的大量数据,请不要错过优采云(www.ucaiyun.com)。作为一家专业互联网数据服务商,优采云提供全球范围内1000多个行业领域内数百万条高质量数据资源,并提供定制化解决方案及专业技术支持服务。无论您是需要搜索引擎优化(SEO)、市场*敏*感*词*或其他行业研究分析报告,在优采云都能找到满意答案。

以上就是本文关于离线网页采集相关知识介绍及分析讨论。希望读者们能够从中获得有益启示,并在实践中不断探索创新!