提高数据分析效率:9个技巧帮你采集网页表格

优采云 发布时间: 2023-03-13 18:14在数据分析领域,采集网页表格是非常重要的一环。通过采集网页表格,可以快速获取大量的数据,提高数据分析效率。本文将从以下9个方面介绍如何采集网页表格。

一、明确采集目标

在进行网页表格采集之前,首先需要明确采集目标。确定需要采集的数据类型、数据来源、数据量等。例如,如果需要采集某个电商平台上的商品信息,就需要确定需要采集哪些信息,如商品名称、价格、销量等。

二、选择合适的工具

选择合适的工具可以提高采集效率和成功率。常用的网页表格采集工具有Beautiful Soup、Scrapy等。其中Beautiful Soup是一款基于Python的HTML/XML解析库,可以方便地获取特定标签内的内容;而Scrapy则是一个Python爬虫框架,可以自动化地爬取网站信息。

三、了解网页结构

在进行网页表格采集之前,需要了解目标网站的结构和规律。通过查看网站源代码和开发者工具可以获得相关信息。例如,如果目标表格所在的页面URL是固定不变的,则可以直接访问该URL进行采集;如果目标表格所在的页面URL是动态生成的,则需要使用Selenium等工具模拟浏览器行为。

四、编写爬虫代码

根据采集目标和选定工具,编写相应的爬虫代码。以Beautiful Soup为例:

python

from bs4 import BeautifulSoup

import requests

url ='http://example.com'

r = requests.get(url)

soup = BeautifulSoup(r.text,'html.parser')

table = soup.find('table')

rows = table.find_all('tr')

for row in rows:

cols = row.find_all('td')

for col in cols:

print(col.text)

五、设置请求头

为了避免被反爬虫机制封锁IP地址,需要设置请求头。常见的请求头参数有User-Agent、Referer等。

python

headers ={

'User-Agent':'Mozilla/5.0(Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.36',

'Referer':'http://example.com'

}

六、处理异常情况

在进行网页表格采集时,可能会遭遇各种异常情况,如网络连接失败、请求超时等。为了避免因异常情况导致程序中断或崩溃,需要编写相应的异常处理代码。

python

import time

while True:

try:

#网络连接代码

break

except Exception as e:

print(e)

time.sleep(5)#休眠5秒后重试

七、存储数据

完成网页表格采集后,需要将获取到的数据进行存储。常见的存储方式有CSV文件、MySQL数据库等。以CSV文件为例:

python

import csv

with open('data.csv','w', newline='', encoding='utf-8') as f:

writer = csv.writer(f)

writer.writerow(['col1','col2','col3'])#表头

for row in rows:

cols =[col.text for col in row.find_all('td')]

writer.writerow(cols)

八、SEO优化

为了让搜索引擎更好地索引和收录网站内容,在编写爬虫代码时需要注意SEO优化技巧。例如,在URL中包含关键词、使用语义化HTML标签等。

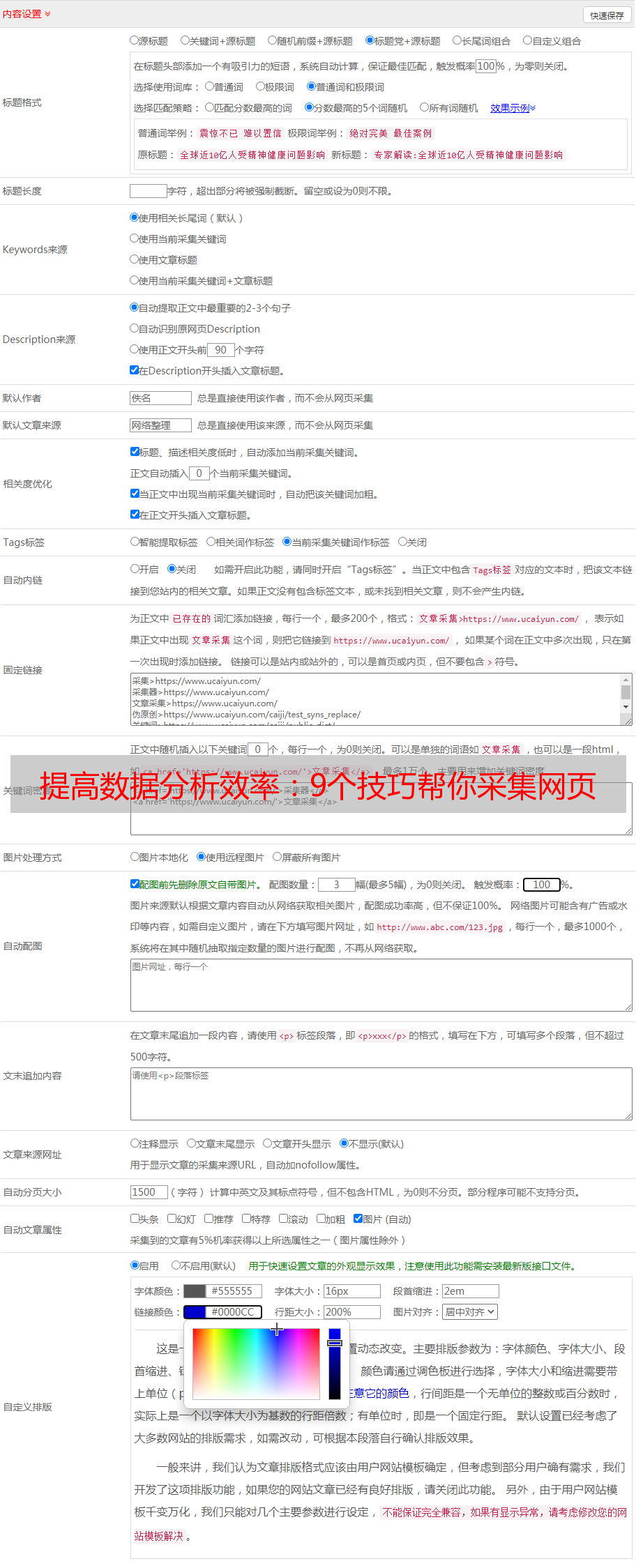

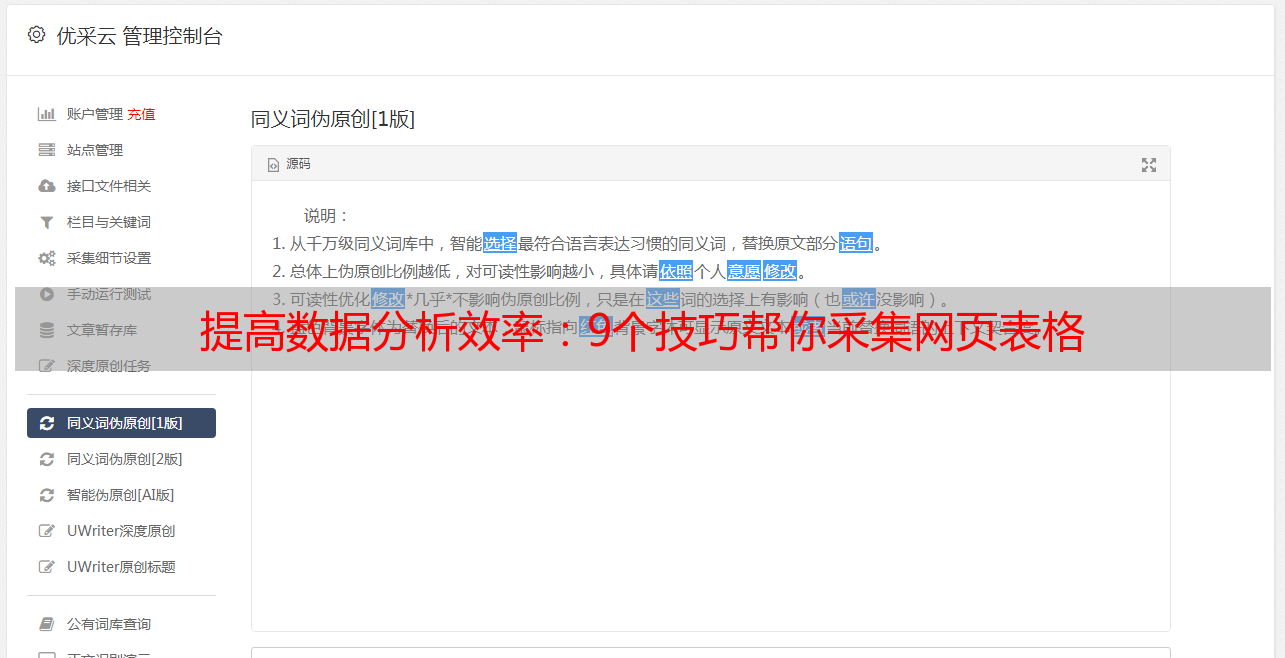

九、使用优采云提高效率

为了进一步提高数据分析效率,在进行网页表格采集时可以使用优采云这样的自动化工具。优采云可以自动识别并抓取目标页面上所有符合条件的表格,并将其转换成CSV文件或Excel文件供下载和分析。

总之,通过以上9个方面进行综合考虑和实践操作,就能够顺利实现对网页表格数据的快速高效地抓取与提取操作了!(本文由优采云www.ucaiyun.