Scrapy下载文章,快速高效实现信息爬取!

优采云 发布时间: 2023-03-13 11:21自媒体的发展,让很多人都成为了自媒体从业者。而且,随着互联网的飞速发展,人们对于获取资讯的需求也越来越大。那么,如何快速地爬取到所需要的文章呢?Scrapy 就是一个不错的选择。

1. Scrapy 是什么?

Scrapy 是一个基于 Python 的开源网络爬虫框架。它可用于抓取网站,并从中提取结构化数据。与其他爬虫框架相比,Scrapy 的优势在于它的高效性、灵活性和易扩展性。

2. Scrapy 的优点

使用 Scrapy 可以带来很多好处:

-高效性:Scrapy 可以异步处理请求和响应,从而提高爬取效率。

-灵活性:Scrapy 可以通过中间件来处理请求和响应,从而可以自定义处理流程。

-易扩展性:Scrapy 支持插件式开发,可以方便地添加新功能。

-支持多种数据格式:Scrapy 支持多种数据格式(如 XML 和 JSON),可以方便地进行数据处理和存储。

3. Scrapy 的基本组成

Scrapy 由以下几个组件组成:

-引擎(Engine):负责控制整个系统的流程。

-调度器(Scheduler):负责管理请求队列,并将请求发送给下载器。

-下载器(Downloader):负责下载网页,并将下载结果返回给引擎。

-爬虫(Spider):负责解析网页,并提取结构化数据。

-项目管道(Pipeline):负责处理结构化数据,并将其存储到数据库或文件中。

4.使用 Scrapy 下载文章的流程

使用 Scrapy 下载文章的流程如下:

-编写 Spider 类:用于定位需要爬取的页面,并解析其中的内容。

-配置 settings.py 文件:用于配置 Scrapy 的一些参数。

-运行 Scrapy 程序:使用 scrapy crawl 命令启动程序。

下面我们来看一下具体实现。

5.编写 Spider 类

首先,我们需要编写一个 Spider 类。这个类要继承 scrapy.Spider 类,并实现 name、allowed_domains 和 start_urls 属性和 parse 方法。其中:

- name 属性表示 Spider 的名称;

- allowed_domains 属性表示允许爬取的域名;

- start_urls 属性表示起始 URL;

- parse 方法用于解析页面内容。

代码如下所示:

python

import scrapy

class ArticleSpider(scrapy.Spider):

name ="article"

allowed_domains =["example.com"]

start_urls =[

"http://www.example.com/articles/1",

"http://www.example.com/articles/2",

"http://www.example.com/articles/3",

]

def parse(self, response):

article ={}

article['title']= response.xpath('//h1/text()').extract_first()

article['content']= response.xpath('//p/text()').extract()

yield article

6.配置 settings.py 文件

接下来,我们需要配置 settings.py 文件。这个文件包含了一些 Scrapy 的参数配置。具体内容如下所示:

python

BOT_NAME ='tutorial'

SPIDER_MODULES =['tutorial.spiders']

NEWSPIDER_MODULE ='tutorial.spiders'

ROBOTSTXT_OBEY = True

ITEM_PIPELINES ={

'tutorial.pipelines.ArticlePipeline': 300,

}

7.运行 Scrapy 程序

最后,我们可以使用 scrapy crawl 命令启动程序:

$ scrapy crawl article

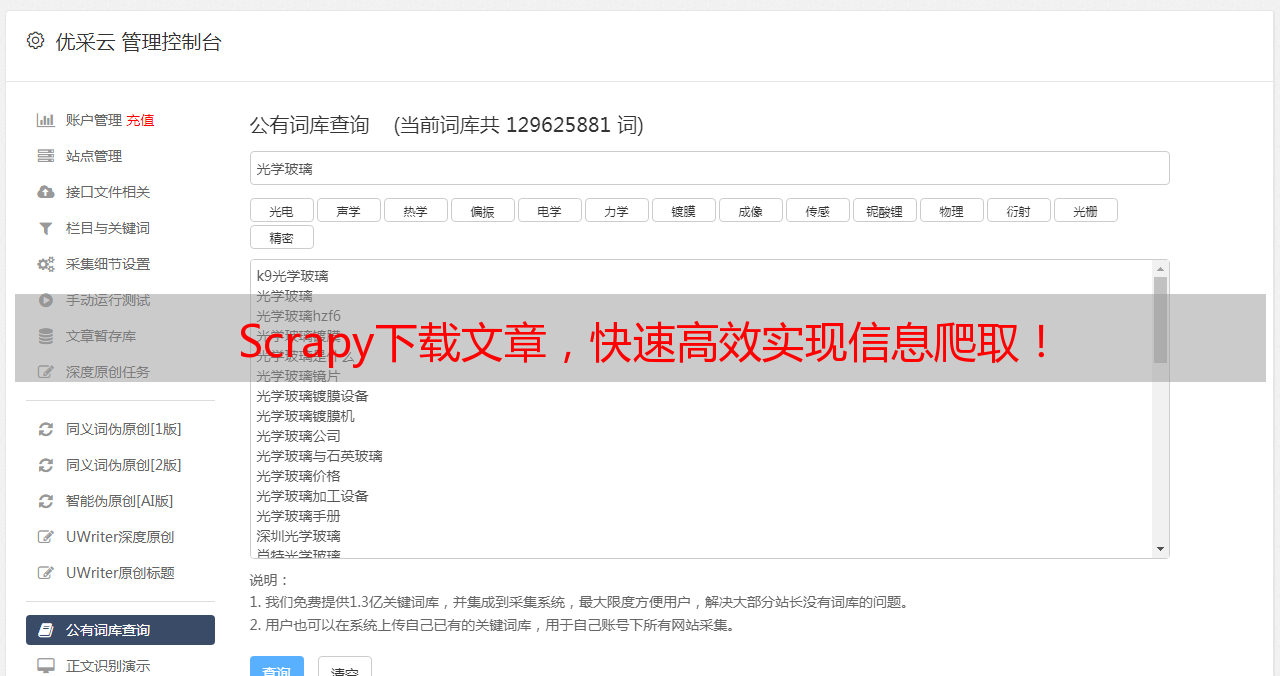

8.优采云

如果你想要更加专业、高效地进行网络爬虫开发,可以考虑使用优采云。优采云是一款全球领先的数据采集工具,它不仅支持各种类型的网站抓取,还提供了丰富的数据转换和清洗功能,在 SEO 优化等方面也有着非常出色的表现。如果你想要了解更多信息,请访问 www.ucaiyun.com。

9. SEO 优化

在进行网络爬虫开发时,我们也需要考虑 SEO 优化问题。具体来说,可以从以下几个方面入手:

- URL 设计:合理设计 URL 结构,并使用语义化 URL。

-页面标题和描述:设置页面标题和描述,并包含关键词。

-内容质量:保证网站内容质量高、独特、有价值。

-外部链接建设:增加外部链接数量和质量。

10.总结

通过本文介绍,相信大家对于如何使用 Scrapy 进行文章下载已经有了一定的了解。当然,在实际开发中还有很多需要注意的细节问题,需要根据具体情况进行调整。希望大家能够通过本文学习到一些有用的知识点,并在实际工作中得到应用。