探索网页采集器:爬虫工具的优势与应用

优采云 发布时间: 2023-03-13 00:11网页采集器是一种专门的爬虫工具,它可以帮助用户快速、高效地采集所需数据,并将其转化为结构化的数据格式。对于需要大量数据的行业,如电商、金融、医疗等,网页采集器可以帮助企业快速获取竞争对手的产品信息、市场情报等重要数据。本文将从多个角度介绍网页采集器的优势和应用。

一、网页采集器的基本原理

网页采集器通过模拟浏览器行为来访问目标网站,并将页面中的HTML代码或JavaScript代码解析成结构化数据存储。这种方式与人类浏览网页的方式非常相似,因此可以很好地应对反爬虫机制。同时,由于采集器可以自动化执行任务,因此能够大幅提高数据采集效率。

二、网页采集器的优势

相比手动爬取数据,使用网页采集器有以下优势:

1.高效性:采集器可以在短时间内完成大量数据抓取任务。

2.精准性:通过设置规则和过滤条件,可以精确地抓取所需数据。

3.自动化:一次设置规则后,可以自动执行抓取任务,无需人工干预。

4.可扩展性:通过编写自定义脚本或插件,可以扩展采集器功能。

三、网页采集器的应用场景

1.电商行业:通过抓取竞品价格、库存等信息来进行价格监控和竞争分析。

2.金融行业:通过抓取股票、期货等市场行情信息来进行投资分析和决策。

3.医疗行业:通过抓取医院排班信息、医生出诊时间等信息来方便患者挂号就诊。

4.教育行业:通过抓取学校招生计划、考试成绩等信息来进行招生和评估分析。

5.网络安全行业:通过抓取网络攻击事件、恶意软件等信息来进行安全威胁分析和预警。

四、如何选择合适的网页采集器?

在选择网页采集器时,需要考虑以下因素:

1.功能完备性:是否支持多种页面类型解析和数据格式输出?

2.技术支持力度:是否有完善的技术支持体系?

3.安全性保障:是否有反爬虫机制和隐私保护措施?

4.价格合理性:是否存在合理的付费模式?

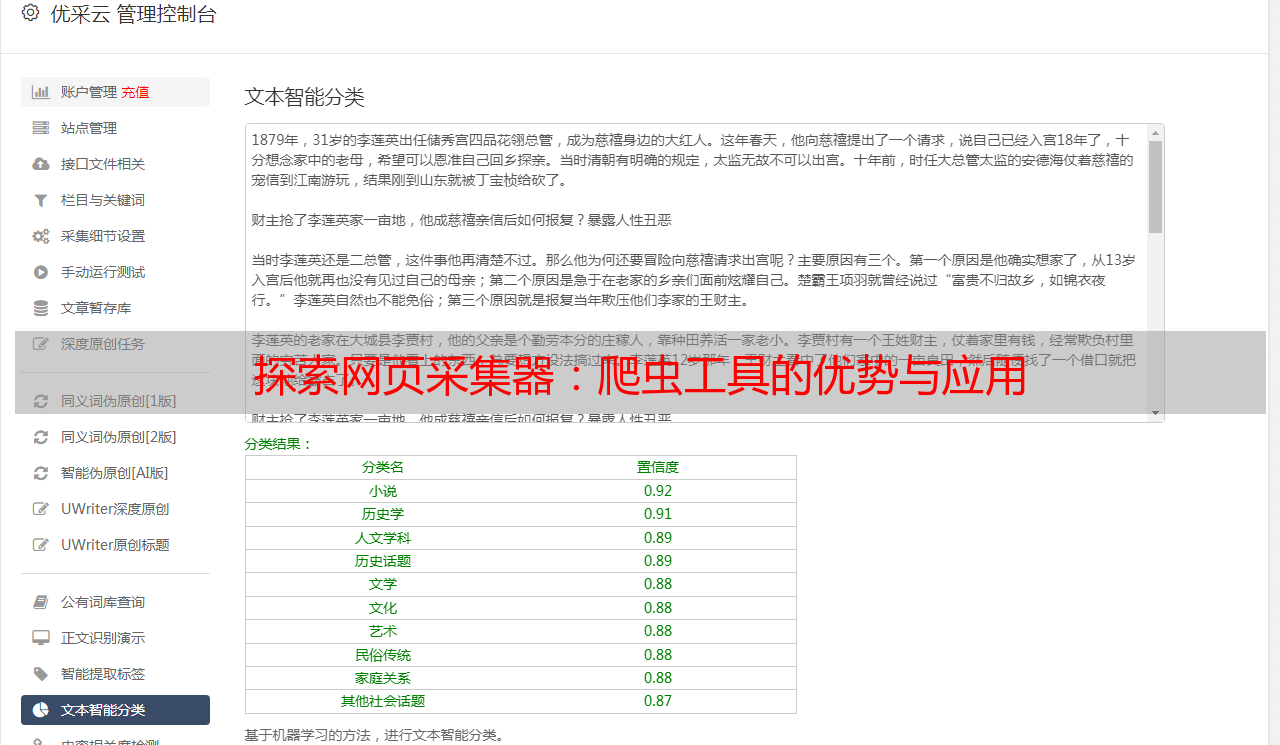

推荐使用优采云(www.ucaiyun.com)作为企业级网页采集工具,在功能完备性、技术支持力度、安全性保障和价格合理性上表现出色,在多个行业得到了广泛应用。

五、如何使用网页采集器做SEO优化?

SEO(搜索引擎优化)是指通过优化页面内容和结构,提高页面在搜索引擎中的排名。使用网页采集器可以帮助我们快速获取竞品关键词排名、外链资源等SEO关键指标,并针对这些指标进行优化。例如,在电商行业中,我们可以使用优采云抓取竞品商品标题和描述信息,并根据这些信息进行关键词优化和产品描述撰写。

六、如何防止被反爬虫机制封禁?

反爬虫机制是指目标站点为了防止被爬虫频繁访问而设立的限制措施。常见的反爬虫机制包括IP封禁、JS验证等。为了避免被封禁,我们需要注意以下几点:

1.合理设置请求频率和请求间隔时间;

2.设置User-Agent头部模拟浏览器访问;

3.使用代理IP池避免IP被封禁;

4.分布式部署多台服务器进行并发访问;

5.了解目标站点反爬虫机制并针对性处理。

七、如何编写自定义规则?

在某些情况下,标准规则不能满足我们的需求,需要编写自定义规则来实现特定功能。例如,在电商行业中,我们可能需要提取商品评论区中所有用户评价内容并存储到数据库中。此时就需要编写自定义规则来实现评论区内容提取和存储功能。以下是一个简单示例:

python

from ucaiyun import Spider, Rule, Item

spider = Spider()

item = Item()

item.field("user","//div[@class='comment']/span[1]/text()")

item.field("content","//div[@class='comment']/p/text()")

rule = Rule()

rule.link("//div[@class='page']/a/@href")

rule.item(item)

rule.next("//div[@class='page']/a[text()='下一页']/@href")

spider.add_rule(rule)

if __name__=='__main__':

spider.start('https://www.example.com/comments')

以上代码实现了一个简单的评论区内容提取功能,并支持翻页功能。更多自定义规则编写方法请参考官方文档(www.ucaiyun.com/docs)。

八、如何处理验证码?

验证码是常见的反爬虫机制之一,在处理验证码时我们通常有以下几种方法:

1.手动输入验证码:适用于验证码量较少且变化不频繁的情况;

2.自动识别验证码:适用于验证码量较大且变化频繁的情况;

3.使用已知验证码库进行匹配验证:适用于验证码类型较少且变化不频繁的情况;

4.跳过验证码环节直接进行访问:适用于对数据精度要求不高或者风险可控情况下使用。

九、如何保证数据质量?

在使用网页采集器时,保证数据质量非常重要。以下是几点建议:

1.增加数据源多样性以提高数据覆盖面;

2.设置合适过滤条件以去除无效或重复数据;

3.对异常或错误数据及时处理并记录日志;

4.定期检查更新规则以确保正确抓取目标站点最新版本内容。

十、结语

总之,网页采集器是一种非常实用而又强大的爬虫工具,在多个行业得到广泛应用。使用正确合理地利用它能够极大地提升企业在竞争中获取市场先机和战略洞察力。如果您还没有尝试过使用优采云(www.ucaiyun.com)作为企业级网页采集工具,请务必赶紧试试!