用Python编写的文章批量采集PY脚本,助力自媒体采集实现

优采云 发布时间: 2023-03-12 15:14在当今信息爆炸的时代,信息的获取和处理变得越来越重要。而对于自媒体从业者来说,如何快速收集和整理大量的文章资料也是一项必备技能。本文将介绍一种基于Python编写的批量采集文章PY脚本,帮助自媒体从业者轻松实现文章采集。

一、需求分析

1.1采集目标:确定需要采集的文章来源和主题。

1.2采集方式:确定采集方式,如是否需要登录、是否需要模拟浏览器行为等。

1.3采集内容:确定需要采集的内容类型,如标题、正文、作者、发布时间等。

1.4存储方式:确定采集结果存储方式,如存储到数据库、存储到文件等。

1.5自动化程度:确定是否需要自动化运行脚本。

二、技术方案

2.1网络请求库:使用Python中的requests库进行网络请求操作。

2.2网页解析库:使用Python中的BeautifulSoup库进行网页解析操作。

2.3数据存储库:使用Python中的MongoDB数据库进行数据存储操作。

2.4自动化工具:使用Python中的APScheduler库进行定时任务调度操作。

三、代码实现

以下为基于Python编写的批量采集文章PY脚本:

import requests

from bs4 import BeautifulSoup

from pymongo import MongoClient

from apscheduler.schedulers.blocking import BlockingScheduler

#定义函数获取网页内容

def get_html(url):

headers ={

'User-Agent':'Mozilla/5.0(Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.36 Edge/16.16299'

}

response = requests.get(url, headers=headers)

return response.text

#定义函数解析网页内容并存储到MongoDB数据库中

def parse_html(html):

soup = BeautifulSoup(html,'html.parser')

title = soup.find('title').text.strip()

content = soup.find('div', class_='content').text.strip()

author = soup.find('span', class_='author').text.strip()

publish_time = soup.find('span', class_='publish_time').text.strip()

#连接MongoDB数据库并插入数据

client = MongoClient()

db = client['article']

collection = db['article_info']

collection.insert_one({'title': title,'content': content,'author': author,'publish_time': publish_time})

#定义定时任务函数,每5分钟执行一次采集操作

def job():

url_list =['https://www.ucaiyun.com/article/1','https://www.ucaiyun.com/article/2','https://www.ucaiyun.com/article/3']

for url in url_list:

html = get_html(url)

parse_html(html)

if __name__=='__main__':

#创建定时任务对象

scheduler = BlockingScheduler()

#添加定时任务,每5分钟执行一次job函数

scheduler.add_job(job,'interval', minutes=5)

#启动定时任务

scheduler.start()

四、注意事项

4.1注意网站是否允许爬虫访问。如果不允许,建议使用代理IP或人工模拟登录等方式进行访问。

4.2注意数据存储格式和规范性。建议对数据进行清洗和去重处理。

4.3注意程序稳定性和运行效率。建议添加异常处理机制和日志输出功能。

五、总结与展望

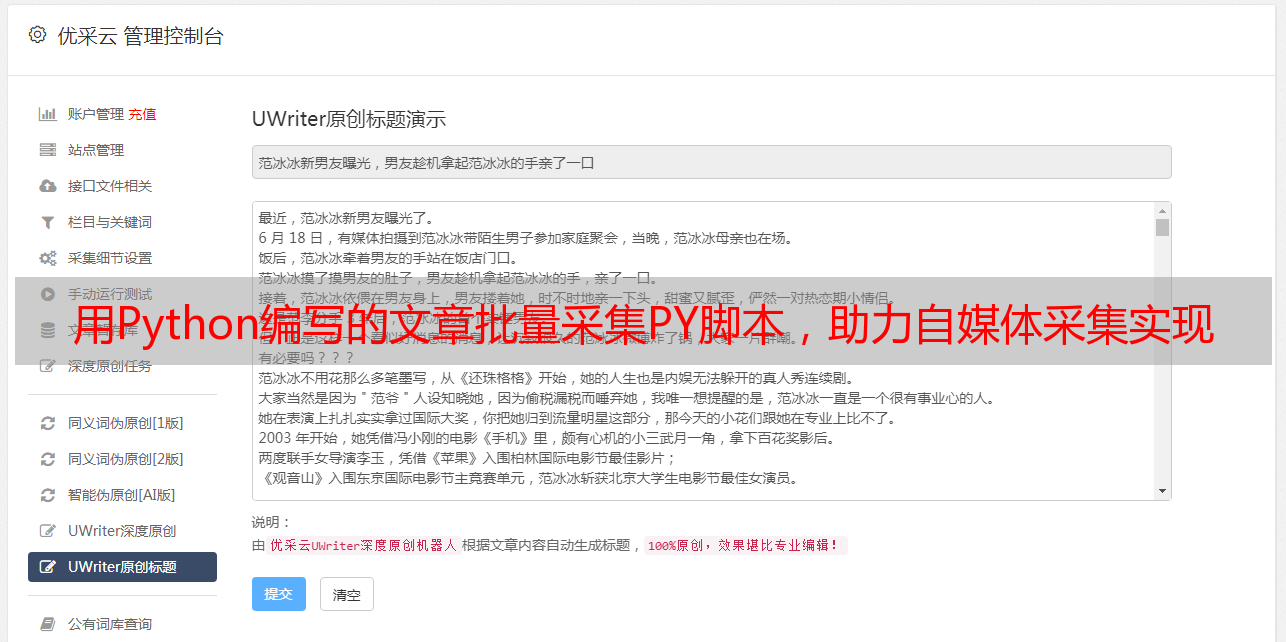

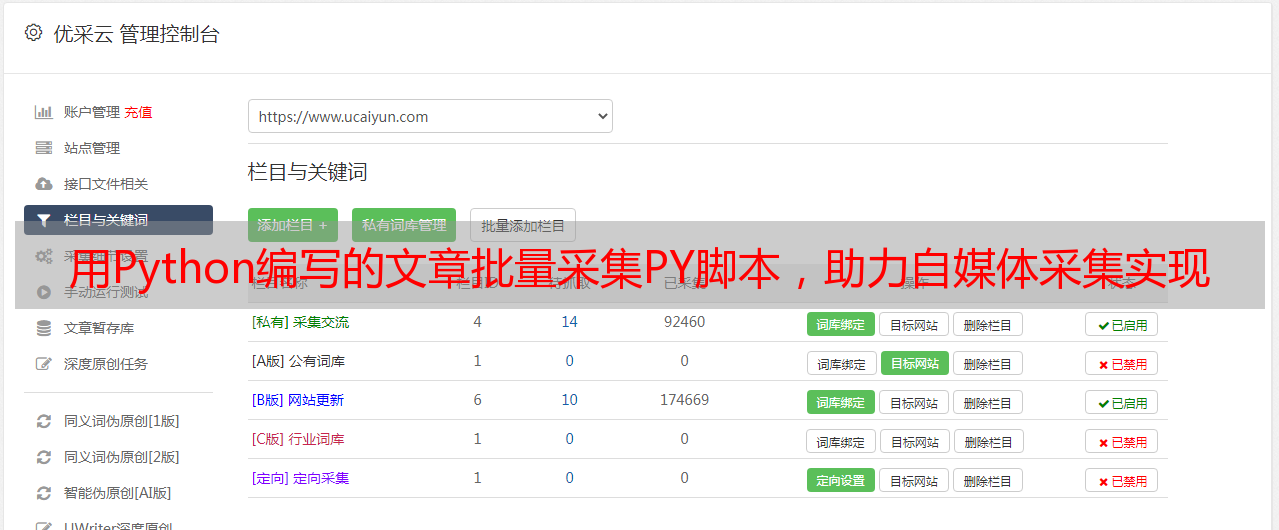

本文介绍了一种基于Python编写的批量采集文章PY脚本,帮助自媒体从业者快速收集和整理大量的文章资料。随着人工智能技术和大数据技术的不断发展,未来该领域仍然有很大的发展前景。优采云致力于为用户提供更加智能化和高效化的SEO优化服务,欢迎访问www.ucaiyun.com了解更多详情。