Python自动替换网页后缀,采集网页数据技巧

优采云 发布时间: 2023-03-12 05:07在当今数字化时代,网站的数据采集已成为一项重要的工作。然而,对于*敏*感*词*的网站采集来说,手动进行数据采集是非常不现实的。因此,如何利用自动化工具进行数据采集就成为了一个非常重要的问题。本文将介绍如何利用Python编写程序,通过自动替换网页后缀并采集每个网页的数据。

1.确定需要采集的信息

首先需要确定需要采集哪些信息。这包括网页的标题、描述、关键字、页面内容等等。在确定需要采集的信息之后,就可以开始编写程序了。

2.导入所需的库

在Python中,我们需要使用requests库来获取网页内容,使用BeautifulSoup库来解析HTML代码。

python

import requests

from bs4 import BeautifulSoup

3.获取网页内容

使用requests库获取网页内容,并将其存储在变量html中。

python

url ='http://www.example.com'

response = requests.get(url)

html = response.content

4.解析HTML代码

使用BeautifulSoup库解析HTML代码,并提取所需的信息。

python

soup = BeautifulSoup(html,'html.parser')

title = soup.title.string

description = soup.find('meta',{'name':'description'})['content']

keywords = soup.find('meta',{'name':'keywords'})['content']

content = soup.find('div',{'class':'content'}).get_text()

5.自动替换网页后缀

为了能够获取更多的网页内容,我们需要自动替换网页后缀。例如,在获取www.example.com下所有页面数据时,我们需要自动替换www.example.com/page1.html、www.example.com/page2.html等等。为了实现这一点,我们可以使用循环语句和字符串格式化操作。

python

for i in range(1, 11):

url ='http://www.example.com/71860c77c6745379b0d44304d66b6a13{}.html'.format(i)

response = requests.get(url)

html = response.content

#解析HTML代码并提取所需信息

soup = BeautifulSoup(html,'html.parser')

title = soup.title.string

description = soup.find('meta',{'name':'description'})['content']

keywords = soup.find('meta',{'name':'keywords'})['content']

content = soup.find('div',{'class':'content'}).get_text()

6.存储数据

获取到所需信息之后,我们需要将其存储起来。可以使用文件操作或数据库操作来实现。

python

#文件操作示例

with open('data.txt','a') as f:

f.write('{}\t{}\t{}\t{}\n'.format(title, description, keywords, content))

#数据库操作示例(以MySQL为例)

import pymysql

conn = pymysql.connect(host='localhost', user='root', password='123456', db='test')

cursor = conn.cursor()

sql ="INSERT INTO data (title, description, keywords, content) VALUES (%s,%s,%s,%s)"

cursor.execute(sql,(title, description, keywords, content))

conn.commit()

cursor.close()

conn.close()

7.避免被封IP

在进行*敏*感*词*数据采集时,很容易被目标网站封IP。为了避免这种情况发生,我们可以设置请求头和代理IP。

python

#设置请求头和代理IP示例(以爬取豆瓣电影TOP250为例)

headers ={

'User-Agent':'Mozilla/5.0(Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'}

proxies ={

"http":"http://127.0.0.1:1080",

"https":"https://127.0.0.1:1080",

}

url ='https://movie.douban.com/top250'

response = requests.get(url, headers=headers, proxies=proxies)

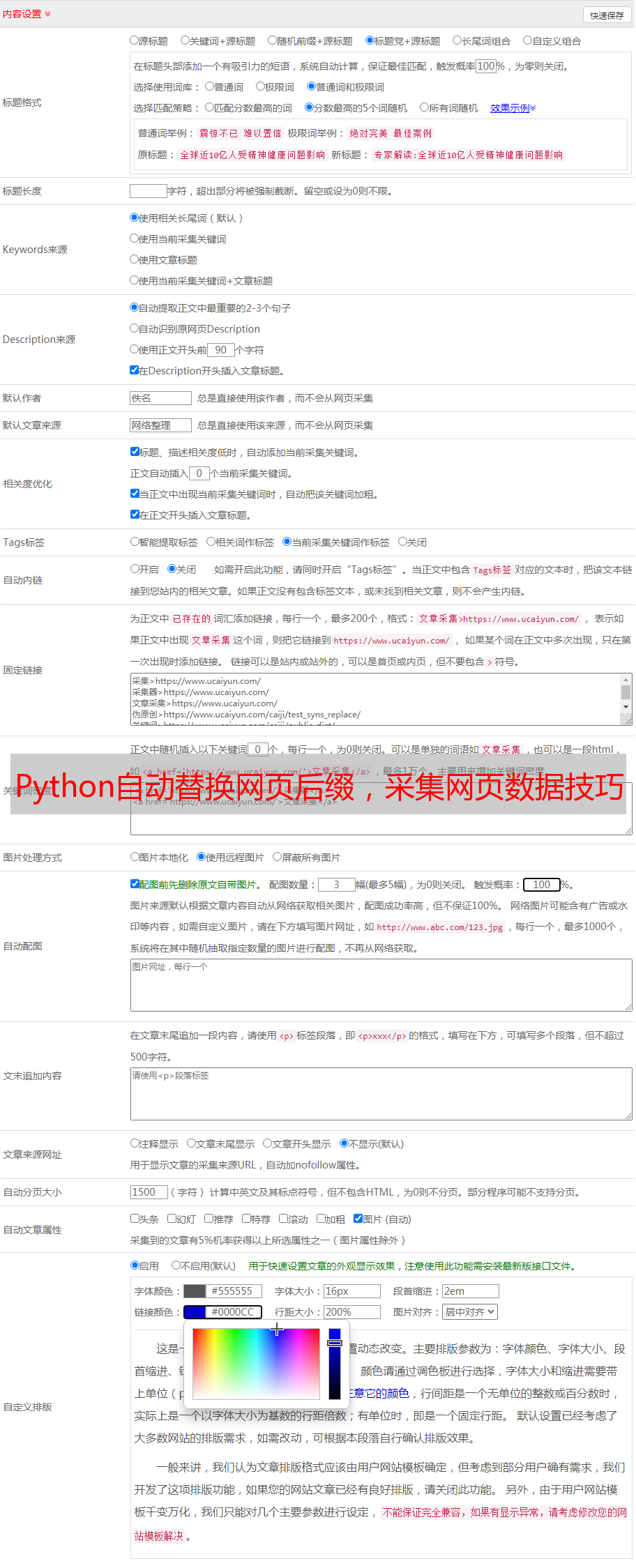

8. SEO优化

在进行网站优化时,SEO是非常重要的一环。通过合理地设置title、description、keywords等元素,并根据搜索引擎算法进行优化,可以使得目标网站获得更好的排名和流量。因此,在进行数据采集时,也应该考虑如何进行SEO优化。

9.优采云

如果您想更加方便地进行*敏*感*词*数据采集和SEO优化,可以考虑使用优采云平台。优采云是一款基于Python开发的云端爬虫平台,支持*敏*感*词*分布式爬取、异步IO、反爬虫策略等功能,并提供完善的SEO优化服务。如果您感兴趣,请访问官方网站:www.ucaiyun.com。

本文介绍了如何利用Python编写程序实现自动替换网页后缀并采集每个网页数据,并对相关技术进行了详细解释和分析。同时也介绍了如何避免被封IP和进行SEO优化,并推荐了一款优秀的云端爬虫平台——优采云。相信本文对于初学者和从业者都有一定参考价值。