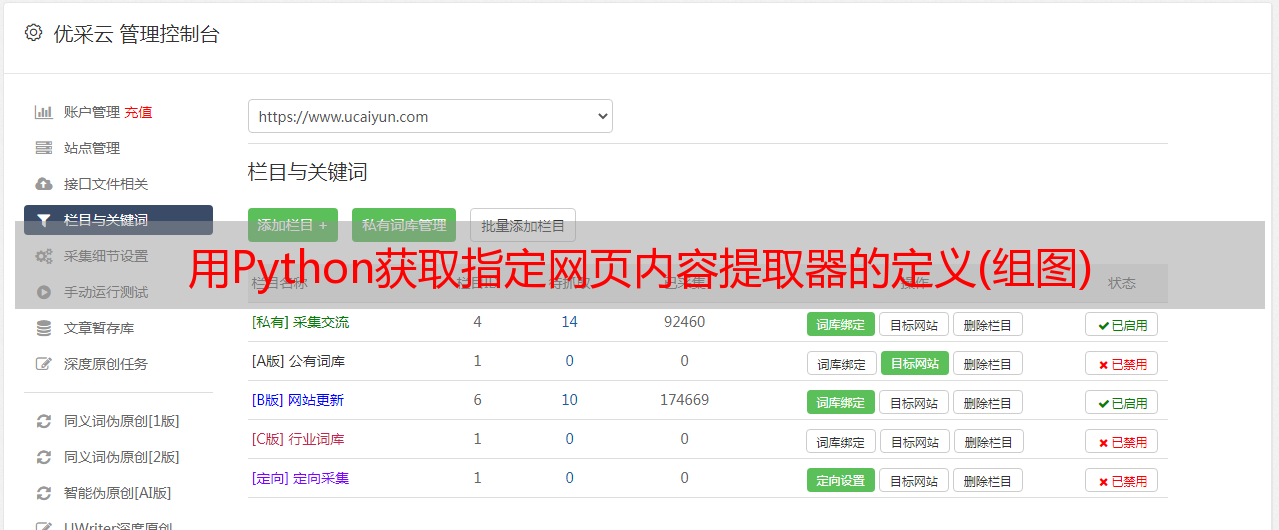

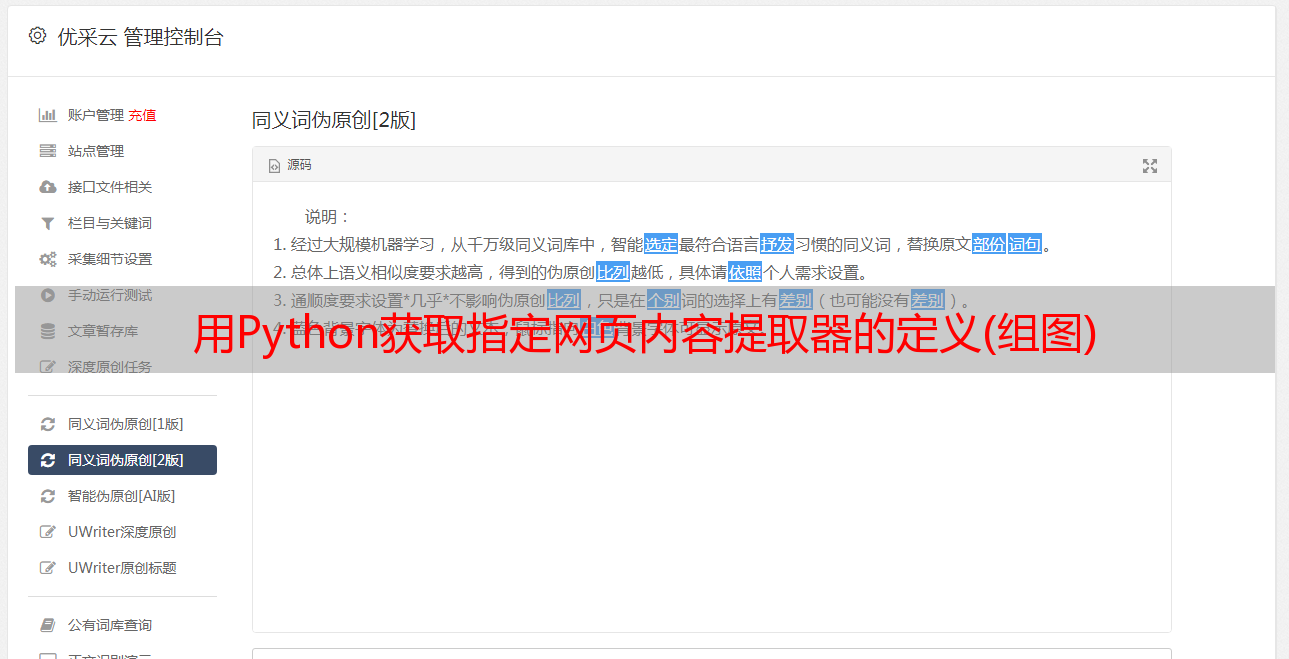

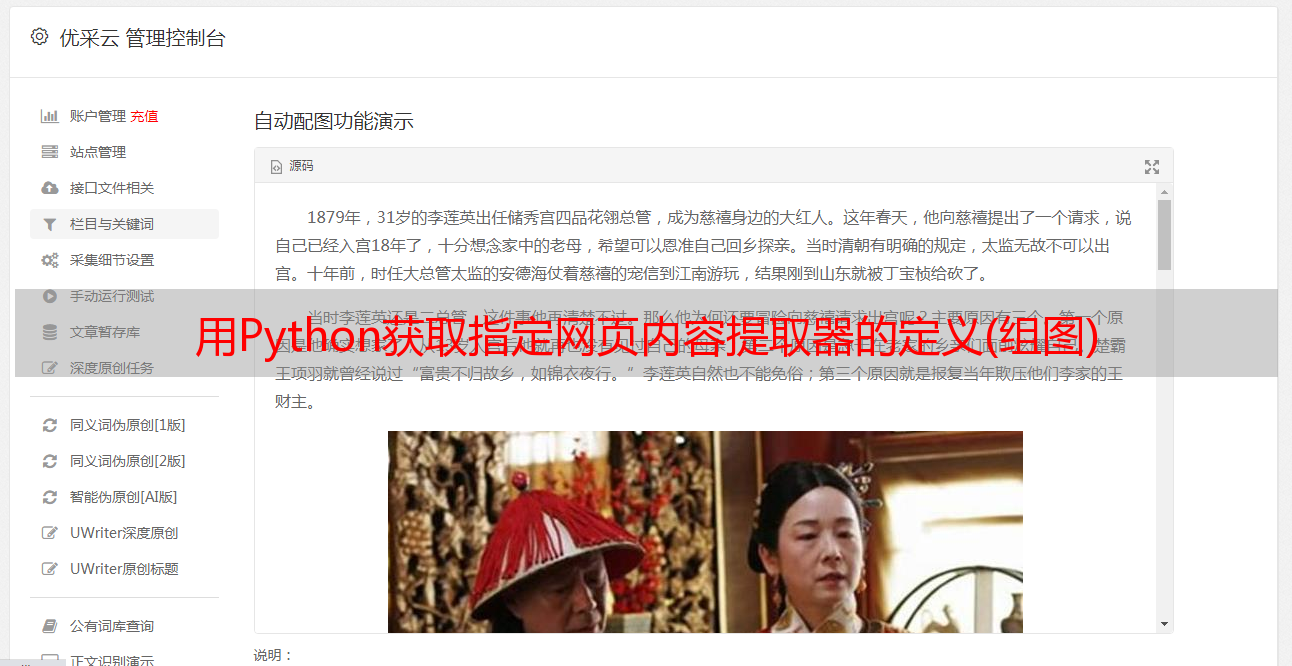

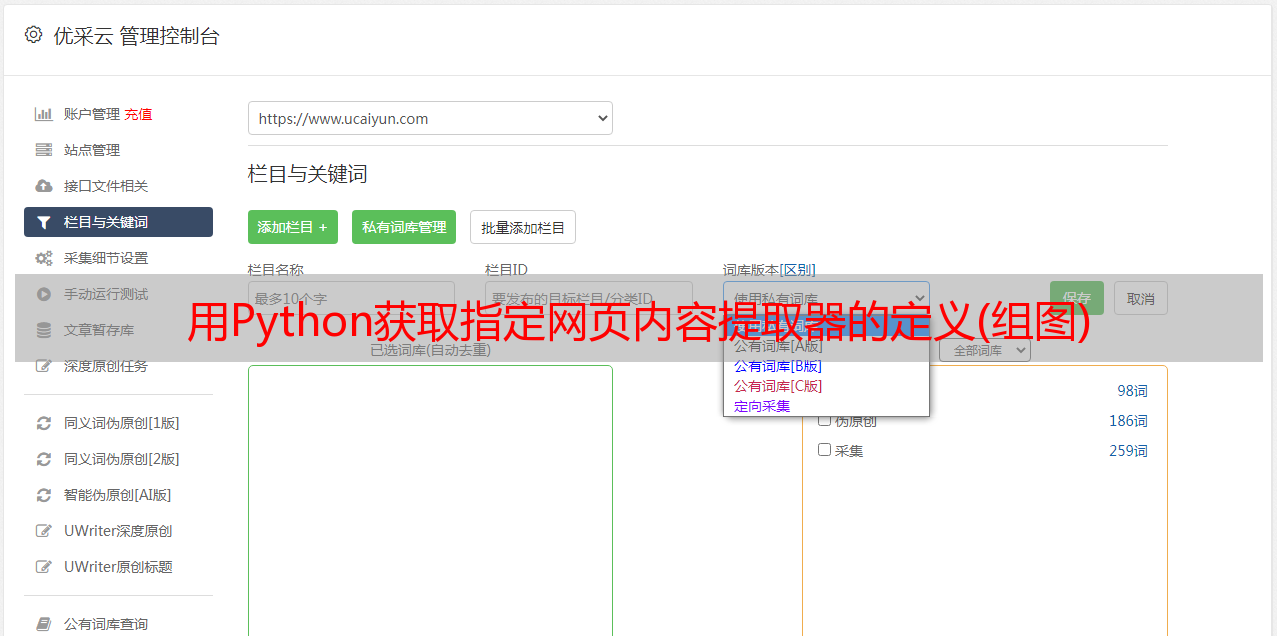

用Python获取指定网页内容提取器的定义(组图)

优采云 发布时间: 2021-06-11 18:23用Python获取指定网页内容提取器的定义(组图)

1、介绍

本文介绍了如何使用 GooSeeker API 接口下载 Java 和 JavaScript 中的内容提取器。这是一个示例程序。什么是内容提取器?为什么要使用这种方法?源自Python即时网络爬虫开源项目:通过生成内容提取器,大大节省了程序员的时间。详情请参考“内容提取器的定义”。

2、使用Java下载内容提取器

这是一系列示例程序之一。从目前的编程语言发展来看,Java提取网页内容并不合适。除了语言不够灵活方便,整个生态不够活跃,可选库增长缓慢。另外,从JavaScript动态网页中提取内容,Java也很不方便,需要JavaScript引擎。使用 JavaScript 下载内容提取器可以直接跳转到第 3 部分的内容。

具体实现

评论:

源码如下:

public static void main(String[] args)

{

InputStream xslt = null;

try

{

String grabUrl = "http://m.58.com/cs/qiuzu/22613961050143x.shtml"; // 抓取网址

String resultPath = "F:/temp/xslt/result.xml"; // 抓取结果文件的存放路径

// 通过GooSeeker API接口获得xslt

xslt = getGsExtractor();

// 抓取网页内容转换结果文件

convertXml(grabUrl, xslt, resultPath);

} catch (Exception e)

{

e.printStackTrace();

} finally

{

try

{

if (xslt != null)

xslt.close();

} catch (IOException e)

{

e.printStackTrace();

}

}

}

/**

* @description dom转换

*/

public static void convertXml(String grabUrl, InputStream xslt, String resultPath) throws Exception

{

// 这里的doc对象指的是jsoup里的Document对象

org.jsoup.nodes.Document doc = Jsoup.parse(new URL(grabUrl).openStream(), "UTF-8", grabUrl);

W3CDom w3cDom = new W3CDom();

// 这里的w3cDoc对象指的是w3c里的Document对象

org.w3c.dom.Document w3cDoc = w3cDom.fromJsoup(doc);

Source srcSource = new DOMSource(w3cDoc);

TransformerFactory tFactory = TransformerFactory.newInstance();

Transformer transformer = tFactory.newTransformer(new StreamSource(xslt));

transformer.transform(srcSource, new StreamResult(new FileOutputStream(resultPath)));

}

/**

* @description 获取API返回结果

*/

public static InputStream getGsExtractor()

{

// api接口

String apiUrl = "http://www.gooseeker.com/api/getextractor";

// 请求参数

Map params = new HashMap();

params.put("key", "xxx"); // Gooseeker会员中心申请的API KEY

params.put("theme", "xxx"); // 提取器名,就是用MS谋数台定义的规则名

params.put("middle", "xxx"); // 规则编号,如果相同规则名下定义了多个规则,需填写

params.put("bname", "xxx"); // 整理箱名,如果规则含有多个整理箱,需填写

String httpArg = urlparam(params);

apiUrl = apiUrl + "?" + httpArg;

InputStream is = null;

try

{

URL url = new URL(apiUrl);

HttpURLConnection urlCon = (HttpURLConnection) url.openConnection();

urlCon.setRequestMethod("GET");

is = urlCon.getInputStream();

} catch (ProtocolException e)

{

e.printStackTrace();

} catch (IOException e)

{

e.printStackTrace();

}

return is;

}

/**

* @description 请求参数

*/

public static String urlparam(Map data)

{

StringBuilder sb = new StringBuilder();

for (Map.Entry entry : data.entrySet())

{

try

{

sb.append(entry.getKey()).append("=").append(URLEncoder.encode(entry.getValue() + "", "UTF-8")).append("&");

} catch (UnsupportedEncodingException e)

{

e.printStackTrace();

}

}

return sb.toString();

}

返回结果如下:

3、使用 JavaScript 下载内容提取器

请注意,如果本示例中的 JavaScript 代码运行在网页上,由于跨域问题,无法抓取非站点网页的内容。因此,请运行在有特权的 JavaScript 引擎上,例如浏览器扩展、自主开发的浏览器以及自己程序中的 JavaScript 引擎。

为了实验的方便,这个例子还在网页上运行。为了避免跨域问题,目标网页被保存和修改,并在其中插入JavaScript。这么多手动操作只是为了实验,正式使用时还需要考虑其他方法。

具体实现

评论:

这是源代码:

返回结果截图如下

4、展望

您也可以使用 Python 来获取指定网页的内容。感觉Python的语法更简洁。稍后我们将添加 Python 语言的示例。有兴趣的朋友可以加入一起学习。

5、相关文件

1、Python即时网络爬虫:API说明

2、内容提取器的定义

6、GooSeeker开源代码下载源码采集

1、GooSeeker开源Python网络爬虫GitHub源码

7、文档修改历史

1, 2016-06-20: V1.0

上一章 API-下载内容提取器 下一章用 Python 驱动 Firefox