PHP爬虫:自动化采集公众号文章的实现方法

优采云 发布时间: 2023-03-12 02:09在当今信息时代,数据是企业决策的重要依据。而获取数据的手段之一,就是通过网络爬虫技术采集目标网站的数据。本文将介绍如何使用PHP编写爬虫程序,实现对公众号文章的自动化采集。

一、什么是网络爬虫?

网络爬虫(Web Crawler)是一种自动化获取互联网上信息的程序。它从指定的起始页面开始,按照一定规则,递归地抓取网页,并将有用信息保存。爬虫程序可以大量高效地获取数据,极大地减少了人工操作的工作量。

二、为什么需要爬虫?

1.采集大量数据

通过网络爬虫可以快速地采集大量数据,为企业决策提供重要依据。

2.自动化处理

通过编写脚本程序,可以实现对特定网站的自动化操作。例如:自动登录、自动填写表单、自动提交等。

3.统计分析

通过对采集到的数据进行统计分析,可以得出更加准确的结论和预测结果。

三、PHP语言简介

PHP全称为“Hypertext Preprocessor”,它是一种开源的服务器端脚本语言。在Web开发中,PHP被广泛应用于服务器端编程、网站开发等领域。PHP具有易学易用、跨平台等优点。

四、如何使用PHP编写网络爬虫?

1.确定目标

首先需要明确要采集的目标网站和目标信息。例如:我们要采集某个公众号的所有文章标题和链接。

2.分析页面结构

通过查看目标网站源代码和浏览器开发者工具,分析页面结构和元素特征。确定需要采集的元素和对应的CSS选择器或Xpath表达式。

3.编写程序

根据分析结果,使用PHP编写相应的程序代码。主要包括发送HTTP请求、解析HTML文档、提取目标元素等步骤。

4.存储数据

将采集到的数据存储到数据库或文件中,以便后续使用或分析。

五、案例演示:PHP爬取公众号文章

下面以某个公众号为例,演示如何使用PHP编写网络爬虫程序,实现对该公众号所有文章标题和链接的自动化采集。

1.确定目标

我们要采集“科技美学”公众号所有文章标题和链接。

2.分析页面结构

打开“科技美学”公众号首页,在浏览器开发者工具中查看HTML源代码:

从代码中可以看出,“科技美学”公众号首页是一个包含多篇文章列表的页面。每篇文章都有一个标题和链接地址。

我们需要抓取每篇文章的标题和链接地址,并保存到数据库中。

3.编写程序

根据分析结果,我们可以编写如下代码:

php

<?php

//设置请求头信息

$header = array(

'User-Agent:a9694ebf4d02ef427830292349e3172c/5.0(Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.36 Edge/16.16299',

'Referer: https://mp.weixin.qq.com/',

'Cookie:这里填写你登录微信公众平台后获取到的cookie'

);

//设置请求参数

$url ="https://mp.weixin.qq.com/mp/profile_ext?action=getmsg&__biz=MjM5NzYwNjIwMA==&f=json&offset=0&count=10&is_ok=1&scene=124&uin=777&key=777&pass_ticket=12345678901234567890123456789012&wxtoken=&appmsg_token=12345678901234567890123456789012&x5=0&f=json";//这里修改成你想要抓取的微信公众号链接

$ch = curl_init($url);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, true);

curl_setopt($ch, CURLOPT_HTTPHEADER,$header);

curl_setopt($ch, CURLOPT_SSL_VERIFYPEER, false);

curl_setopt($ch, CURLOPT_SSL_VERIFYHOST, false);

$b311cc12441f1b8803b511e0e1c71fb6= curl_exec($ch);

curl_close($ch);

//解析JSON数据

$json = json_decode($output, true);

//遍历JSON数组

foreach ($json['general_msg_list']['list'] as $item){

//获取文章标题

$title =$item['app_msg_ext_info']['title'];

//获取文章链接

$url =$item['app_msg_ext_info']['content_url'];

//输出结果

echo "标题:".$title ."\n";

echo "链接:".$url ."\n";

}

以上代码中,我们使用了CURL库发送HTTP请求,并添加了必要的请求头信息。然后解析返回结果中包含文章信息的JSON数组,并遍历数组提取出每篇文章标题和链接地址,并输出到控制台。

4.存储数据

如果需要将抓取到的数据保存到数据库或文件中,可以添加相应代码实现。这里不再赘述。

六、注意事项

1.遵守法律法规

在进行网络爬虫时,应遵守相关法律法规及道德规范。不得非法获取他人隐私信息或商业机密等敏感信息。

2.注意反扒策略

有些网站会针对爬虫进行反扒策略,请注意调整访问频率或使用代理IP等方式规避反扒策略。

七、总结

本文介绍了如何使用PHP编写网络爬虫程序,并以某个微信公众号为例演示了如何实现对该公众号所有文章标题和链接地址的自动化采集。在进行网络爬虫时,请务必遵守相关法律法规及道德规范,并注意防范反扒策略。

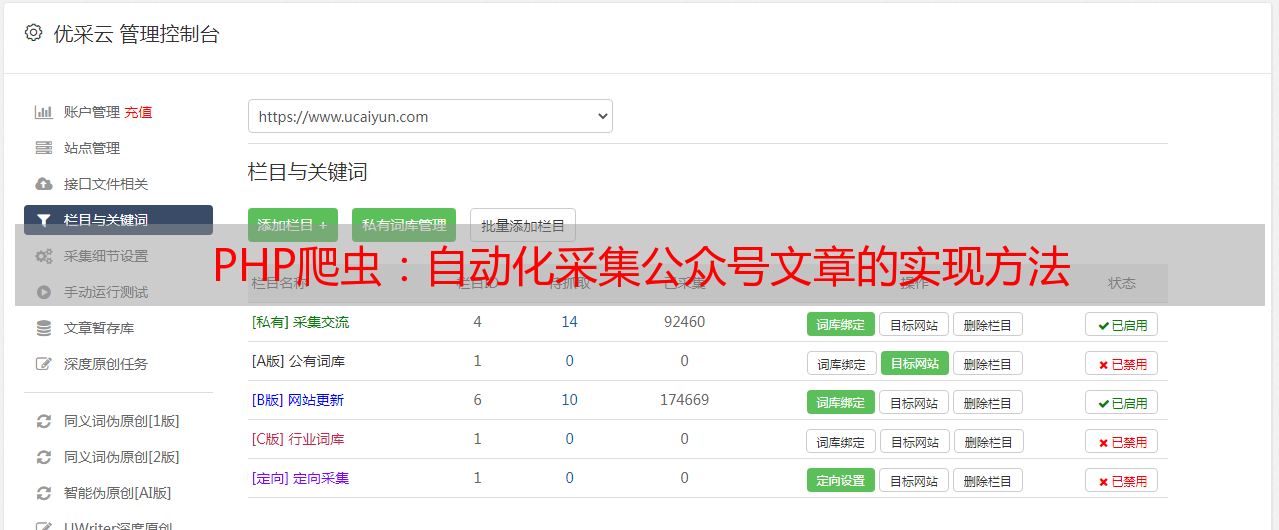

八、关于优采云

优采云(www.ucaiyun.com)是一家专业提供SEO优化服务及工具的公司。我们拥有多年SEO优化经验,在搜索引擎排名提升方面有着卓越表现。如果您需要优化您公司网站,请联系我们!

九、参考资料

1.PHP Manual:http://php.net/manual/en/

2.cURL库官方文档:https://curl.se/docs/

3.Xpath语法参考手册:http://www.w3school.com.cn/xpath/index.