自动抓取数据开源产品,快速高效获取所需数据的优势!

优采云 发布时间: 2023-03-12 01:10随着互联网的快速发展,数据已成为企业竞争的重要资源。如何快速高效地获取所需数据,自动化抓取技术成为了必不可少的一环。本文将从以下8个方面,深入探讨自动抓取数据开源产品的使用及优势。

一、什么是自动抓取数据?

自动抓取数据是指利用计算机程序在互联网上自动获取所需信息的过程。其优点在于高效、准确、节省人力成本。而开源产品则指由志愿者共同维护和更新的软件、工具等资源,具有优质且免费的特点。

二、为什么选择开源产品?

开源产品有许多优势,比如代码可见性高、社区支持强大、更新及时等。此外,开源产品也更容易被集成到现有系统中,提高了企业的效率和竞争力。

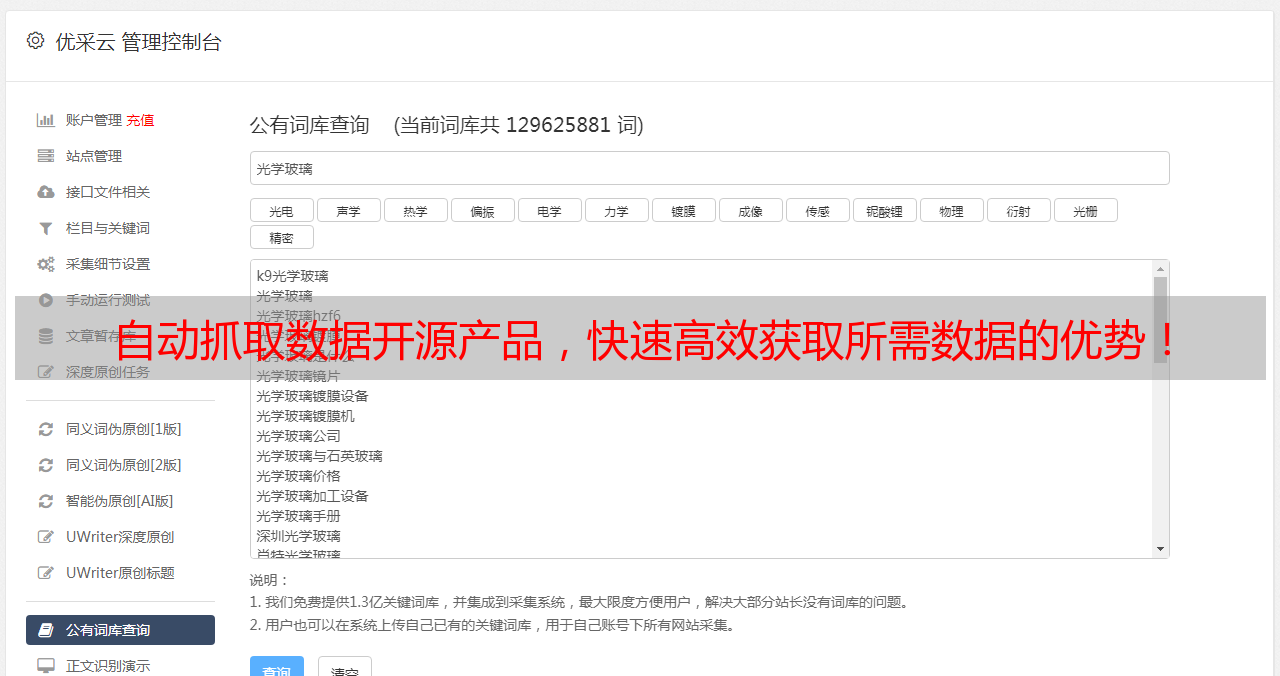

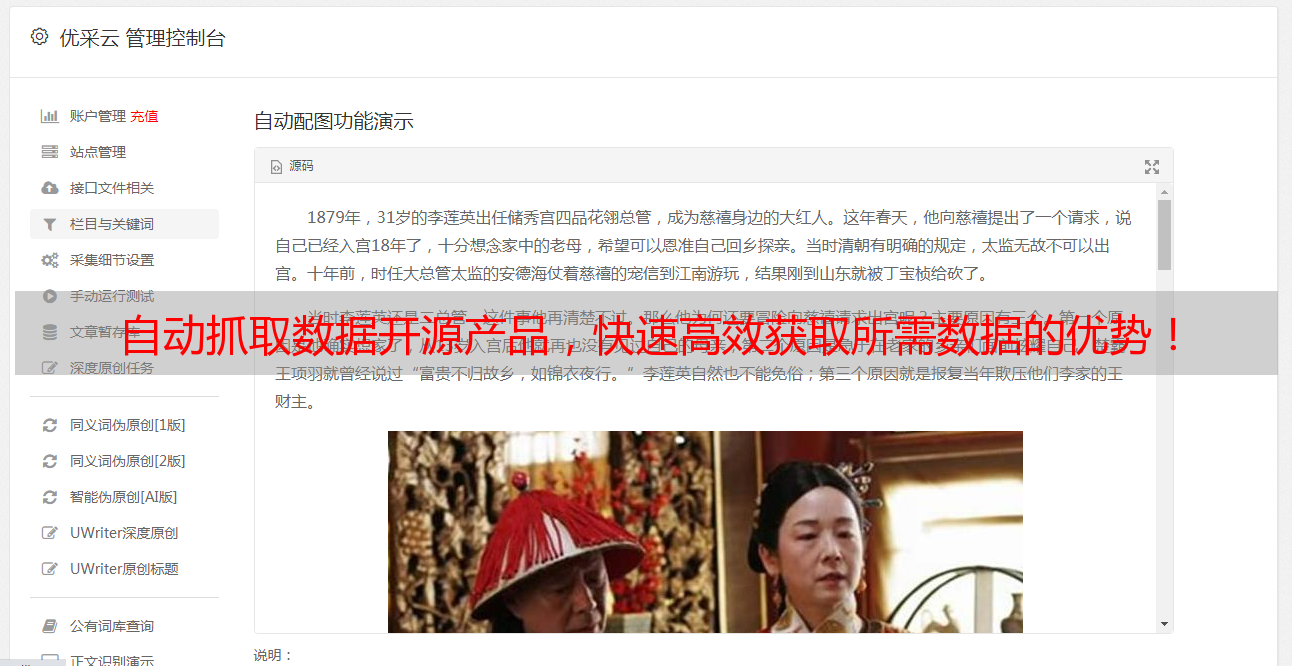

三、哪些开源产品可以用于自动抓取数据?

目前市面上有很多优秀的自动抓取数据开源产品,比如Scrapy、BeautifulSoup、Selenium等。这些工具不仅能够实现各种网站的爬取,还支持多种操作系统和编程语言。

四、如何使用Scrapy进行数据抓取?

Scrapy是一个基于Python的爬虫框架,可以快速高效地抓取各类信息。使用Scrapy需要掌握基本编程知识,并对XPath和CSS选择器有一定了解。以下是一个简单的Scrapy代码示例:

import scrapy

class MySpider(scrapy.Spider):

name ='myspider'

start_urls =['http://www.example.com']

def parse(self, response):

#解析页面并提取所需信息

pass

五、如何使用BeautifulSoup进行数据解析?

BeautifulSoup是一个Python库,可以帮助用户解析HTML和XML文档。它可以非常方便地从网页中提取所需信息,并以结构化形式返回结果。以下是一个简单的BeautifulSoup代码示例:

from bs4 import BeautifulSoup

#创建一个BeautifulSoup对象

soup = BeautifulSoup(html_doc,'html.parser')

#查找所有<a>标签,并输出它们的href属性

for link in soup.find_all('a'):

print(link.get('href'))

六、如何使用Selenium进行模拟操作?

Selenium是一个用于Web应用程序测试和Web浏览器自动化的工具。它可以模拟用户在浏览器中进行各种操作,并且支持多种浏览器。以下是一个简单的Selenium代码示例:

from selenium import webdriver

#创建一个Chrome浏览器实例

driver = webdriver.Chrome()

#打开百度首页并搜索“Python”

driver.get('https://www.baidu.com/')

elem = driver.find_element_by_name('wd')

elem.send_keys('Python')

elem.submit()

#关闭浏览器

driver.quit()

七、如何避免被封IP?

由于大部分网站都设置了反爬虫机制,因此在进行数据抓取时需要注意一些技巧。比如合理设置请求频率和伪装请求头等方法可以有效避免被封IP。

八、结语

总之,在进行自动抓取数据时,选择合适的开源产品非常重要。通过学习以上8个方面内容,相信读者已经对如何选择和使用自动抓取数据开源产品有了更深入的了解。

优采云专注于SEO优化服务,致力于为企业提供更好更全面的数字营销解决方案。欢迎访问我们的官网 www.ucaiyun.com 了解更多详情!