Python爬虫轻松提取今日头条作者文章,快来学习!

优采云 发布时间: 2023-03-12 00:10想要成为一个优秀的自媒体作者,不仅需要有独特的创意和观点,还需要不断学习和积累。而对于大多数人来说,学习的过程中最好的方法就是看别人是如何写作、发布、推广的。今日头条作为国内最大的自媒体平台之一,拥有众多优秀的作者和精彩的文章。那么如何才能轻松地获取这些文章呢?本文将介绍如何使用Python爬虫技术来爬取今日头条作者的文章。

1.爬虫工具

在开始爬取之前,我们需要选择一个合适的爬虫工具。Python语言是目前使用最广泛的爬虫语言之一,因此我们可以选择Python相关的爬虫框架进行开发。常用的Python爬虫框架包括Scrapy、Beautiful Soup、Selenium等等。本文将使用Scrapy框架进行讲解。

2.分析目标网站

在编写爬虫代码之前,我们需要对目标网站进行分析,了解其网页结构和数据格式。首先我们需要找到今日头条作者列表页面的URL地址,并通过浏览器开发者工具查看其HTML源码。我们可以发现作者列表页面中每个作者都有一个独特的ID号,并且每个ID号对应着该作者发布的所有文章。因此我们可以通过获取每个作者ID号来进一步获取该作者发布的所有文章。

3.构建爬虫代码

在构建爬虫代码之前,我们需要安装Scrapy框架并创建一个新项目。在新项目中创建一个名为“spiders”的文件夹,并创建一个名为“toutiao.py”的Python文件用于编写爬虫代码。以下是基本代码结构:

import scrapy

class ToutiaoSpider(scrapy.Spider):

name ="toutiao"

def start_requests(self):

urls =[

'https://www.toutiao.com/ch/news_hot/'

]

for url in urls:

yield scrapy.Request(url=url, callback=self.parse)

def parse(self, response):

#解析HTML源码

pass

在上述代码中,我们创建了一个名为“ToutiaoSpider”的类,并定义了两个方法:start_requests和parse。start_requests方法用于发送HTTP请求获取目标网页HTML源码,而parse方法用于解析源码并提取所需数据。

4.解析HTML源码

在parse方法中,我们需要使用XPath或CSS选择器等方式解析HTML源码并提取所需数据。以下是示例代码:

def parse(self, response):

#使用XPath选择器提取所有作者ID号

author_ids = response.xpath('//div[@class="author-list"]/ul/li/@data-userid')

for author_id in author_ids:

#构建每个作者页面URL地址

author_url ='https://www.toutiao.com/c/user/{}/'.format(author_id.extract())

yield scrapy.Request(url=author_url, callback=self.parse_author)

def parse_author(self, response):

#使用CSS选择器提取该作者发布的所有文章标题

titles = response.css('.title::text').extract()

for title in titles:

#输出文章标题

print(title)

在上述代码中,我们首先使用XPath选择器提取所有作者ID号,并通过循环遍历每个ID号构建对应作者页面URL地址,并发送HTTP请求获取该页面HTML源码。接着,在parse_author方法中使用CSS选择器提取该作者发布的所有文章标题,并循环输出到控制台。

5.数据存储

在实际应用中,我们需要将爬取到的数据保存到数据库或文件中以备后续分析和处理。以下是示例代码:

import json

def parse_author(self, response):

#使用CSS选择器提取该作者发布的所有文章信息

items =[]

for sel in response.css('.wcommonFeed'):

item ={}

item['title']= sel.css('.title::text').extract_first().strip()

item['url']= sel.css('.title::attr(href)').extract_first().strip()

item['abstract']= sel.css('.abstract::text').extract_first().strip()

items.append(item)

#将数据保存到JSON文件中

with open('data.json','a', encoding='utf-8') as f:

json.dump(items,f, ensure_ascii=False)

在上述代码中,我们使用CSS选择器提取该作者发布的所有文章信息,并将其保存到字典对象item中,并将字典对象添加到列表items中。接着,我们将items列表保存到JSON文件中以备后续处理。

6.反反爬策略

由于大多数网站都设有反爬机制,因此我们需要采取一些措施来规避反爬机制以确保正常爬取数据。以下是一些常用反反爬策略:

-随机User-Agent:每次发送HTTP请求时随机生成User-Agent头部信息;

-设置延迟时间:模拟人类行为设置延迟时间以避免频繁访问;

-使用代理IP:使用代理IP隐藏真实IP地址;

-登录账户:登录账户后可获得更高权限访问。

7. SEO优化

除了正常爬取数据外,我们还需要考虑SEO(Search Engine Optimization)优化问题以确保网站能够被搜索引擎收录并排名靠前。以下是一些常用SEO优化策略:

-合理布局:合理布局网站内容以提高用户体验;

-关键词优化:合理使用关键词以便搜索引擎更好地理解网站内容;

-内容质量:提供高质量、原创性内容以吸引用户;

-外链建设:增加外链链接以提高网站权重;

-网站速度:减少页面加载时间以提高用户体验。

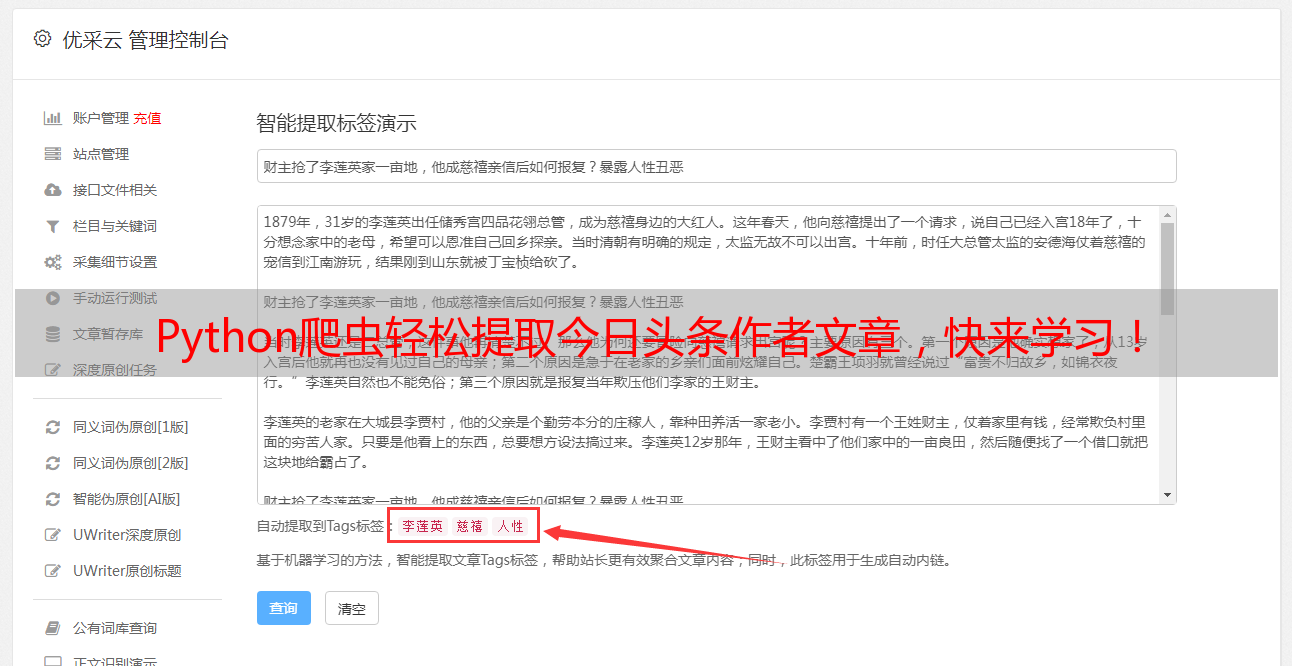

8.优采云

如果您不想自己编写Python程序进行网络数据挖掘和抓取,则可以尝试使用专业云服务——优采云(www.ucaiyun.com)。它可以帮助您快速搭建并管理网络抓取、数据清洗、存储和分析系统。

9.总结

本文介绍了如何使用Python编写Scrapy框架进行网络数据挖掘和抓取,并讲解了常见反反爬策略和SEO优化策略等相关知识。希望读者能够通过本文学习到实用技能,并运用到实际应用场景中去。