爬虫抓取公开数据的实用技巧和工具,快速获取所需信息

优采云 发布时间: 2023-03-11 20:13在数据分析领域中,数据的质量和数量对结果有着至关重要的影响。而如何获取大量高质量的数据则成为了一个值得探讨的问题。爬虫技术就是其中一种解决方案,它可以通过自动化程序对网页进行抓取,从而获取大量的公开数据。本文将深入探讨爬虫技术在公开数据获取中的应用,并提供一些实用的技巧和工具。

一、什么是爬虫技术?

爬虫技术又称网络爬虫、网络蜘蛛、网络机器人等,是一种自动化程序,可以模拟人类浏览器行为,从互联网上抓取信息并进行处理的技术。通俗地说,就是通过代码自动访问网页并提取有用信息的过程。爬虫技术广泛应用于搜索引擎、电商平台、新闻媒体等领域。

二、为什么要使用爬虫技术获取公开数据?

随着互联网技术的普及和发展,越来越多的公开数据被发布到了网上。这些数据包括政府部门发布的统计数据、企业发布的财务报表、社交媒体上用户生成的内容等。这些公开数据具有丰富性和实时性,对于企业决策、学术研究等领域都有着重要意义。而使用传统手段获取这些数据往往需要耗费大量时间和人力成本。利用爬虫技术可以快速高效地获取这些公开数据,并且还能够获取到更加详细和全面的信息。

三、如何使用爬虫技术获取公开数据?

1.确定目标网站

首先需要确定需要抓取哪些网站上的信息。建议选择一些公开且稳定可靠的网站,例如政府部门官网、知名新闻媒体等。

2.分析目标网站结构

在确定目标网站后,需要对其进行结构分析。这包括了解目标网站页面结构、URL规则、反爬策略等内容。只有深入了解目标网站结构才能编写出有效且不易被封禁的爬虫程序。

3.编写爬虫程序

根据目标网站结构编写相应的爬虫程序。常见编程语言如Python、Java等都有相应的网络库可以方便地实现网络请求和HTML解析等功能。

4.处理反爬策略

为了防止恶意爬虫对目标网站造成过大负荷或者滥用目标网站资源,很多网站都会设置反爬策略,例如IP限制、验证码识别等。因此,在编写爬虫程序时需要注意处理这些反爬策略。

5.存储和处理抓取到的信息

成功抓取到信息后需要将其存储起来,并进行相应处理后才能得到有价值的结果。常见存储方式包括数据库存储、文本文件存储等。

四、如何避免法律风险?

使用爬虫技术获取公开数据需要遵守相关法律法规和伦理道德规范。例如,在中国境内使用爬虫技术必须符合《计算机软件保护条例》《互联网信息服务*敏*感*词*》《计算机信息网络国际联网安全保护*敏*感*词*》等法规规定。同时,在使用过程中也要遵守隐私保护原则和个人信息保护相关法律规定。

五、常见问题及解决方法

1.如何处理JavaScript渲染页面?

如果目标页面采用JavaScript渲染,则需要使用模拟浏览器行为或者直接调用API来获取渲染后页面内容。

2.如何处理反爬机制?

对于IP限制可以通过代理服务器轮换IP地址;对于验证码可以通过OCR识别或者手动输入来解决。

3.如何避免被封禁?

建议设置合适的请求频率和请求头信息,并及时更新代码以适应目标站点变化。

4.如何保证数据质量?

需要注意选择合适的抽样方式,并加入去重和异常值检测等处理手段来提升数据质量。

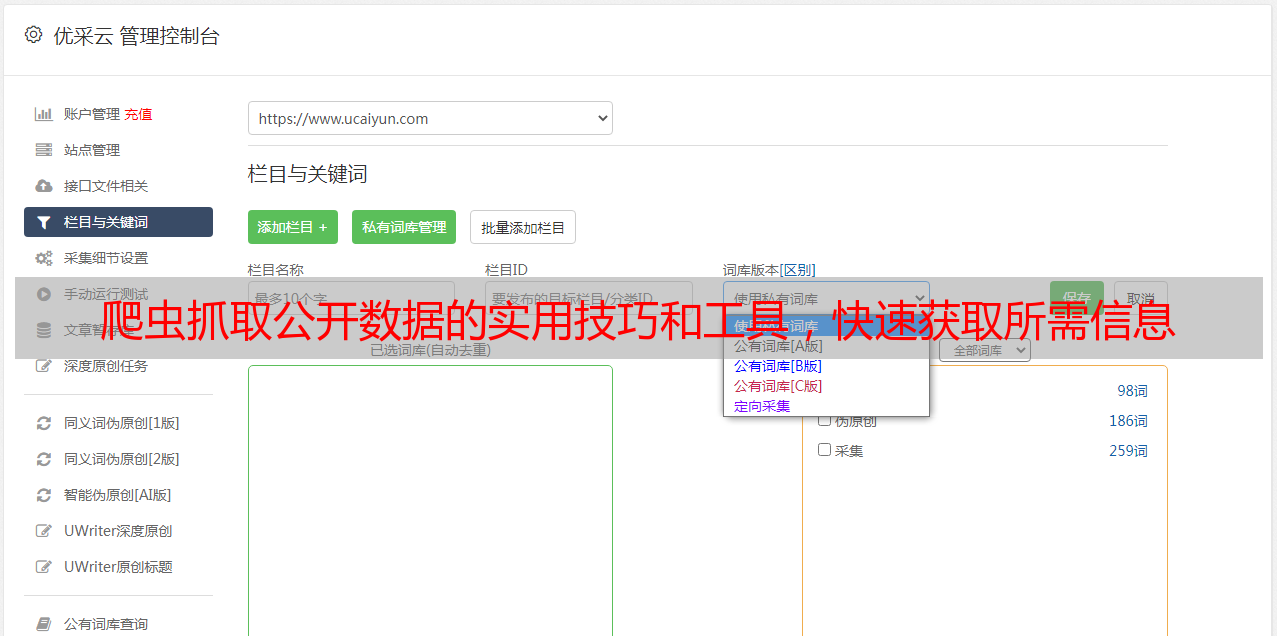

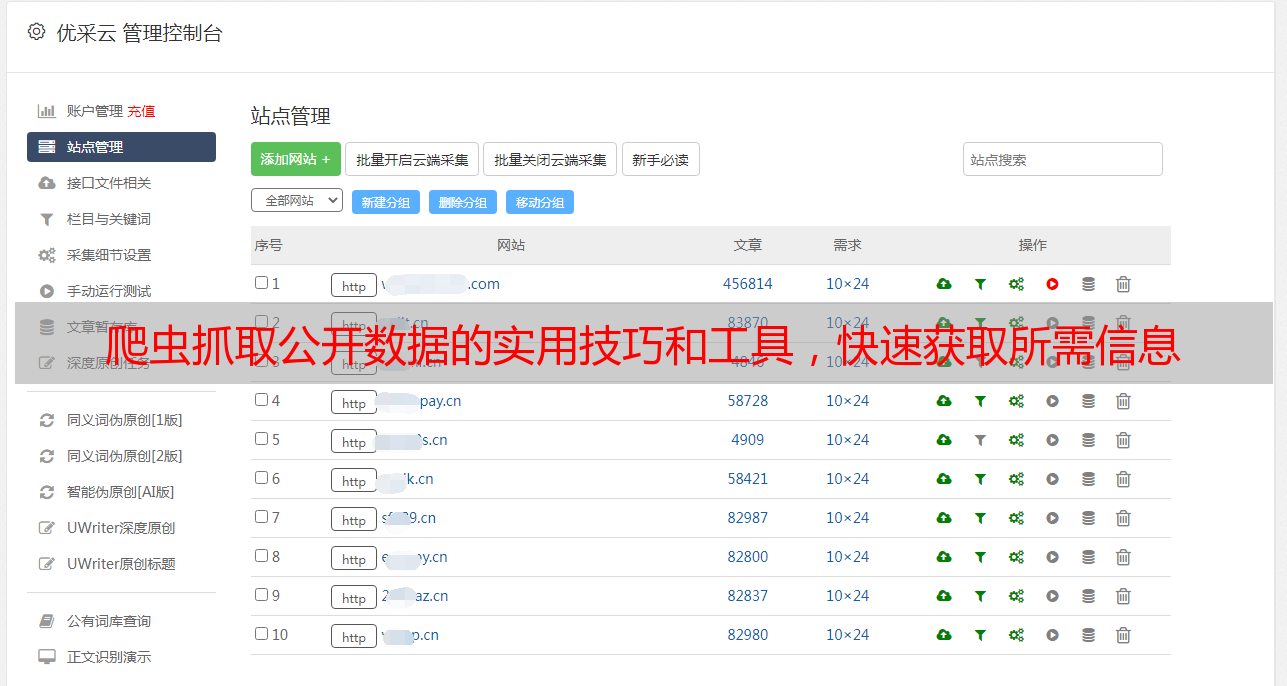

六、优采云提供专业SEO优化服务

优采云是一家专注于SEO优化服务的公司,提供全面优化方案以帮助企业实现更好排名和流量增长。我们拥有专业团队和先进工具,在关键词研究、竞争分析、内容创作等方*敏*感*词*备丰富经验,并可根据客户需求提供个性化服务方案。如果您需要SEO优化服务,请联系我们:www.ucaiyun.com 。

七、案例分享:利用Python实现微信公众号文章自动化采集

以下是一个基于Python编写的微信公众号文章自动化采集程序示例:

python

import requests

from bs4 import BeautifulSoup

import re

import time

import pandas as pd

#设置请求头

headers ={

'User-Agent':'Mozilla/5.0(Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'}

#获取文章列表

def get_articles(url):

articles =[]

res = requests.get(url, headers=headers)

soup = BeautifulSoup(res.text,'html.parser')

items = soup.select('.news-list li')

for item in items:

title = item.select('.txt-box h3')[0].text.strip()

link = item.select('.txt-box h3 a')[0]['href']

date = item.select('.s-p a')[0].text.strip()

articles.append({'title': title,'link': link,'date': date})

return articles

#获取文章内容

def get_content(link):

res = requests.get(link, headers=headers)

soup = BeautifulSoup(res.text,'html.parser')

content =''

items = soup.select('#js_content p')

for item in items:

content += item.text.strip()+'\n'

return content

#主函数

if __name__=='__main__':

url ='https://weixin.sogou.com/weixin?type=2&s_from=input&query=%E6%95%B0%E6%8D%AE%E5%88%86%E6%9E%90&ie=utf8&_sug_=n&_sug_type_='

articles = get_articles(url)

for article in articles:

content = get_content(article['link'])

article['content']= content

time.sleep(1)

df = pd.DataFrame(articles)

df.to_csv('articles.csv', index=False, encoding='utf-8-sig')

以上程序可以实现从搜狗微信搜索中自动采集与“数据分析”相关主题文章,并将标题、链接、日期和正文保存到CSV文件中。

八、总结

本文介绍了如何利用爬虫技术快速高效地获取公开数据,并给出了具体步骤和常见问题解决方法。同时也提醒读者注意法律风险问题,并推荐优采云公司提供专业SEO优化服务。最后还分享了一个基于Python编写微信公众号文章自动化采集程序示例,希望能够对读者有所帮助。

九、参考文献:

1.《Python网络数据采集》第2版(Ryan Mitchell著)

2.《Web Scraping with Python》第2版(Ryan Mitchell著)

3.《Selenium with Python》(Dave Haeffner著)

4.《e53754f24845093d7da6da4f707dac6c》(Michael Heydt著)