Scrapy轻松抓取页码,快速提升爬虫效率!

优采云 发布时间: 2023-03-11 18:12在网络爬虫的世界中,数据的采集是非常重要的一环,而抓取页码则是其中至关重要的一步。本文将详细介绍如何使用Scrapy框架轻松抓取页码。

1.确定目标网站及其结构

在开始抓取页码之前,我们需要先确定目标网站及其结构。通过对目标网站进行分析,我们能够更好地理解其页面结构和数据呈现方式,从而有针对性地编写代码。

2.编写基本的Scrapy爬虫

在确定目标网站及其结构后,我们需要编写基本的Scrapy爬虫。以下是一个简单的示例:

import scrapy

class MySpider(scrapy.Spider):

name ='myspider'

start_urls =['http://www.example.com']

def parse(self, response):

#在这里处理页面内容

pass

3.获取页面总数

为了获取页面总数,我们需要先找到包含页码信息的HTML元素,并提取其中的文本信息。以下是一个示例:

def parse(self, response):

#找到包含页码信息的HTML元素

page_count_element = response.css('.page-count')

#提取页面总数

page_count = int(page_count_element.xpath('text()').extract_first())

#处理每个页面

for i in range(1, page_count +1):

url ='http://www.example.com/page/{}'.format(i)

yield scrapy.Request(url=url, callback=self.parse_page)

4.分析每个页面

在处理每个页面时,我们需要先找到包含数据的HTML元素,并提取其中的数据。以下是一个示例:

def parse_page(self, response):

#找到包含数据的HTML元素

data_elements = response.css('.data')

#提取数据

data =[]

for data_element in data_elements:

item ={

'title': data_element.css('.title::text').extract_first(),

'content': data_element.css('.content::text').extract_first(),

'date': data_element.css('.date::text').extract_first(),

}

data.append(item)

#在这里处理数据

5.存储数据

最后,我们需要将抓取到的数据存储起来。可以使用各种不同类型的存储方式,如数据库、文件等。以下是一个示例:

def process_item(self, item, spider):

#存储数据到数据库或文件中

pass

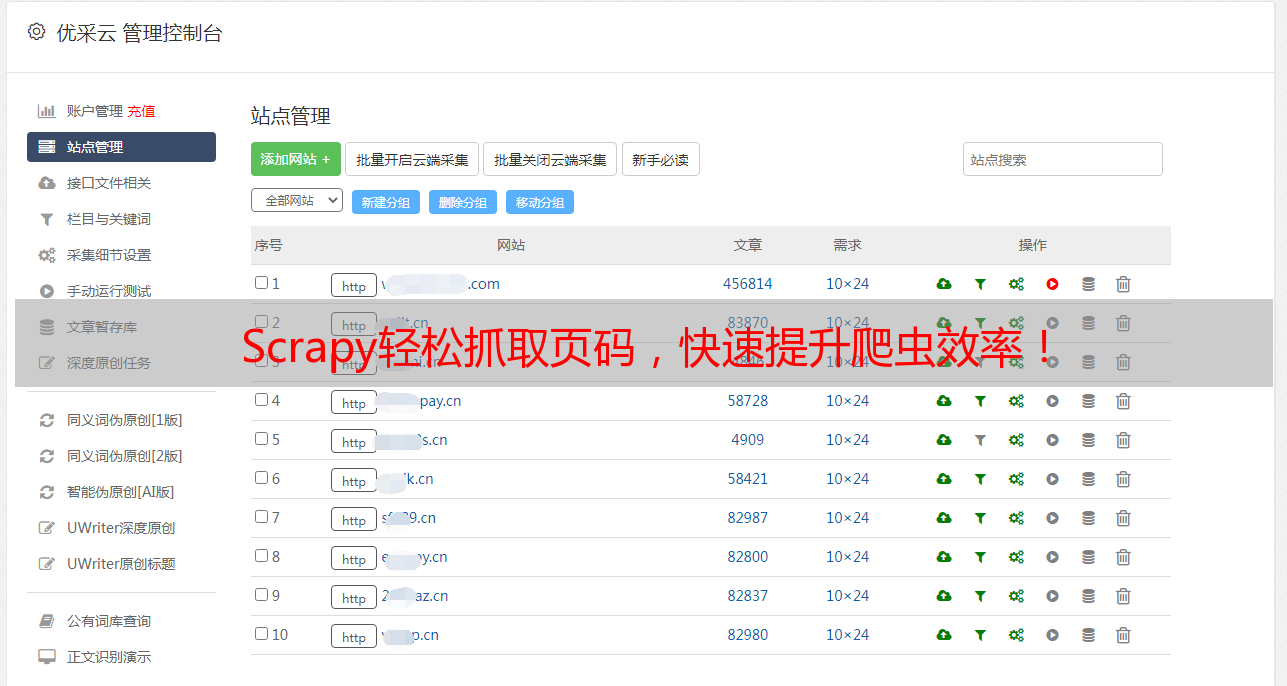

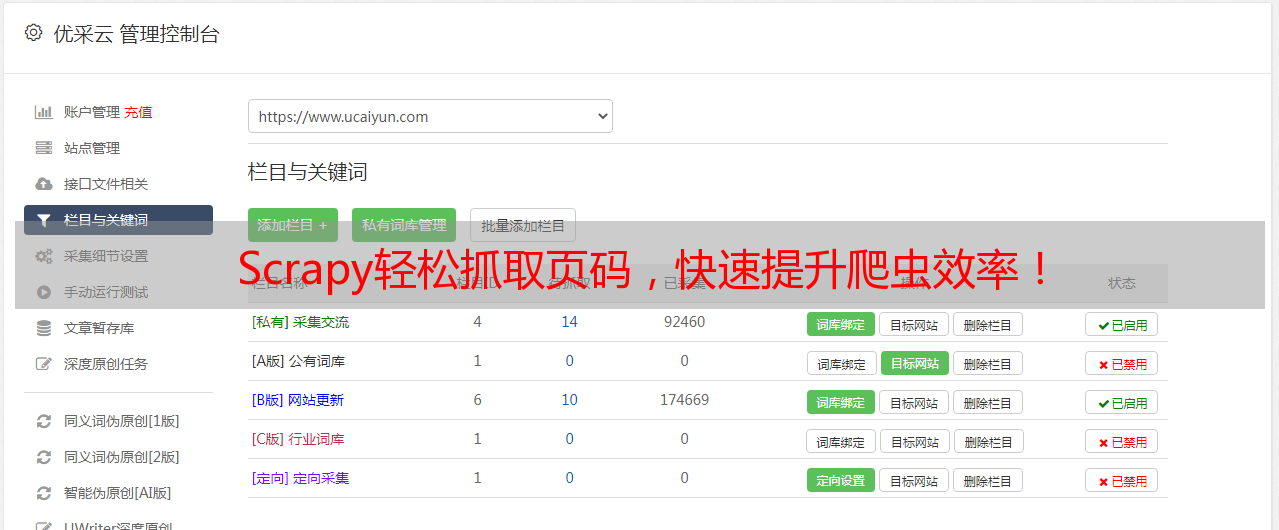

通过以上步骤,您可以轻松地使用Scrapy框架抓取页码,并获取所需的数据。如果您想更深入地了解如何使用Scrapy进行高效率和高质量的网络爬虫编写,请访问优采云(www.ucaiyun.com)了解更多信息。优采云提供专业的网络爬虫服务和SEO优化方案,为您带来更好的用户体验和更高效率的业务增长。