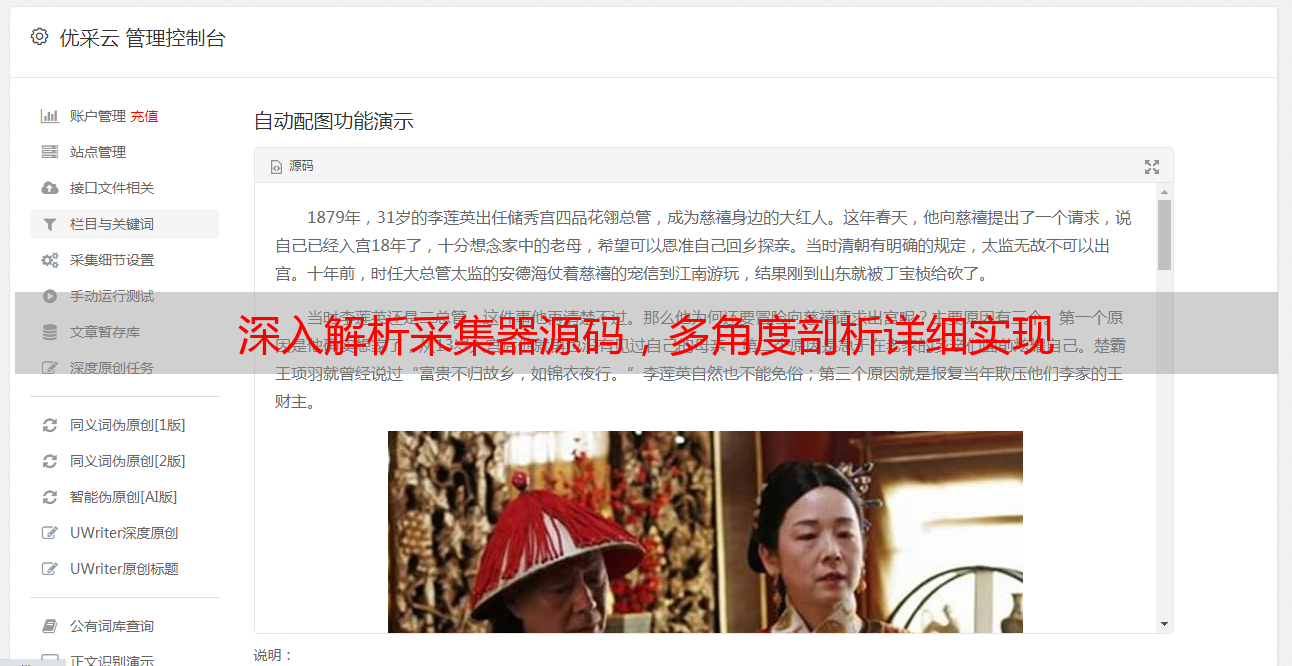

深入解析采集器源码,多角度剖析详细实现

优采云 发布时间: 2023-03-11 15:18在信息时代,数据采集是一项极其重要的工作,因为只有获取到足够的数据,才能进行更深入的分析和研究。在数据采集领域,采集器源码是一个备受关注的话题,因为它直接决定了一个采集器的性能和稳定性。本文将从多个角度对采集器源码进行详细分析,帮助读者更好地理解和应用这一技术。

一、前置知识:HTTP协议与网络爬虫

在深入了解采集器源码之前,我们需要先掌握一些基础知识。首先是HTTP协议,它是互联网上应用最广泛的协议之一,负责客户端和服务器之间的通信。而网络爬虫则是利用HTTP协议来获取网页内容并进行处理的程序。网络爬虫可以按照一定规则遍历整个互联网,并将获取到的数据存储在本地或远程服务器上。

二、采集器源码设计思路

1.抓取引擎

抓取引擎是采集器中最核心的部分,它负责实现HTTP请求、响应解析、页面解析等功能。一个好的抓取引擎需要具备高效、稳定、灵活等特点。其中高效性是最为重要的因素之一,因为数据量巨大,在有限时间内完成任务至关重要。

2.数据存储

数据存储也是一个非常重要的环节。对于大型网站而言,每天会生成海量数据,如果没有一个合理的存储方案,就会导致数据丢失或无法快速检索。因此,在设计采集器源码时需要考虑到如何实现高效可靠地数据存储。

3.任务调度

任务调度是指如何管理和调度采集任务。对于复杂网站而言,需要针对不同页面设置不同的处理方式,并且需要考虑到多线程并发访问等问题。因此,在设计任务调度时需要充分考虑这些问题,并制定相应策略。

三、采集器源码实现细节

1. HTTP请求与响应

在实现HTTP请求时需要注意以下几点:

-使用连接池来提高请求效率;

-对请求头进行优化,包括User-Agent、Referer、Cookie等;

-合理设置请求超时时间。

而对于响应处理,则需要注意以下几点:

-判断响应状态码是否正常;

-对响应内容进行解压缩处理;

-判断页面编码并进行转换。

2.页面解析与内容提取

页面解析是指将HTML页面转换成DOM树结构,并提取其中所需内容。通常情况下我们可以使用正则表达式或XPath语法来实现页面解析与内容提取。但随着互联网技术不断发展和升级,这些方法已经不能满足需求了。因此,在设计页面解析算法时需要考虑到如何兼顾灵活性和效率。

3.多线程并发访问

多线程并发访问是提高采集效率的关键所在。但同时也面临着很多问题,比如线程安全、资源竞争等等。在设计多线程并发访问时需要注意以下几点:

-使用线程池来控制线程数量;

-使用锁机制来保证线程安全;

-合理使用缓存机制来减少资源竞争。

四、优化采集器性能

1.优化HTTP请求与响应

在优化HTTP请求与响应时可以从以下几个方面入手:

-使用长连接来减少连接建立时间;

-对请求头进行优化;

-合理设置超时时间;

-开启GZIP压缩功能。

2.优化页面解析与内容提取

在优化页面解析与内容提取时可以从以下几个方面入手:

-尽量避免使用正则表达式;

-尽量使用XPath语法;

-避免使用递归算法。

3.优化多线程并发访问

在优化多线程并发访问时可以从以下几个方面入手:

-使用线程池来控制线程数量;

-合理使用缓存机制;

-避免过度竞争资源。

五、常见问题及解决方案

1. IP被封禁问题

当我们频繁地对某网站进行访问时,可能会遭到该网站封禁IP地址的情况。这时我们可以通过以下几种方式来规避这个问题:

-使用代理IP地址;

-降低访问频率;

-修改User-Agent等请求头信息。

2.页面反爬机制问题

为了防止被爬虫程序攻击,很多网站都会设置反爬机制。这种情况下我们可以通过以下几种方式来规避这个问题:

-修改User-Agent等请求头信息;

-使用动态IP地址或代理IP地址;

-使用验证码识别技术。

六、案例分析:京东商品价格监控系统

以下代码块展示了一个简单的京东商品价格监控系统实现过程:

import requests

from bs4 import BeautifulSoup

import time

import smtplib

from email.mime.text import MIMEText

from email.header import Header

def get_jd_price(url):

try:

headers ={

'User-Agent':'Mozilla/5.0(Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'}

r = requests.get(url, headers=headers)

soup = BeautifulSoup(r.text,'lxml')

price = soup.find('span', class_='price J-'+str(sku_id)).text.strip()

return price

except:

return None

def send_email(price,url):

mail_host ="smtp.qq.com"

mail_user ="xxxxx@qq.com"

mail_pass ="xxxxxxxxxxxxx"

sender ='xxxxx@qq.com'

receivers =['xxxxx@qq.com']

message = MIMEText('当前价格为:'+price+'元\n购买链接:'+url,'plain','utf8')

message['From']= Header("Price Monitor",'utf8')

message['To']= Header("Me",'utf8')

subject ='商品价格降低啦!'

message['Subject']= Header(subject,'utf8')a915f55f1fab5379b14cc9f8d7abe537:

smtpObj = smtplib.SMTP_SSL(mail_host, 465)

smtpObj.login(mail_user, mail_pass)

smtpObj.sendmail(sender, receivers, message.as_string())

smtpObj.quit()

print('邮件发送成功')

except smtplib.SMTPException as e:

print('邮件发送失败')

sku_id='100000287274'

url='https://item.jd.com/'+sku_id+'.html'

target_price=1000

while True:

price=get_jd_price(url)

if price==None:

print('无法获取价格')

time.sleep(60)

continue

if float(price)<=target_price:

send_email(price,url)

time.sleep(60)

以上代码实现了京东商品价格监控功能,并且当价格低于目标价格时会自动发送邮件通知用户购买。

七、SEO优化策略

1.关键词优化

关键词优化是SEO中最为基础也最为重要的部分之一。在设计相关文档和文章时需要合理地使用关键词,并遵循Google SEO指南中关于关键词密度和布局等相关规定。

2.内容质量优化

内容质量也是SEO中非常重要的部分之一。只有内容质量高才能获得用户认可和搜索引擎排名靠前。因此,在撰写文章时需要注重内容质量,并尽可能做到专业权威和独特创新。

3.外链策略优化

外链策略也是SEO中非常关键的部分之一。外链数量和质量直接影响排名结果,在选择外链平台和建立外链链接时需要合理选择,并且不断积累外链资源以提高排名效果。

八、未来趋势预测:AI自动化采集技术成为主流趋势

随着人工智能技术不断发展和普及,AI自动化采集技术已经逐渐成为未来发展趋势之一。它能够自动识别目标网站结构和相应规则,并根据设定参数自动完成所有操作,无需人工干预。未来将有更多企业开始投资AI自动化采集技术,在大数据领域走向更加智能化。

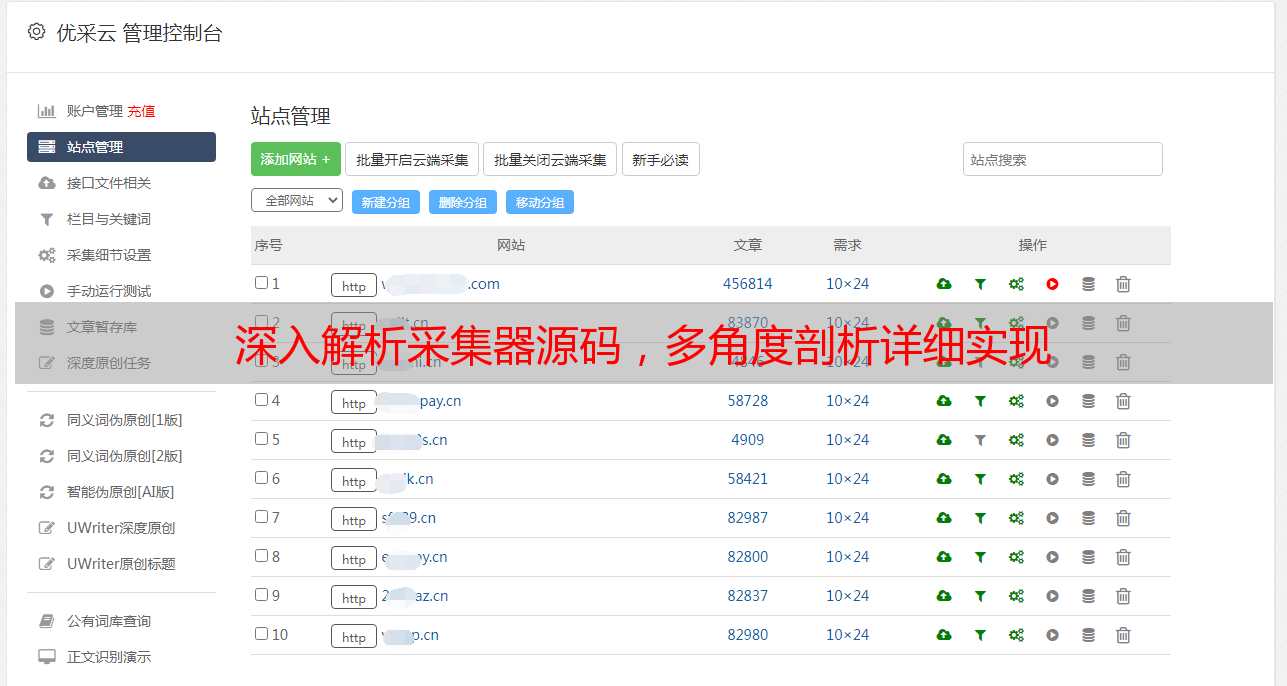

九、总结与建议:选择专业平台享受更好服务体验

本文从多个角度详细介绍了采集器源码设计思路、实现细节以及常见问题及解决方案等相关内容,并预测了未来趋势走向。对于想要进入数据采集领域或者想要提高自身技能水平者而言,本文具有一定参考价值。同时,在选择相关服务平台或供应商时建议选择专业平台(如优采云),以获得更好更专业地服务体验。www.ucaiyun.