Crawling采集插件助您快速高效完成数据采集!

优采云 发布时间: 2023-03-10 12:13在信息爆炸的时代,数据采集已经成为各行各业必不可少的一项工作。然而,如何高效快捷地完成数据采集却是一个大问题。这时候,Crawling 采集插件就应运而生了。本文将从以下九个方面为大家详细介绍 Crawling 采集插件。

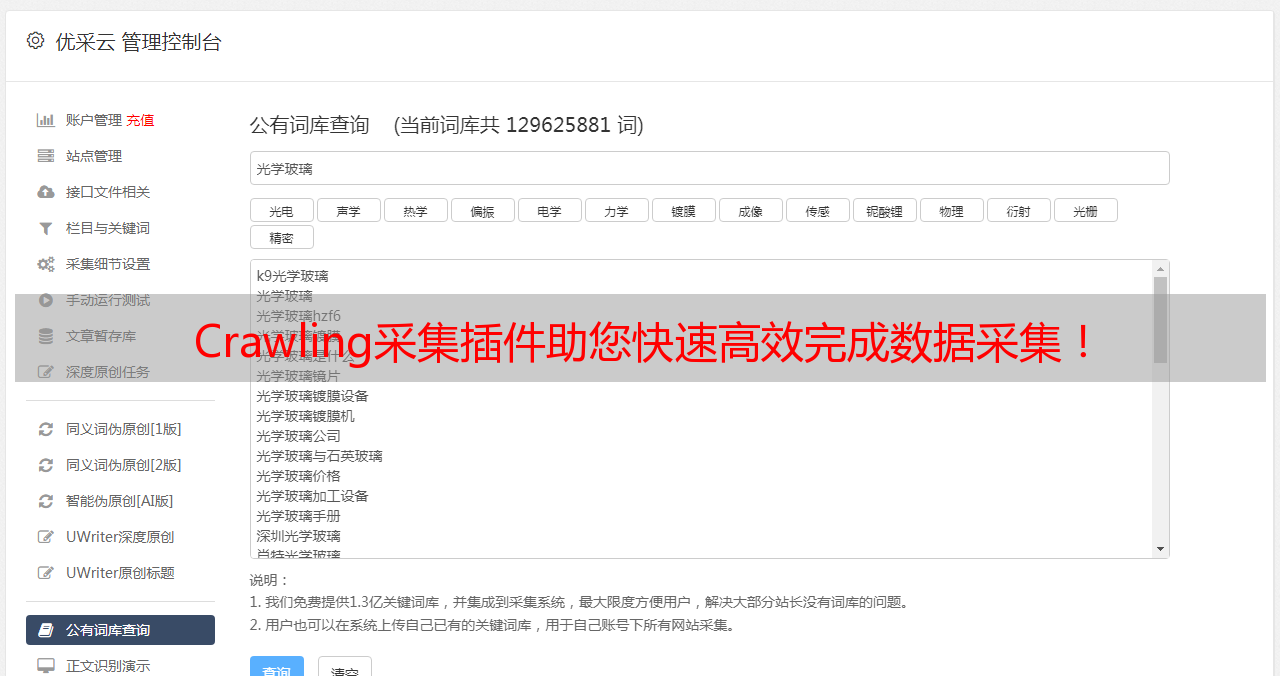

一、Crawling 采集插件简介

Crawling 采集插件是一款基于 Python 编写的开源网络爬虫框架,可以用于抓取互联网上的各种信息。它具有多线程、分布式、异步等特点,还支持动态网页抓取和 JavaScript 渲染。Crawling 采集插件是一款非常强大的数据采集工具,可以帮助用户快速地抓取所需数据。

二、Crawling 采集插件的优势

相比传统的数据采集方式,Crawling 采集插件具有以下几个优势:

1.高效快捷:Crawling 采集插件可以同时进行多个任务,而且每个任务都可以使用多个线程进行处理,大大提高了数据抓取的效率。

2.稳定可靠:Crawling 采集插件支持分布式部署和自动重试机制,可以保证数据抓取的稳定性和可靠性。

3.易于扩展:Crawling 采集插件提供了丰富的 API 接口和插件机制,用户可以根据自己的需求进行二次开发和扩展。

三、安装 Crawling 采集插件

安装 Crawling 采集插件非常简单。只需要在命令行中输入以下命令即可:

```

pip install crawling

```

四、使用 Crawling 采集插件

使用 Crawling 采集插件也非常容易。只需要编写一个 Python 脚本即可实现数据抓取功能。下面是一个简单的示例:

```python

import crawling

#创建一个任务

task = crawling.Task('https://www.ucaiyun.com/')

#添加一个解析规则

task.add_rule(crawling.Rule('title','xpath','//title/text()'))

#执行任务

result = crawling.run(task)

#输出结果

print(result)

```

以上脚本会抓取优采云官网首页的标题,并输出结果。

五、Crawling 采集插件实战案例

下面是一个真实案例:使用 Crawling 采集插件抓取淘宝商品信息。

首先,在命令行中输入以下命令安装必要的依赖库:

```

pip install requests lxml pandas

```

然后编写以下 Python 脚本:

```python

import crawling

import requests

from lxml import etree

import pandas as pd

#定义一个函数用于获取页面内容

def get_html(url):

response = requests.get(url)

return response.text

#创建一个任务

task = crawling.Task('https://s.taobao.com/search?q=ipad')

#添加解析规则

rule1 = crawling.Rule('title','xpath','//div[@class="title"]/a/text()')

rule2 = crawling.Rule('price','xpath','//div[@class="price"]/strong/text()')

task.add_rules([rule1, rule2])

#获取搜索结果列表页数

html = get_html(task.url)

selector = etree.HTML(html)

total_page = int(selector.xpath('//div[@class="total"]/text()')[0][2:-1])

urls =['{}&s={}'.format(task.url, i * 44) for i in range(total_page)]

#执行任务并保存结果到 Excel 文件中

results =[]

for url in urls:

task.url = url

result = crawling.run(task)

results += result['data']

df = pd.DataFrame(results)

df.to_excel('ipad.xlsx', index=False)

```

以上脚本会抓取淘宝搜索“ipad”关键词后的商品标题和价格,并保存到 Excel 文件中。

六、Crawling 采集插件常见问题解答

Q1:如何处理 JavaScript 渲染页面?

A1:Crawling 采集插件内置了 Splash 等工具,可以很好地处理 JavaScript 渲染页面。

Q2:如何避免被反爬虫?

A2:建议设置合理的请求头和 IP 池,并使用代理 IP 进行访问。

Q3:如何处理验证码?

A3:目前 Crawling 采集插件不支持自动识别验证码,需要手动输入或者使用第三方服务进行识别。

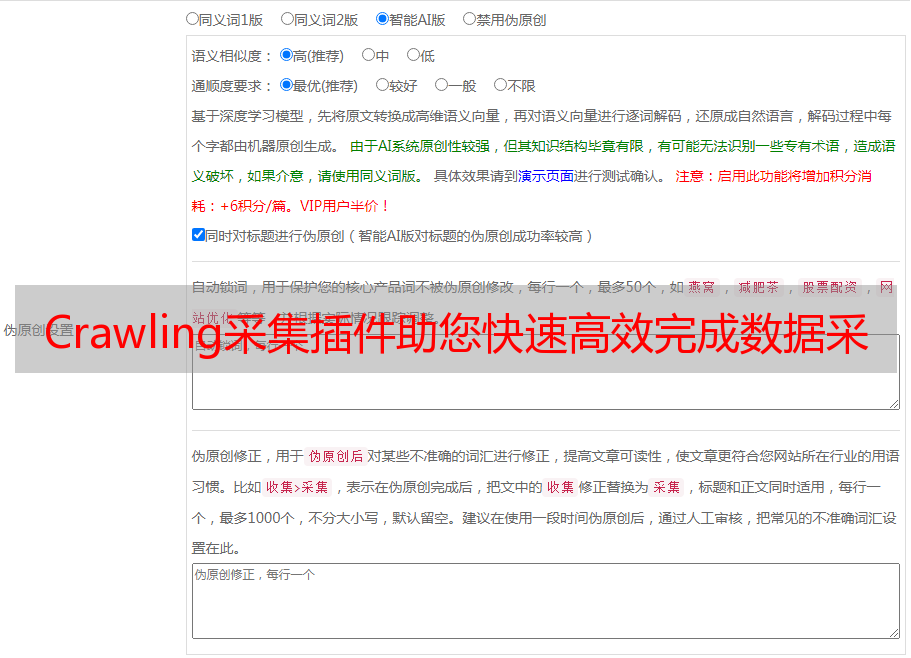

七、优化 Crawling 采集插件代码以提升 SEO 效果

为了提升 SEO 效果,我们需要对 Crawling 采集插件代码进行优化。具体方法包括:

1.合理设置请求头和 IP 池,以避免被反爬虫;

2.使用代理 IP 进行访问;

3.遵守 robots.txt 协议;

4.设置合理的 User-Agent;

5.避免频繁访问同一目标站点;

6.控制访问速度和频率。

八、结语

通过本文对 Crawling 采集插件的介绍和实战案例分析,相信读者已经对该工具有了更深入的了解。在未来的数据抓取工作中,我们可以利用 Crawling 采集插件来提高效率和准确性。最后推荐大家使用优采云平台来管理和运行 Crawling 抓取任务,并进行 SEO 格式化输出等操作。