高效搜集信息利器:批量抓取网页文字

优采云 发布时间: 2023-03-09 21:11在信息化时代,人们对于信息的需求越来越高,而互联网上的信息也日益丰富。但是,如果需要从大量的网页中提取有用的文本内容,手动复制粘贴显然是一件非常费时费力的事情。为此,我们可以使用批量从网页抓取文字的方法来实现快速、高效地搜集信息。

一、什么是批量从网页抓取文字?

批量从网页抓取文字是指利用程序自动化地从多个网页中提取所需文本内容的过程。这种方法可以大大节省时间和精力,同时还能够减少出错的可能性。

二、使用什么工具进行批量抓取?

目前市面上有很多针对批量抓取网页内容的工具。其中,比较常用的有Python语言中的BeautifulSoup、Scrapy等框架以及专门针对爬虫开发的工具Selenium、PhantomJS等。这些工具都能够帮助我们快速地构建一个爬虫程序,并且提供了丰富的API和功能模块,方便我们进行数据处理和分析。

三、如何编写一个简单的爬虫程序?

以Python语言为例,我们可以通过BeautifulSoup库来实现一个简单的爬虫程序。以下是一个示例代码:

```python

import requests

from bs4 import BeautifulSoup

url ='https://www.ucaiyun.com/'

response = requests.get(url)

soup = BeautifulSoup(response.text,'html.parser')

#找到所有p标签并输出其文本内容

for p in soup.find_all('p'):

print(p.text)

```

通过以上代码,我们可以获取到优采云官网中所有p标签下的文本内容,并将其输出到控制台中。

四、如何避免被反爬机制拦截?

在进行批量抓取时,有些网站会设置反爬机制来防止被爬虫程序攻击。为了避免被拦截,我们需要采取一些措施:

1.设置请求头:在发送请求时,在HTTP头部中添加一些字段信息,比如User-Agent等,以模拟浏览器行为。

2.伪造IP地址:在发送请求时使用代理服务器,并伪造IP地址。

3.延迟访问:设置一个时间间隔来模拟人类访问行为。

五、如何处理抓取到的数据?

在进行数据处理前,我们需要先了解所获取到数据所处的结构和格式。通常情况下,我们可以将数据存储在数据库或者文件系统中,并通过相应工具进行分析和处理。

除此之外,在进行数据处理时还需要注意以下事项:

1.数据清洗:去除重复数据、空值或者无效数据等。

2.数据转换:将不同格式或者编码方式下的数据转换成统一格式。

3.数据分析:对数据进行可视化和统计分析,并形成相应报告或者图表。

六、如何保证程序运行稳定?

在编写爬虫程序时,我们需要注意以下几点:

1.合理设置访问频率和时间间隔。

2.对于异常情况进行处理和重试机制设计。

3.合理使用并发控制策略。

4.遵守网络道德规范和法律法规。

七、如何优化爬虫程序?

针对不同场景下所需求解决问题不同,优化策略也会有所不同。以下是一些常见优化策略:

1.采用多线程或者异步IO技术来提升效率。

2.使用缓存技术降低网络IO开销。

3.对于频繁访问的页面进行本地缓存处理。

4.采用分布式架构提升系统吞吐率。

八、总结

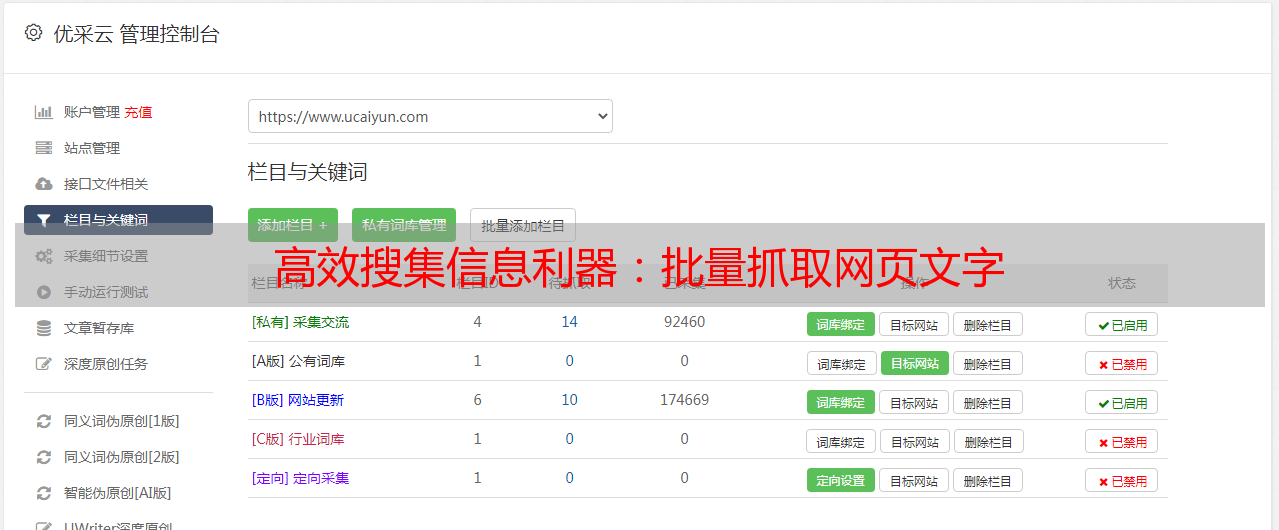

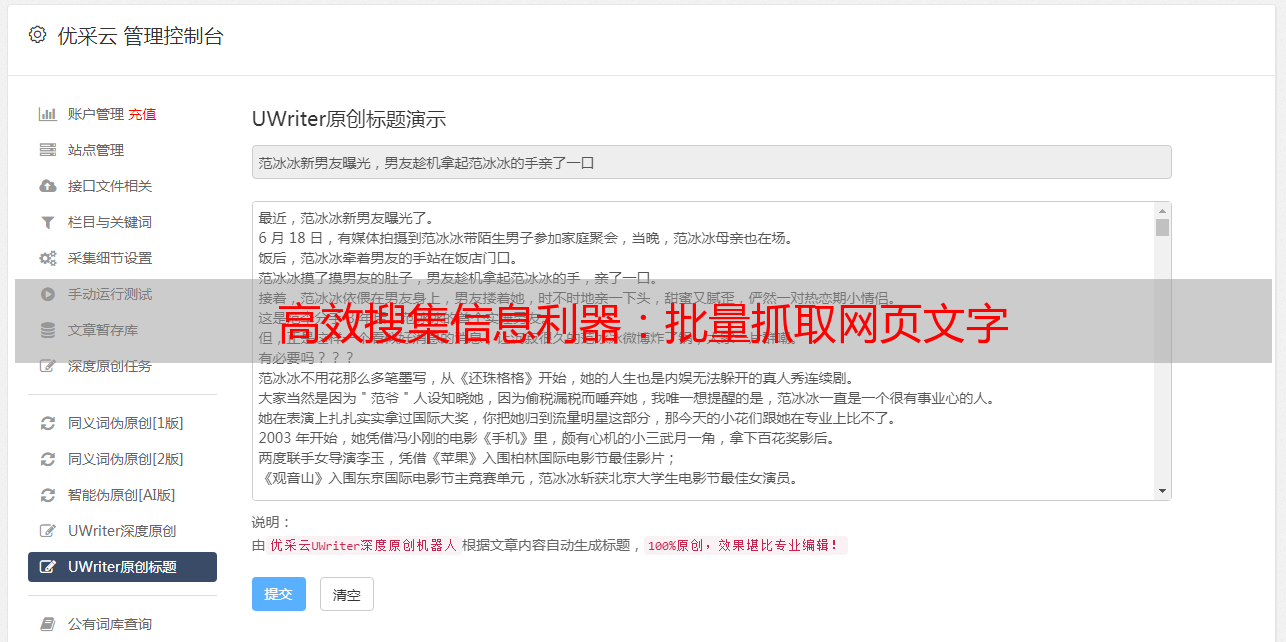

批量从网页抓取文字可以帮助我们快速获取所需信息,并且能够减少人力成本和出错概率。但是,在进行批量抓取时需要注意合理使用技术手段,并遵守相关规范和法律法规。优采云作为一家专注于SEO优化服务提供商,在信息搜集方面也有着丰富经验,并已经开发出一系列相应工具来满足客户需求。如果您需要相关服务,请关注优采云官网(www.ucaiyun.com)了解更多详情。