PHP自动采集网页内容,让程序高效运行!

优采云 发布时间: 2023-03-08 00:10PHP自动采集网页内容是现代网站开发中非常重要的一环。它可以帮助你自动采集其他网站的内容,并将这些内容展示在你的网站上。这样,你就可以让你的网站保持不断更新,吸引更多的访问者。

下面,我们就来详细地介绍一下PHP自动采集网页内容的相关知识。

1、什么是PHP自动采集网页内容?

PHP自动采集网页内容是指利用PHP编程语言编写程序,从其他网站中自动获取数据,并将这些数据存储到数据库中或展示在自己的网站上。通俗地说,它就是可以帮助你把其他网站的文章、图片、视频等信息搬到自己的网站上。

2、为什么需要PHP自动采集网页内容?

在如今这个信息爆炸的时代,每天都会有大量新闻、文章、视频等信息产生。如果你想让你的网站保持不断更新,吸引更多的访问者,那么你就需要来回切换各种资讯来源进行查找并手工复制粘贴。而这种方式非常费时费力,并且效率极低。此时,PHP自动采集网页内容就成了一个非常好的解决方案。

3、PHP自动采集网页内容有哪些常见应用场景?

(1)新闻聚合类网站

新闻聚合类网站需要从各大主流新闻门户中获取最新、最热门的新闻资讯,并通过分类、排序等方式展示给用户。

(2)商品价格比较类网站

商品价格比较类网站需要从各大电商平台中获取商品价格、促销信息等,并展示给用户以便于用户选择购买。

(3)论坛类网站

论坛类网站需要从其他论坛中获取最新发布的话题、回帖等信息,并展示给用户以便于用户参与讨论。

4、如何实现PHP自动采集网页内容?

(1)通过curl库获取页面HTML源码

curl库是一个非常强大的网络传输库,可以模拟浏览器发送HTTP请求并获取响应。通过curl库我们可以轻松地获取其他页面HTML源码。

(2)通过正则表达式解析HTML源码

在获取到HTML源码之后,我们需要对其进行解析以提取出我们需要的数据。正则表达式是一种非常强大的字符串匹配工具,在解析HTML源码时也非常实用。

(3)通过XPath解析HTML源码

XPath是一种XML路径语言,在解析HTML源码时也非常实用。它可以帮助我们快速定位到目标节点并提取出所需数据。

5、如何避免被搜索引擎惩罚?

虽然PHP自动采集网页内容对于我们来说很方便,但是对于搜索引擎来说却可能会被视为抄袭行为而受到惩罚。因此,在使用PHP自动采集时我们需要注意以下几点:

(1)遵循Robots协议

Robots协议是网络爬虫遵循的规范,在使用PHP自动采集时也需要遵循该规范以避免被搜索引擎惩罚。

(2)设置合理的爬虫频率

爬虫频率过高会给目标服务器带来很大压力,因此我们需要设置合理的爬虫频率以避免被目标服务器拒绝连接。

(3)添加原文链接和来源信息

在展示其他页面数据时,我们需要添加原文链接和来源信息以表明数据来源,并避免被搜索引擎视为抄袭行为而受到惩罚。

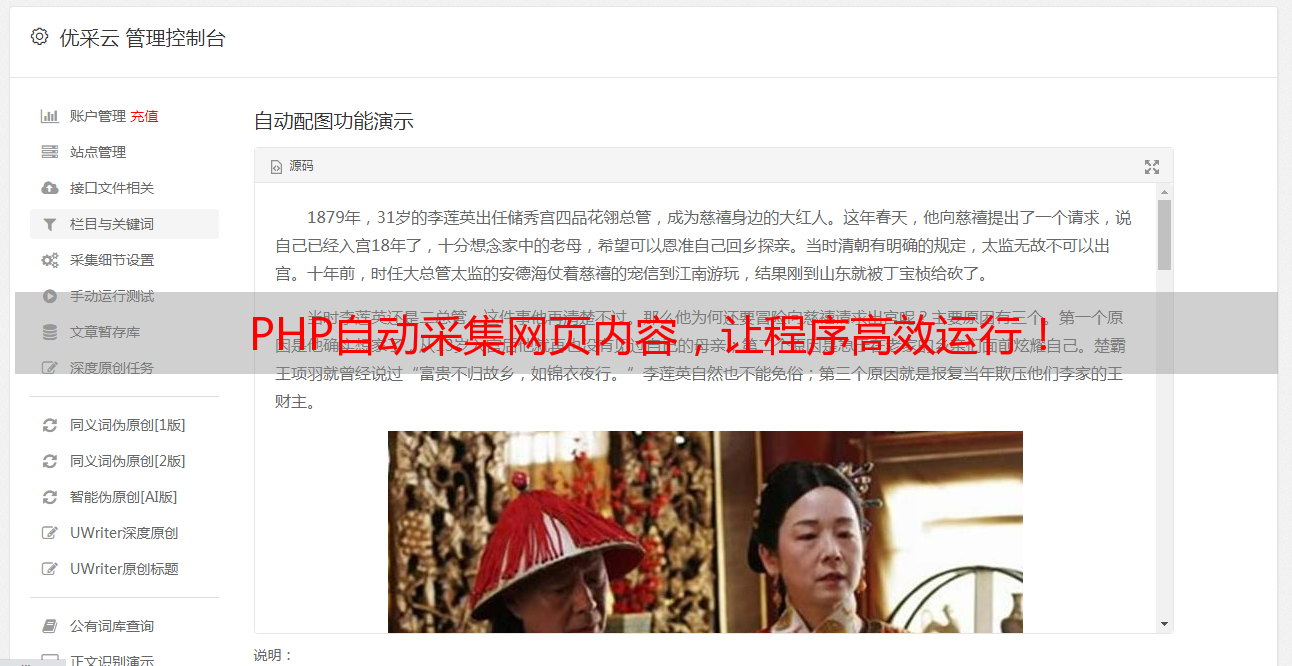

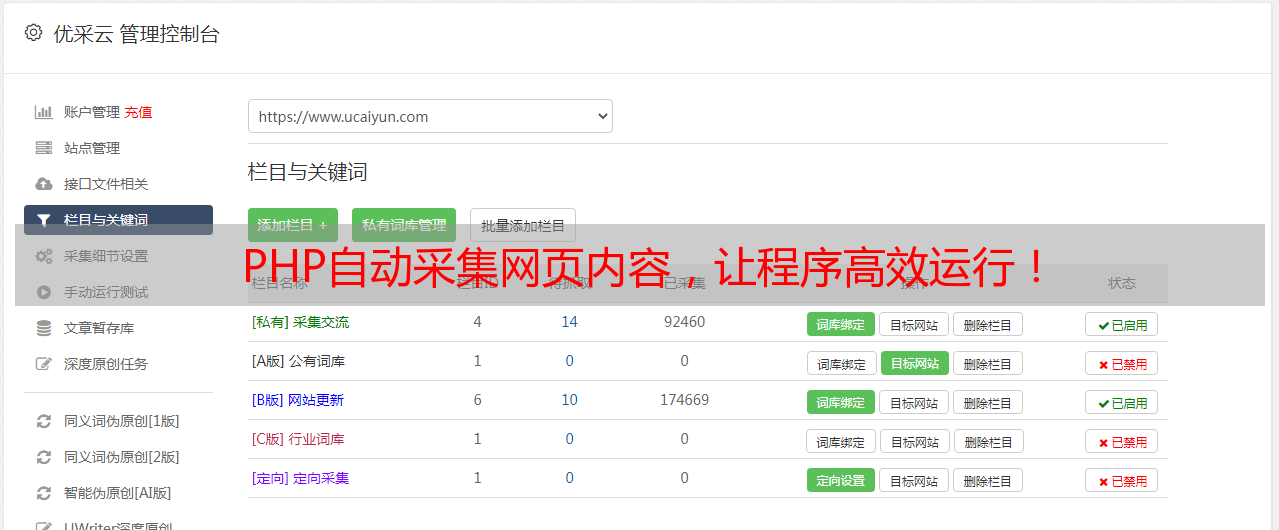

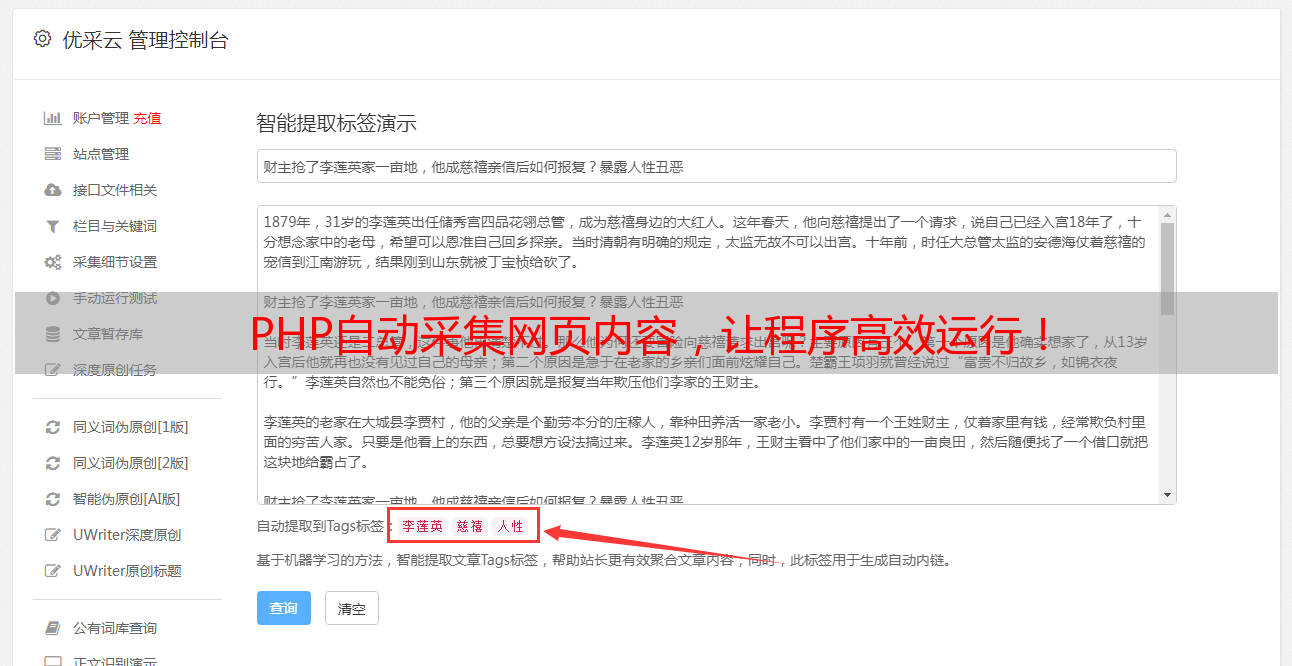

6、优采云——专业SEO优化服务提供商

优采云是国内领先的SEO优化服务提供商之一,拥有多年丰富经验和专业技术团队,为广大企业和个人提供高品质的SEO优化服务。如果您有任何关于SEO优化方面的需求,请登录www.ucaiyun.com了解更多详情。

7、结语

通过上述分析我们可以看出,PHP自动采集网页内容是一项非常实用且必要的技术,在现代互联网开发中得到了广泛应用。但同时也需要注意一些技术细节和法律法规问题。因此,在使用该技术时,请务必谨慎处理并遵守相关规定。