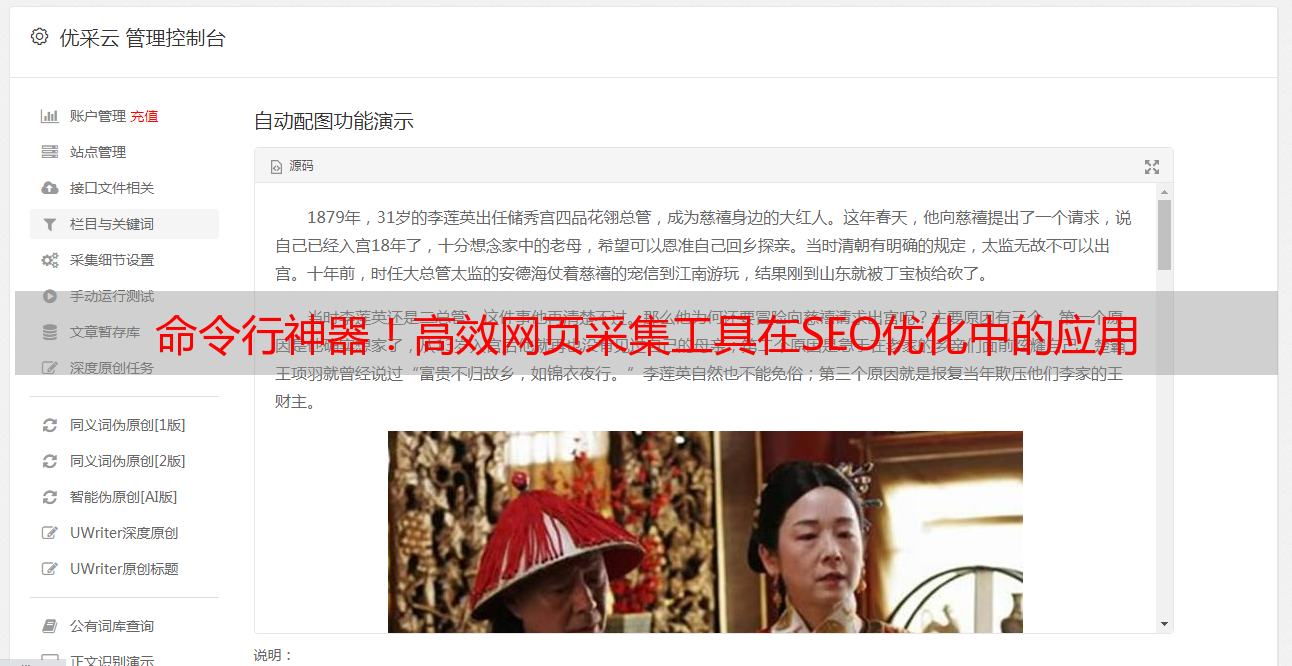

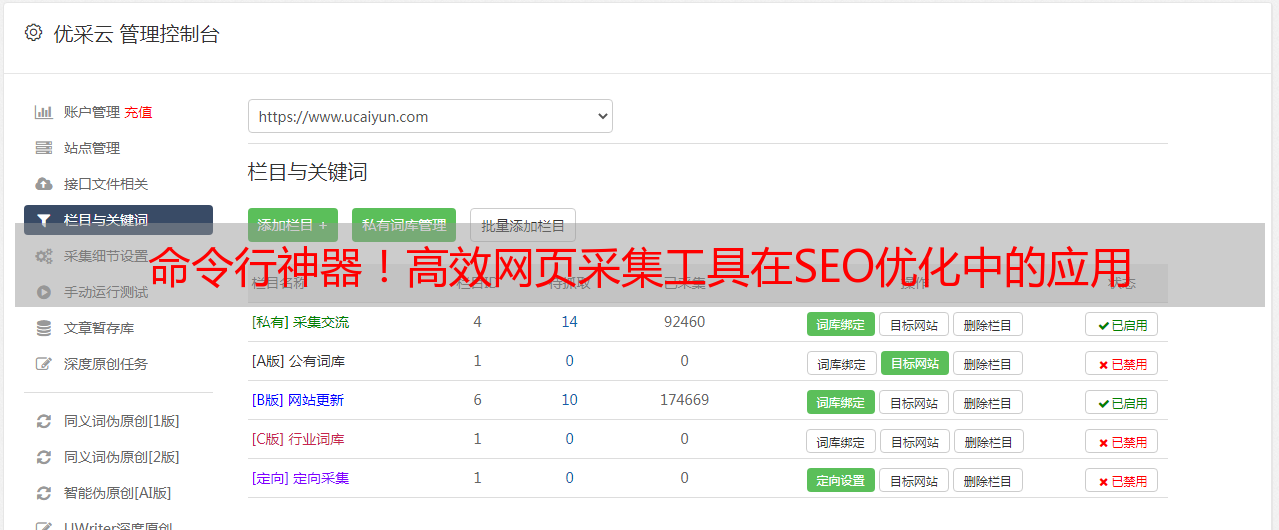

命令行神器!高效网页采集工具在SEO优化中的应用

优采云 发布时间: 2023-03-07 18:11随着互联网的快速发展,SEO优化已成为网络营销中至关重要的一环。而在SEO中,网页采集是不可或缺的一部分。今天,我们将介绍一种高效的网页采集工具——命令行网页采集,并探讨其在SEO优化中的应用。

一、什么是命令行网页采集?

命令行网页采集是一种使用命令行界面进行操作的网络爬虫工具。它可以自动化地从互联网上抓取数据,并将其转换为结构化数据以供分析使用。相比于其他爬虫工具,命令行网页采集更加灵活、高效。

二、为何选择命令行网页采集?

1.高效性

由于命令行界面不需要进行图形化处理,因此它可以更快地运行和处理大量数据,从而提高了工作效率。

2.灵活性

命令行界面提供了更多的参数选项和自定义功能,用户可以根据自己的需求进行设置和调整,从而实现更加灵活的数据抓取和处理。

3.安全性

由于命令行界面不需要与浏览器进行交互,因此它可以避免被反爬虫机制检测到,并提高了数据抓取的安全性。

三、如何使用命令行网页采集?

1.安装命令行网页采集工具

目前市场上有很多优秀的命令行网页采集工具可供选择,其中比较常用的有wget、curl等。这里我们以wget为例进行介绍。

安装wget:

sudo apt-get install wget

2.使用wget进行网页采集

使用wget下载单个文件:

wget

使用wget递归下载整个目录:

wget -r-np -k[URL]

其中-r表示递归下载,-np表示不跟随链接到父目录,-k表示将链接转换为本地链接以供离线浏览。

3.对数据进行清洗和分析

下载完数据后,我们需要对其进行清洗和分析。这里我们可以使用Python等编程语言来实现。

四、如何将命令行网页采集应用于SEO优化?

1.获取竞品信息

通过对竞品网站进行数据抓取和分析,我们可以了解其[url=https://www.ucaiyun.com/caiji/public_dict/]关键词排名、流量来源、内容质量等信息,并据此制定合理的SEO策略。

2.分析用户搜索意图

通过对用户搜索关键词进行数据抓取和分析,我们可以了解其搜索意图,并据此优化页面内容和排名策略。

3.监控搜索引擎算法更新

通过对搜索引擎算法更新进行数据抓取和分析,我们可以及时了解其变化并据此调整优化策略,从而保持排名稳定性。

五、命令行网页采集存在哪些问题?

1.难度较大

由于需要熟练掌握Linux系统和编程语言等知识,因此对于非专业人士来说可能存在一定难度。

2.反爬虫机制限制

由于某些目标站点可能会设置反爬虫机制限制,因此可能会导致数据抓取困难或者失败。

六、结语

通过本文的介绍,相信大家已经对命令行网页采集有了更深入的了解,并掌握了如何将其应用于SEO优化中。作为一款高效灵活的网络爬虫工具,它能够帮助我们更好地获取并利用数据资源。如果您想要进一步了解相关内容,请访问优采云(www.ucaiyun.com),获取更多有关SEO优化的资讯和服务。