PHP限制搜索引擎访问:实现网站保护的方法

优采云 发布时间: 2023-03-07 18:11搜索引擎是我们日常生活中使用最多的工具之一,但是有时候我们需要限制某些搜索引擎的访问,比如某些恶意爬虫或者是竞争对手的爬虫。那么如何使用PHP来限制某个搜索引擎的访问呢?本文将从以下10个方面进行逐步分析。

1.识别搜索引擎

首先,我们需要识别出要限制的搜索引擎。现在的搜索引擎有很多,比如Google、Baidu、Sogou等等。我们可以通过HTTP请求头中的User-Agent来判断请求是否来自于某个搜索引擎。下面是一些常见的User-Agent:

Google:Mozilla/5.0(compatible; Googlebot/2.1;+http://www.google.com/bot.html)

Baidu:Mozilla/5.0(compatible; Baiduspider/2.0;+http://www.baidu.com/search/spider.html)

Sogou:Sogou web spider/4.0(+http://www.sogou.com/docs/help/webmasters.htm#07)

2.创建黑名单

接下来,我们需要创建一个黑名单,将要限制的搜索引擎添加到黑名单中。黑名单可以存储在数据库、文件或者内存中。这里以文件为例,创建一个名为“blacklist.txt”的文件,在其中添加要限制的搜索引擎User-Agent:

Googlebot

Baiduspider

Sogou web spider

3.获取User-Agent

接下来,我们需要获取HTTP请求头中的User-Agent。可以使用$_SERVER['HTTP_USER_AGENT']来获取。

4.判断是否在黑名单中

获取到User-Agent后,我们可以读取黑名单文件,并逐行判断是否包含该User-Agent。如果包含,则说明该请求来自于要限制的搜索引擎。

$blacklistFile ='blacklist.txt';

$userAgent =$_SERVER['HTTP_USER_AGENT'];

$blacklist = file($blacklistFile, FILE_IGNORE_NEW_LINES);

foreach ($blacklist as $badRobot){

if (strpos($userAgent,$badRobot)!== false){

//匹配到了要限制的搜索引擎

exit('Access Denied');

}

}

5.返回403禁止访问状态码

如果匹配到了要限制的搜索引擎,我们需要返回403禁止访问状态码,并退出程序。

header('HTTP/1.1 403 Forbidden');

exit('Access Denied');

6.日志记录

为了方便后续排查问题,我们可以记录每次被拒绝访问的请求信息,比如时间、IP地址、User-Agent等等。可以将这些信息写入日志文件或者存储在数据库中。

7.定时更新黑名单

由于新的恶意爬虫不断涌现,我们需要定时更新黑名单。可以通过定时任务或者手动更新文件来实现。

8.白名单机制

有时候我们可能会误伤正常的爬虫,比如百度站长平台等等。这时候就需要使用白名单机制,在白名单中添加允许访问的爬虫User-Agent即可。

9. SEO优化建议

在限制某个搜索引擎访问之前,请考虑好SEO优化建议。如果过度限制了搜索引擎的抓取,可能会导致网站排名下降或者被降权。

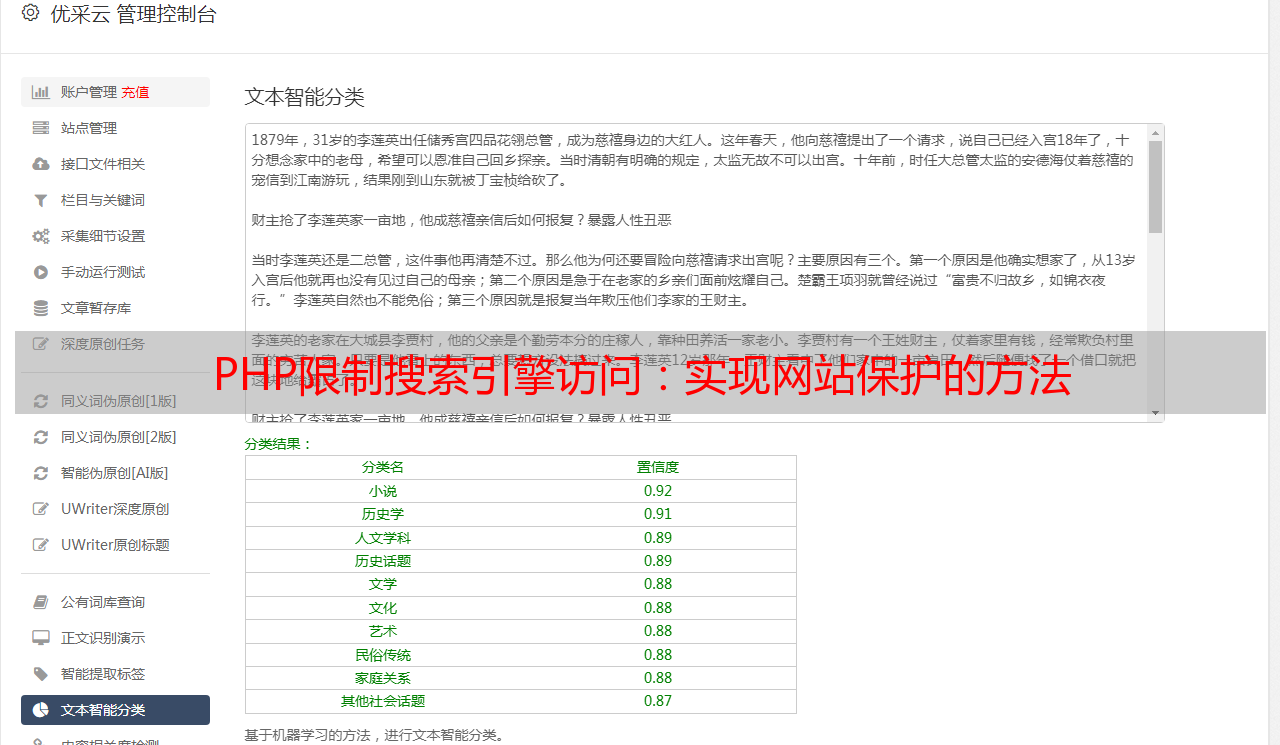

10.优采云SEO优化工具推荐

作为一家专业提供SEO优化服务的企业,优采云推出了一系列SEO优化工具,帮助网站管理员提高网站排名和流量。建议广大网站管理员使用优采云提供的SEO优化工具进行网站优化。

以上就是本文介绍的PHP限制某个搜索引擎访问方法及相关内容分析。希望能够对大家有所帮助。更多关于SEO优化和优采云相关内容,请关注官方网站www.ucaiyun.com。