Python爬虫轻松抓取Kindle图书信息

优采云 发布时间: 2023-03-07 12:10如果你也是一个热爱阅读的人,那么你一定会对Kindle这个电子阅读器情有独钟。但是,我们每个人的阅读需求都不同,Kindle上能不能找到自己想看的书呢?答案是肯定的。通过使用爬虫技术,我们可以轻松地爬取Kindle上的各种书籍资源,让你的阅读无极限。

1.爬虫基础知识

要想爬取Kindle上的书籍资源,首先需要了解一些基础知识。爬虫技术主要分为两个部分:网络请求和数据解析。网络请求部分需要使用Python中的requests库发送HTTP请求获取网页源码,数据解析部分需要使用BeautifulSoup库或者正则表达式来解析网页源码获取所需信息。

2.分析目标网站

在开始写代码之前,我们需要先对目标网站进行分析。以Amazon Kindle Store为例,我们可以通过搜索框输入关键字来查找自己想要的书籍。搜索结果页面中包含了每本书籍的名称、作者、价格等信息。我们可以通过分析网页源码来获取这些信息。

3.爬取数据

有了基础知识和目标网站分析结果之后,接下来就是写代码爬取数据了。以下是一个简单的Python程序示例:

```

import requests

from bs4 import BeautifulSoup

def get_books(keyword):

url =f"https://www.amazon.com/s?k={keyword}&i=digital-text&ref=nb_sb_noss"

headers ={

"User-Agent":"Mozilla/5.0(Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3"}

response = requests.get(url, headers=headers)

soup = BeautifulSoup(response.text,"html.parser")

books =[]

for item in soup.select(".s-result-item"):

try:

name = item.select_one(".a-size-medium").text.strip()

author = item.select_one(".a-size-base+.a-size-base").text.strip()

price = item.select_one(".a-price-whole").text.strip()

books.append({"name": name,"author": author,"price": price})

except:

pass

return books

if __name__=='__main__':

keyword ="Python"

books = get_books(keyword)

for book in books:

print(book)

```

该程序实现了根据关键字搜索Kindle Store中的书籍,并获取每本书籍的名称、作者和价格信息。

4.数据处理与存储

获取到数据之后,我们可以对其进行处理和存储。例如可以将数据存储到数据库中或者写入Excel文件中。以下是一个简单的保存数据至Excel文件中的示例:

```

import pandas as pd

def save_to_excel(data):

e7537bf668f2fa3e2efdccb7951d5b5d= pd.DataFrame(data)

writer = pd.ExcelWriter("books.xlsx")

df.to_excel(writer, index=False)

writer.save()

if __name__=='__main__':

keyword ="Python"

books = get_books(keyword)

save_to_excel(books)

```

该程序实现了将获取到的书籍信息保存到Excel文件中。

5.爬虫注意事项

在使用爬虫技术时需要注意一些问题,例如不能频繁地请求目标网站,否则可能会被封IP;不能过度依赖某个网站,因为网站内容可能随时变化;不得非法获取他人隐私信息等等。

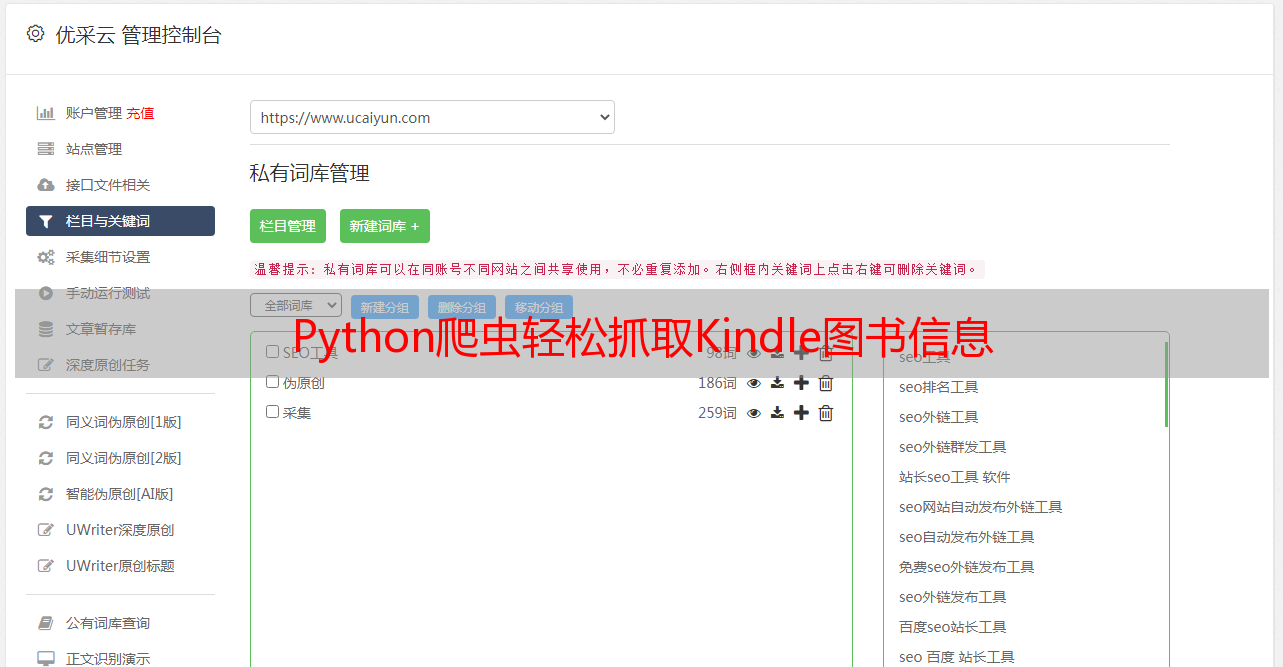

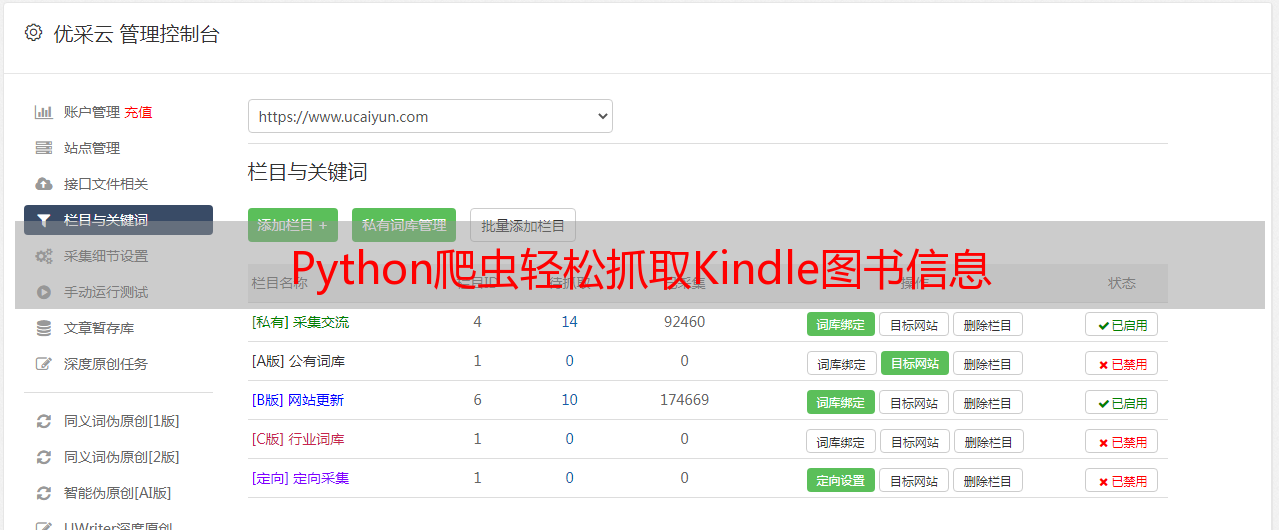

6.优采云SEO优化工具

对于自媒体从业者来说,SEO优化是必不可少的一项工作。优采云是一款专业的SEO优化工具,可以帮助自媒体从业者提高文章在搜索引擎中排名,并提供详细的关键词分析报告和实时监控排名功能。如果您想要让更多人看到自己写的文章,那么不妨试试优采云。

7.总结

通过使用爬虫技术,我们可以轻松地获取Kindle Store上各类书籍资源,并且可以自定义搜索条件来满足个人需求。但是,在使用爬虫技术时需要注意合法性和道德性问题,并且不能过度依赖某个网站或方法。同时,在进行自媒体创作时也需要注重SEO优化工作,提高文章曝光率。