采集怎样过滤对方网址?实用技巧分享!

优采云 发布时间: 2023-03-07 08:14无论是做SEO还是数据分析,采集都是必不可少的一步。但是在采集的过程中,我们常常会遇到一些对我们不友好的网站,它们会在我们采集的数据中夹杂一些广告链接或者恶意链接。那么,如何才能够在采集时过滤掉这些对我们无用的链接呢?本文将从9个方面为大家详细讲解。

1.使用正则表达式进行匹配

正则表达式是一种强大的文本处理工具,在采集时可以使用正则表达式匹配出我们需要的内容,并且可以通过正则表达式排除掉我们不需要的内容。比如,在爬取某个论坛时,我们只关心帖子内容,而对于楼主和回复内容并不感兴趣,这时候就可以通过正则表达式来过滤掉楼主和回复内容。

2.使用CSS选择器定位元素

如果你熟悉CSS,那么你可以使用CSS选择器来定位你需要的元素,并且可以通过CSS选择器来排除你不需要的元素。比如,在爬取某个网站时,我们只关心标题和正文内容,而对于广告和导航栏并不感兴趣,这时候就可以通过CSS选择器来过滤掉广告和导航栏。

3.使用XPath定位元素

XPath是一种XML路径语言,在HTML页面中也可以使用XPath来定位元素。与CSS选择器类似,XPath也可以用来定位你需要的元素,并且可以通过XPath排除你不需要的元素。比如,在爬取某个网站时,我们只关心标题和正文内容,而对于广告和导航栏并不感兴趣,这时候就可以通过XPath来过滤掉广告和导航栏。

4.使用BeautifulSoup库解析HTML页面

BeautifulSoup是一个Python库,它可以帮助我们解析HTML页面,并且可以通过BeautifulSoup库提供的方法来获取我们需要的元素,并且可以通过BeautifulSoup库提供的方法来排除我们不需要的元素。比如,在爬取某个网站时,我们只关心标题和正文内容,而对于广告和导航栏并不感兴趣,这时候就可以使用BeautifulSoup库来过滤掉广告和导航栏。

5.使用Selenium模拟浏览器行为

有些网站会采用一些手段来防止被爬虫程序访问,比如设置验证码、限制IP访问频率等等。这时候就需要使用Selenium模拟浏览器行为来绕过这些限制。在使用Selenium模拟浏览器行为时,我们也可以通过Selenium提供的方法来获取我们需要的元素,并且可以通过Selenium提供的方法来排除我们不需要的元素。

6.使用代理IP池

有些网站会针对特定IP或者特定IP段进行限制或者封禁。这时候就需要使用代理IP池来绕过这些限制或者封禁。代理IP池是一个由多个代理IP组成的池子,在访问目标网站时随机选取一个代理IP进行访问。如果当前选取的代理IP被封禁或者访问速度较慢,则自动切换到下一个代理IP进行访问。

7.使用反反爬虫技术

有些网站会针对爬虫程序进行反爬虫处理。这时候就需要使用反反爬虫技术来绕过这些反爬虫处理。常见的反反爬虫技术包括:修改User-Agent、添加Referer、添加Cookie、添加请求头等等。

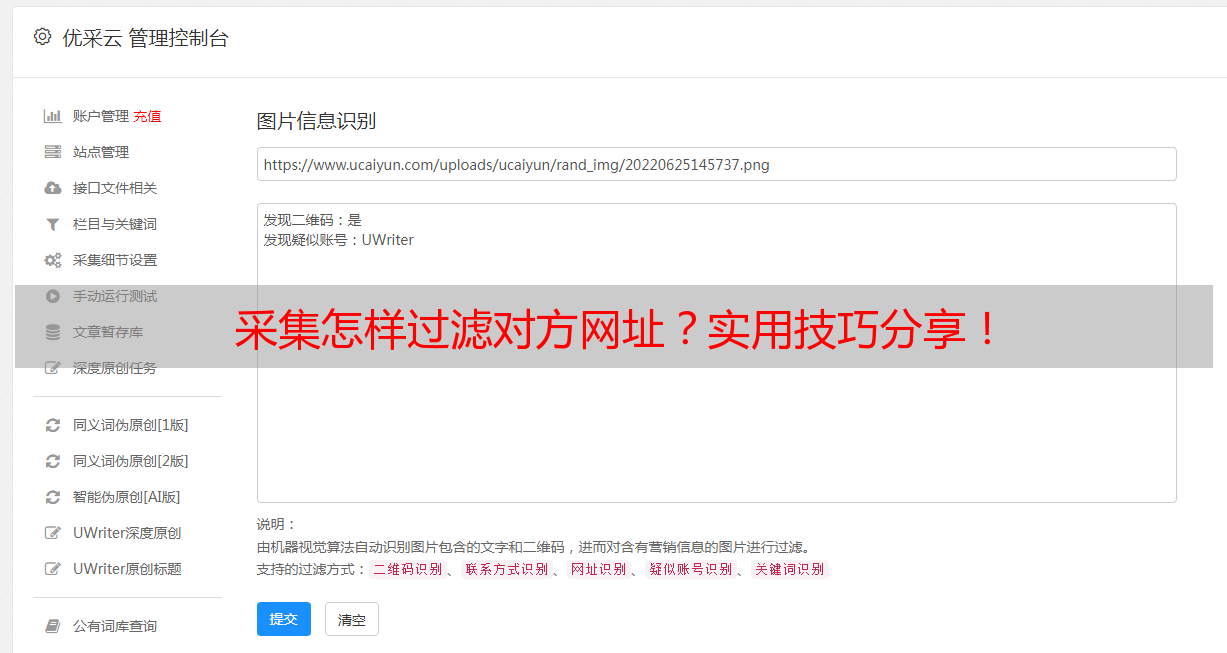

8.人工审核

在采集大量数据后,最好进行人工审核以确保数据质量。人工审核可以帮助我们发现一些自动化工具无法发现的问题,并且可以帮助我们修复数据错误。

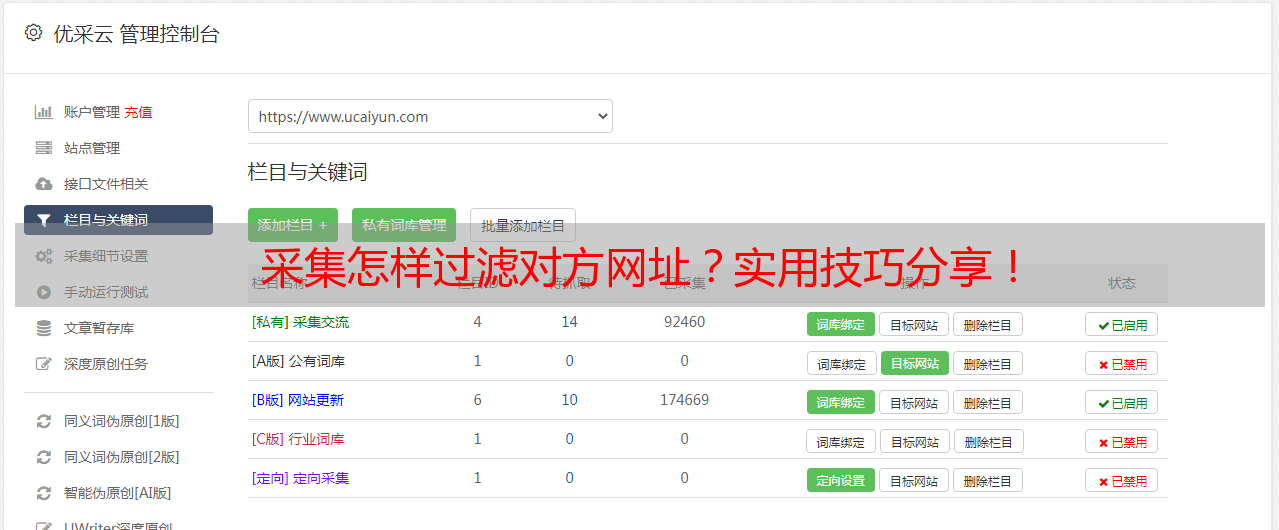

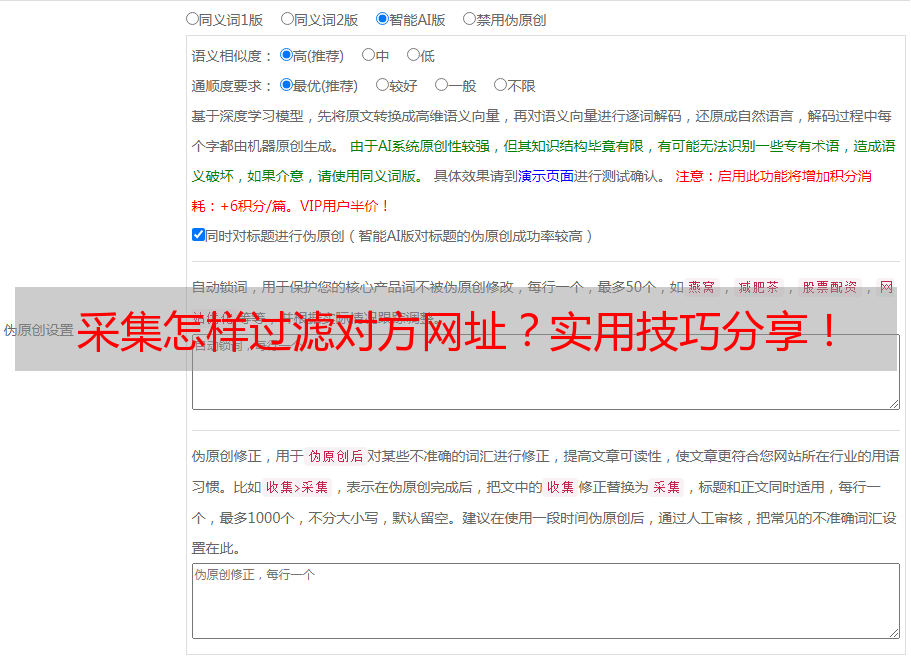

9.使用优采云进行SEO优化

优采云是一款专业SEO优化工具,在采集数据后可直接上传至优采云平台进行SEO优化操作,并可快速生成SEO报告以及实现SEO效果监测与调整工作。

总结:

以上9种方式都是非常有效地过滤掉对方网址的方法,在实际应用中可根据情况灵活运用。同时也要注意遵守网络安全法律法规以及尊重他人合法权益。