微博爬虫难以完全获取数据?8个方面剖析,解决方法一网打尽!

优采云 发布时间: 2023-03-07 07:10微博是一个信息丰富、互动性强的社交平台,各类用户在这里分享自己的生活、观点、情感等,形成了庞大的数据源。因此,微博数据的获取一直备受关注。然而,许多人在使用微博爬虫时发现,往往无法获取到全部的数据。究竟是什么原因导致了这种情况呢?本文将从以下8个方面进行分析讨论。

一、微博官方限制

微博作为一个商业公司,有着自己的利益考量。为了保护用户隐私和避免恶意行为,微博官方对数据获取做了一定限制。例如,对于同一IP地址或同一账号频繁访问、抓取数据超过限制等行为,微博会进行封禁或限制操作。这也是许多爬虫无法爬取全部数据的原因之一。

二、微博反爬策略

除了官方限制外,微博还采取了一系列反爬策略来防止恶意行为和非法抓取数据。例如,在网页源代码中加入特殊字符、对请求头进行检测等方式来识别是否为机器人行为,并对其进行限制或封禁。这些反爬策略也是影响爬虫正常工作和获取全部数据的重要因素。

三、数据量过大

由于微博用户众多、信息更新频繁,所以需要获取的数据量非常庞大。如果采用单线程或低效率的方法进行数据获取,则可能无法获取全部数据或耗费过长时间。

四、网络环境不稳定

网络环境不稳定也是影响微博爬虫正常工作的重要因素之一。例如,网络延迟高、服务器负载高等情况会导致部分请求失败或响应缓慢。

五、参数设置不当

在使用微博爬虫时,需要设置相应的参数来控制数据获取范围和速度。如果设置不当,则可能会导致无法获取全部数据或被封禁。因此,在使用微博爬虫时需要谨慎设置参数,并遵守相关规则和要求。

六、代码质量差

代码质量差也会影响微博爬虫的工作效果。例如,代码逻辑混乱、错误处理不当等都会导致程序运行异常或崩溃。因此,在编写微博爬虫代码时需要注意代码质量和可维护性。

七、更新维护不及时

由于微博反爬策略和页面结构等经常变化,所以需要及时更新维护微博爬虫代码。如果长时间没有更新维护,则可能无法适应新的页面结构和反爬策略而无法正常工作。

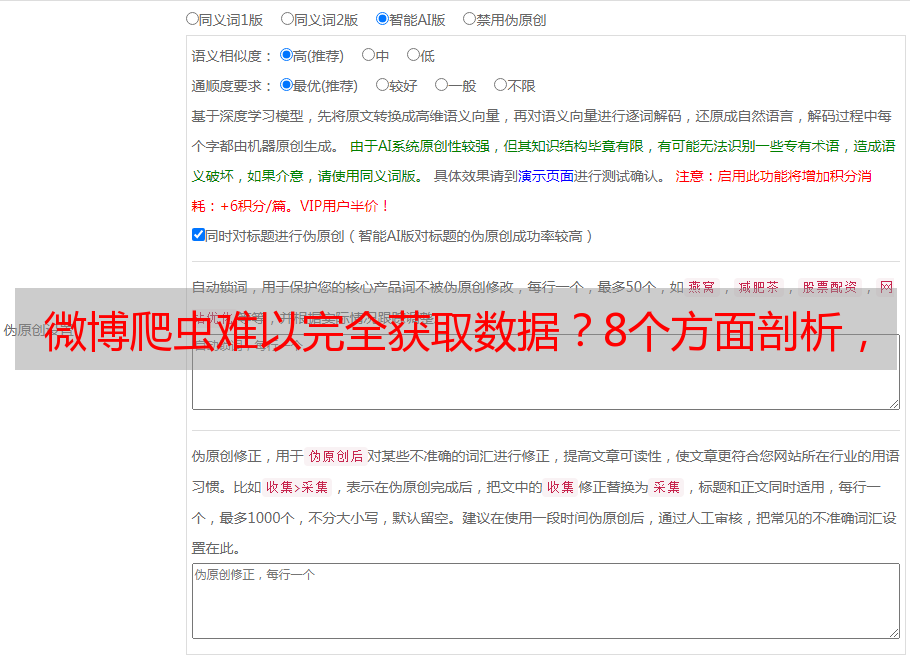

八、选择合适的工具

最后,在使用微博爬虫时需要选择合适的工具来进行开发和调试。目前市面上有许多优秀的开源框架和工具可供选择,如Scrapy, BeautifulSoup, Requests等等。选择合适的工具能够提高开发效率和降低出错率。

综上所述,造成微博爬虫无法完整获取数据有诸多原因,并非单一因素所致。在使用微博爬虫时需要注意以上8个方面,并遵守相关规则和要求才能顺利完成任务。