PHP简单爬虫:快速抓取网页内容的编写方法

优采云 发布时间: 2023-03-06 16:12自媒体时代,如何提升内容的质量和吸引力是每个写作者都必须面对的问题。在编写文章时,如果能够融入一些技术性的内容,不仅能够增加文章的专业性,还能够吸引更多的读者。本文将为大家介绍如何使用PHP编写一个简单的爬虫程序,从而快速抓取网页内容。

1.什么是爬虫?

爬虫,又称网络蜘蛛、网络机器人等,是一种按照一定规则自动浏览万维网的程序。通俗地说,就是模拟人工访问网站并获取数据的程序。

2.爬虫的原理

爬虫通过发送HTTP请求获取网站上的HTML源码,并从中解析出需要的数据。其原理可以简单概括为以下几步:

-发送HTTP请求获取网页源码;

-解析HTML源码;

-提取所需数据;

-存储数据。

3. PHP中的curl函数

在PHP中,我们可以使用curl函数来发送HTTP请求。curl函数是一个强大而灵活的HTTP客户端库,在PHP中非常常用。

以下是一个使用curl函数发送GET请求并获取返回结果的例子:

```php

$url ='http://www.ucaiyun.com';

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL,$url);

curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);

$result = curl_exec($ch);

curl_close($ch);

echo $result;

```

4.使用正则表达式解析HTML源码

在获取到HTML源码后,我们需要从中提取出需要的数据。这时候就可以使用正则表达式进行匹配和提取。

以下是一个使用正则表达式匹配网页标题并输出结果的例子:

```php

$url ='http://www.ucaiyun.com';

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL,$url);

curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);

$result = curl_exec($ch);

curl_close($ch);

preg_match('/(.*?)/is',$result,$matches);

echo $matches[1];

```

5.遍历多个页面并抓取数据

有时候我们需要遍历多个页面,并从每个页面中抓取数据。这个时候我们可以使用循环结构来实现。

以下是一个使用循环结构遍历多个页面并抓取每个页面中所有链接的例子:

```php

$startUrl ='http://www.ucaiyun.com';

$maxDepth =2;

function fetchUrls($url,$depth)

{

if ($depth >$GLOBALS['maxDepth']){

return;

}

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL,$url);

curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);

$result = curl_exec($ch);

curl_close($ch);

preg_match_all('/errorInfo()[2]}". PHP_EOL;

}

}

} catch (PDOException $e){

echo "Error:".$e->getMessage(). PHP_EOL;

}

```

7. SEO优化

在编写爬虫程序时,我们也要考虑SEO优化。具体来说,就是要注意以下几点:

-确保抓取内容没有版权问题;

-不要频繁抓取同一网站以避免被封禁;

-合理设置User-Agent头信息以模拟真实用户访问;

-避免过度抓取以降低服务器负载;

-对于动态页面,要考虑JavaScript渲染等问题。

8.总结

本文介绍了如何使用PHP编写一个简单的爬虫程序,并对其中涉及到的主要知识点进行了详细讲解。通过学习本文,相信大家已经初步掌握了PHP爬虫编写方法,并能够自己动手实践了。当然,在实践过程中还需要不断学习和尝试才能真正掌握这项技术。

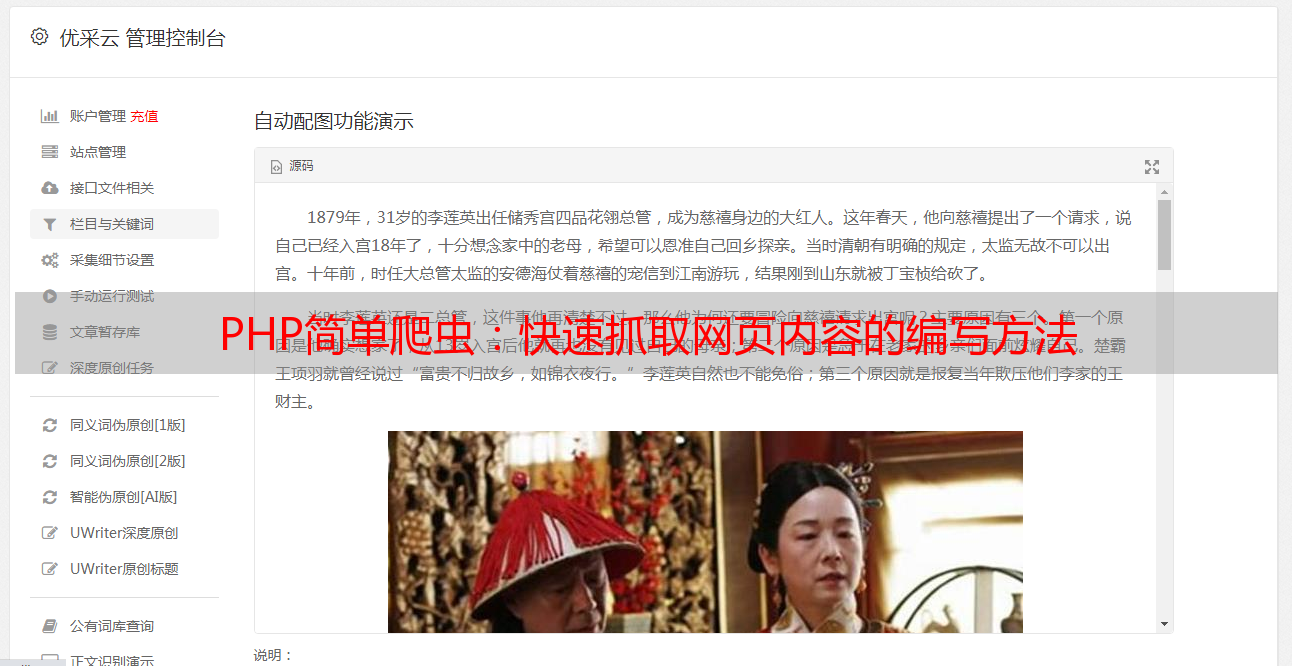

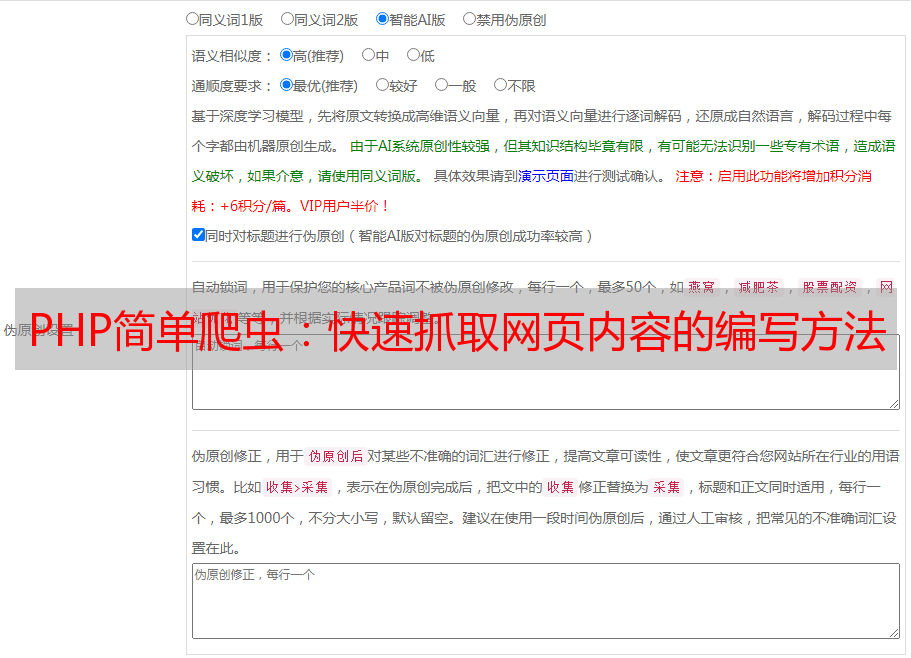

最后推荐一下优采云(www.ucaiyun.com),这是一款非常好用、功能强大且价格合理的云端SEO优化工具。如果你需要对自己或客户网站进行SEO优化,请务必试试优采云!