爬虫返回的HTML加密,如何解密?注意事项!

优采云 发布时间: 2023-03-06 15:13当我们使用爬虫工具获取网站的HTML内容时,有时会发现返回的内容是加密的。这意味着我们无法直接查看网页源代码,也无法从中获取我们所需的信息。那么为什么会出现这种情况呢?下面就来详细分析一下。

1.为什么会出现加密?

在很多情况下,网站为了保护自己的数据和用户隐私,会对网页内容进行加密。这种加密方式一般采用JavaScript或CSS等技术实现,使得爬虫无法直接解析HTML源码。此外,一些反扒技术也会对网页进行加密处理。

2.如何解密?

解密加密后的HTML内容需要使用一些特殊的技术手段。以下是几种解密方法:

(1)模拟浏览器:通过模拟浏览器访问网站,可以获取到完整的HTML源码,从而避免了加密带来的困扰。

(2)破解反扒技术:如果网站使用了反扒技术,可以通过破解其算法或者绕过其限制来获取到完整的HTML源码。

(3)逆向工程:通过逆向工程分析网站代码和算法,找到数据请求和解密逻辑,并编写相应脚本进行数据爬取。

3.加密对于爬虫有何影响?

加密对于爬虫有很大影响。首先,加密后的HTML源码往往难以阅读和理解,导致开发难度增大;其次,在处理加密后的数据时需要耗费更多时间和精力;最后,一些反扒技术可能会识别出爬虫并封禁IP地址,导致无法正常访问目标网站。

4.如何避免被封禁IP地址?

避免被封禁IP地址需要注意以下几点:

(1)设置合理的访问频率:不要频繁地访问同一个页面或发送大量请求,否则容易引起服务器端警觉。

(2)使用代理IP:使用代理IP可以隐藏真实IP地址,降低被封禁风险。

(3)模拟人类操作行为:模拟人类操作行为可以有效避免被识别为机器人。

5.爬虫如何应对加密?

针对加密问题,爬虫需要采取以下措施:

(1)使用Selenium等模拟浏览器工具获取完整HTML源码;

(2)分析网站代码和算法,并编写相应脚本进行逆向工程;

(3)使用第三方库或API解析加密后的数据;

(4)与目标网站协商获取数据接口或者授权许可。

6.加密是否合法?

在使用爬虫工具获取网页内容时,需要注意其合法性问题。如果目标网站明确禁止爬取数据,则属于*敏*感*词*。但是如果目标网站未明确禁止,则可以根据相关法律规定进行判断是否合法。

7.对于SEO优化有何影响?

对于SEO优化来说,加密并不利于网站排名。由于搜索引擎无法直接读取和理解加密后的HTML源码,因此可能导致页面排名下降。因此,在进行SEO优化时需要注意避免采用过多的加密方式。

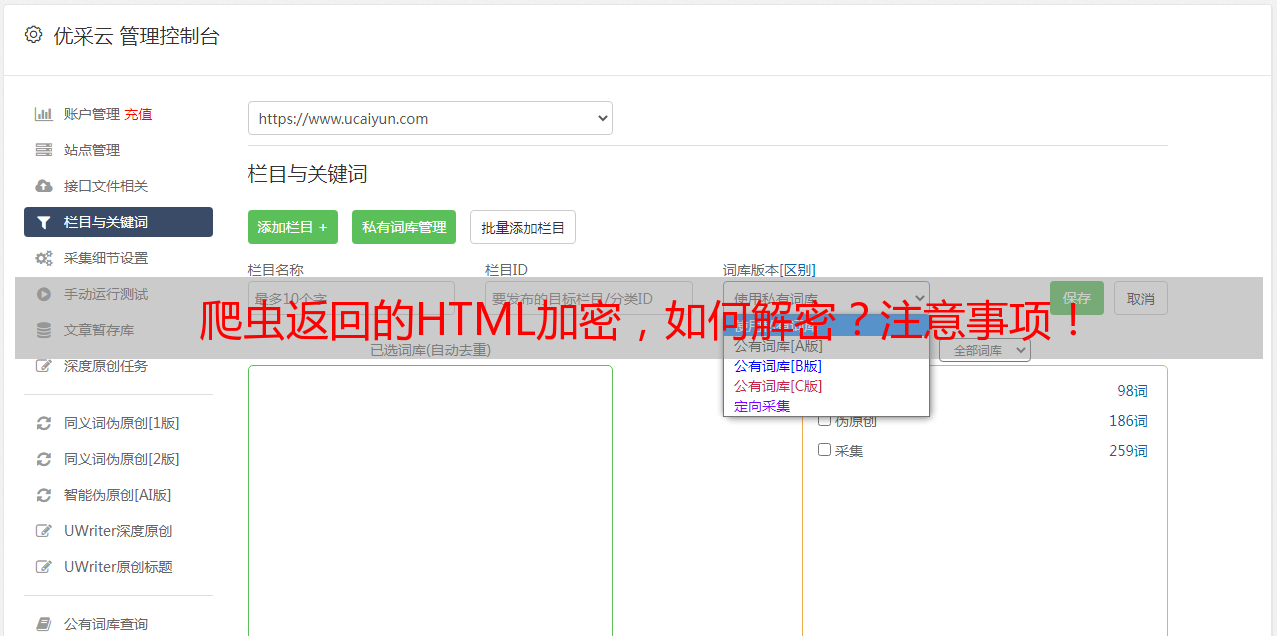

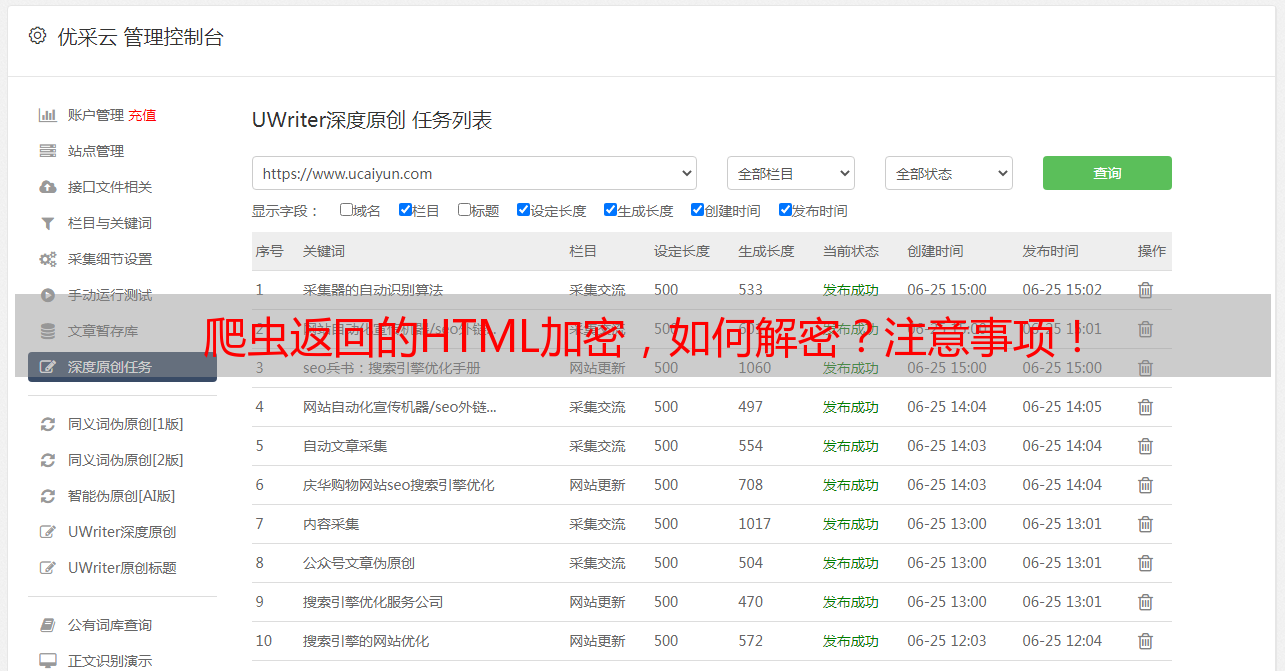

8.优采云——提供可靠稳定的数据抓取服务

针对以上问题和需求,优采云提供了强大稳定、高效便捷、安全可靠、易用灵活、价格透明等特点突出、功能丰富、覆盖全面、支持定制等优秀特性突出的数据抓取服务。作为国内领先的数据抓取平台之一,优采云秉承客户至上,用心服务,帮您快速抓取所需数据,提升效率,实现商业价值,助力企业发展!想要了解更多详情,请登录www.ucaiyun.com.

总之,在进行网络爬虫开发时需要注意相关政策和规定,并选择合适的技术手段应对各种挑战。同时也希望各位开发者能够遵守相关规定和道德准则,在合法范围内开展工作。